Pusa

세부 정보

파일 다운로드

모델 설명

Pusa는 LoRA 형식의 Wan 2.2용 미세 조정 모델로, 비디오 품질을 향상시킵니다.

요구 사항: Kijai WanWrapper 노드 https://github.com/kijai/ComfyUI-WanVideoWrapper

참고: 2025년 9월 3일 기준, ComfyUI는 어제 Pusa 노드를 업데이트했습니다. 이제 사용이 더 쉬워졌습니다.

하나의 모델로 다양한 작업을 처리, 모두 LightX2V를 사용한 4단계 추론 지원: 이미지-동영상, 시작-끝 프레임, 동영상 완성, 동영상 확장, 텍스트-동영상, 동영상 전환 등.

Wan 2.2 Pusa가 하는 일

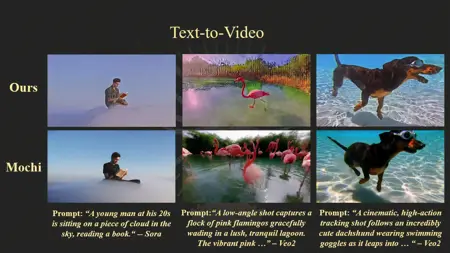

비디오 생성 작업: 텍스트-비디오, 이미지-비디오(정적 이미지를 움직이는 장면으로 변환), 비디오 확장, 전환, 시작 프레임과 종료 프레임을 매끄럽게 연결하는 등의 더 복잡한 작업을 수행할 수 있습니다.

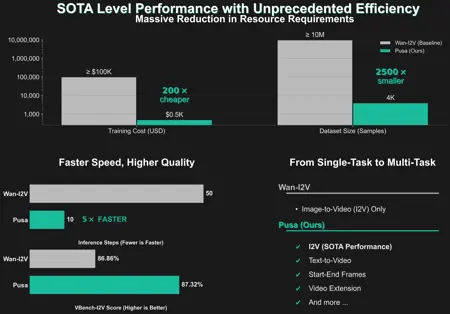

다중 입력, 다중 작업: 이전 모델들이 각 작업마다 별도의 모델이나 훈련이 필요했다면, Wan 2.2 Pusa의 독특한 설계(“Pusa 패러다임”)는 하나의 통합 시스템과 최소한의 추가 훈련만으로 다양한 비디오 작업을 일반화할 수 있습니다.

빠르고 효율적: “LightX2V” 가속과 “벡터화된 타임스텝 적응”(VTA) 덕분에, 매우 적은 추론 단계로 고화질 결과를 도출하며 비디오 생성에 필요한 컴퓨팅 자원과 시간을 크게 절감합니다.

어떻게 작동합니까?

벡터화된 타임스텝 적응(VTA): 핵심 혁신은 각 비디오 프레임에 여러 “타임스텝”을 사용하여 비디오 내에서 움직임과 전환을 독립적으로 조정할 수 있게 하는 것입니다. 이는 비디오의 각 부분이 맞춤화된 움직임으로 진화하도록 하여, 원본 비디오 모델의 기존 강점을 방해하지 않으면서 시간적 부드러움과 창의적 제어를 향상시킵니다.

전문가 혼합(MoE): Wan 2.2는 “고잡음”(복잡한 움직임)용과 “저잡음”(정적 세부 정보 보존)용 두 개의 전용 하위 모델을 사용하여, 각자의 강점을 결합해 더 나은 비디오 품질을 구현합니다.

LoRA 미세 조정: Pusa 모델은 가벼운 “정밀한” 적응 기법(LoRA)을 사용하여, 기초 모델이 이미 잘 수행하는 기능을 덮어쓰지 않고 이미지-비디오와 같은 새로운 기능을 주입합니다. 이는 텍스트-비디오 기능을 유지하면서도 새로운 기능을 효율적으로 추가합니다.

Wan 2.2 Pusa

https://github.com/Yaofang-Liu/Pusa-VidGen

https://huggingface.co/RaphaelLiu/Pusa-Wan2.2-V1

https://huggingface.co/Kijai/WanVideo_comfy/tree/main/Pusa

이들은 랭크 256 LoRA이며, 따라서 파일 크기가 매우 큽니다. 이 LoRA들은 Wan 2.2의 비디오/이미지 품질을 향상시키기 위해 설계되었습니다. 개인적으로 사용해보니 효과는 다소 미묘하지만 항상 비디오 품질을 개선합니다. NSFW 데이터로 훈련되었는지는 모르지만, NSFW 콘텐츠와도 잘 작동합니다.

작성자의 페이지에 따르면, 이 모델은 약 1.4–1.5의 가중치로 사용해야 합니다. LightX2V와 함께 4–8단계로 사용할 수 있으며, 일반적인 단계로도 사용 가능합니다.

작업 흐름 예시: /model/1923086?modelVersionId=2176586