Lora Lab: Press Start, Auto Gen, Auto Label, Auto Compile

详情

下载文件

模型描述

3 步自动 LoRA

设置你的批量数量,点击运行,生成数百张高分辨率图像并自动添加标题!

自动将它们存储在一个统一的文件夹中

将其输入 LoRA 训练器!

我推荐 Auto MED。完全自动化,无需手动打包,精度几乎无损失

Semi-Auto HI 适合愿意投入更多手动操作以换取轻微标题质量提升的用户

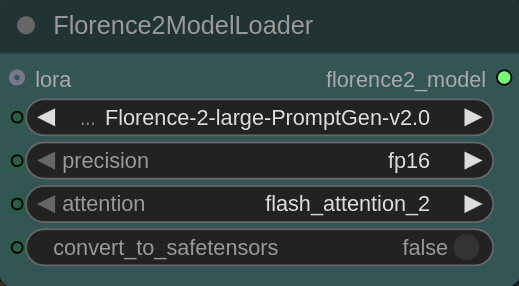

Auto LO 适用于低显存 GPU。需要加载一个 ksampler 模型和一个解释器模型(Florence-Basic 或 Large)

https://github.com/anyantudre/Florence-2-Vision-Language-Model

运行版本

**____________________**显存 ______精度_____ 手动工作量

Semi-Auto HI _________高_____________高______________ 高

Auto MED ____________高-___________高-_____________低

Auto LO ____________中__________中_____________低

SemiAuto HI: 双推理模型可提高提示的准确性,但需要手动整理文件夹并为每张图像选择最佳提示。使用双人脸精修器和基础精修模型,配合 4 倍超分,可实现高真实感与高精度。

Auto MED: 单推理模型支持自动编译,无需手动构建打包。但会轻微降低自动提示的准确性(在我看来并不明显)。使用双人脸精修器和基础精修模型,配合 4 倍超分,可实现高真实感与高精度。

Auto LO: 单推理模型支持自动编译,无需手动构建打包。但会轻微降低自动提示的准确性(在我看来并不明显)。不使用人脸精修器,仅使用 2 倍超分,生成中等真实感与精度。

填写提示桶时,请在逗号之间不要添加空格。

(trait1,trait2,trait3)

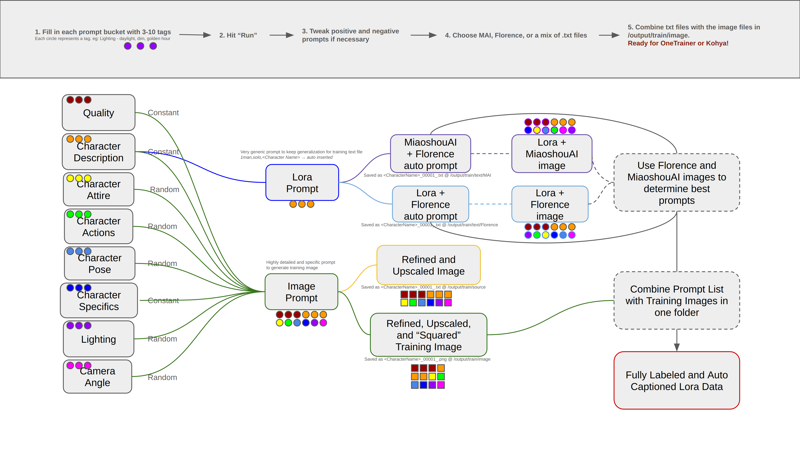

工作原理(Semi-Auto HI):

工作流逻辑

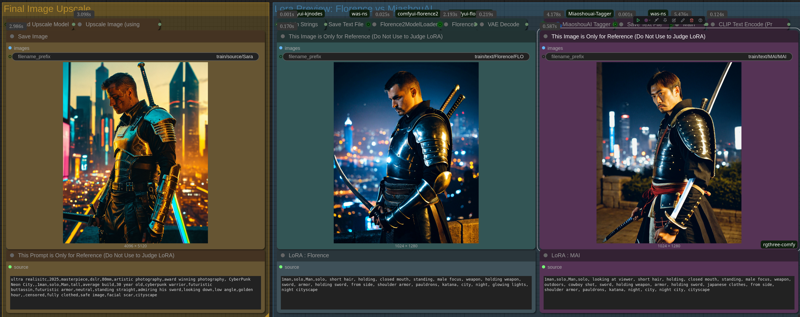

真实图像示例

工作流提示桶

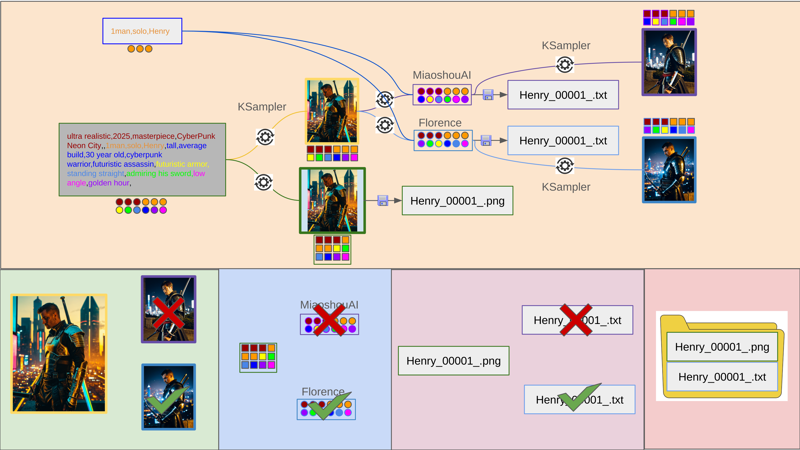

工作流结果 1(随机提示,随机方向,Florence 和 MAI 结果)

工作流结果 2(随机提示,随机方向,Florence 和 MAI 结果)

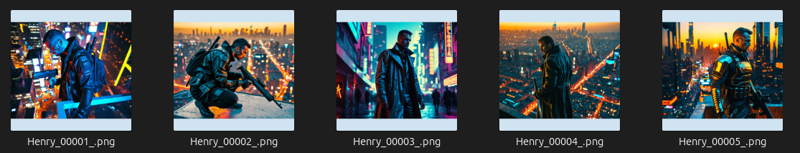

Henry 图像 + 最佳提示 = 自动 LoRA 数据

LoRA 训练图像保存于:/output/train/image/

LoRA 训练图像保存于:/output/train/image/

LoRA 文本保存于:/output/text/Florence 和 /output/text/MAI

超分图像保存于:/output/train/source/

系统规格:

此工作流默认为高显存配置

若有足够支持/需求,我将制作中显存和低显存版本

高显存:尽可能使用大型模型和 fp16/sdpa

低显存:尽可能使用基础模型和 fp8/闪存注意力,跳过精修器、超分和细节增强器(重新连接可能较复杂)

必备条件:

必需的自定义节点:rgthree、easy-use、impact pack、impact subpack、florence 2、MiaoshouAI、basic math、was ns、Crystools、kj nodes、StringOps(感谢开发者们!)

打开工作流时,ComfyUI-Manager 会提示你缺失节点。

点击“安装缺失节点”,重启 ComfyUI,刷新浏览器。

若仍有缺失节点,请在 Manager 窗口的“自定义节点”菜单中搜索安装。

我还必须安装闪存注意力(flash attention)。

最简单的方法是查看你的 CUDA 版本(在命令行运行 nvidia-smi),然后下载与之匹配的预编译 whl 文件:https://github.com/mjun0812/flash-attention-prebuild-wheels?tab=readme-ov-file