Wan2.2 16GB Training

详情

下载文件

关于此版本

模型描述

★使用16GB显存训练Wan2.2 LoRA

!!! 无需下载!这是一个技术展示!!!!

→→→原始/包含配置的训练数据集→→→ /model/1944129?modelVersionId=2200388

●与原始版本的区别:

4070 Ti Super 16GB / 内存 64GB

这是我第一次训练(真的第一次运行)

(替换 musubi_tuner_gui.py)(我忘了做这个,所以i2v无法工作)

t2v(未勾选 I2V 训练)

模型也从 i2v 改为 t2v

将其他模型的路径改为我的环境路径

dataset_bounce_test.toml 中的 video_directory 和 cache_directory

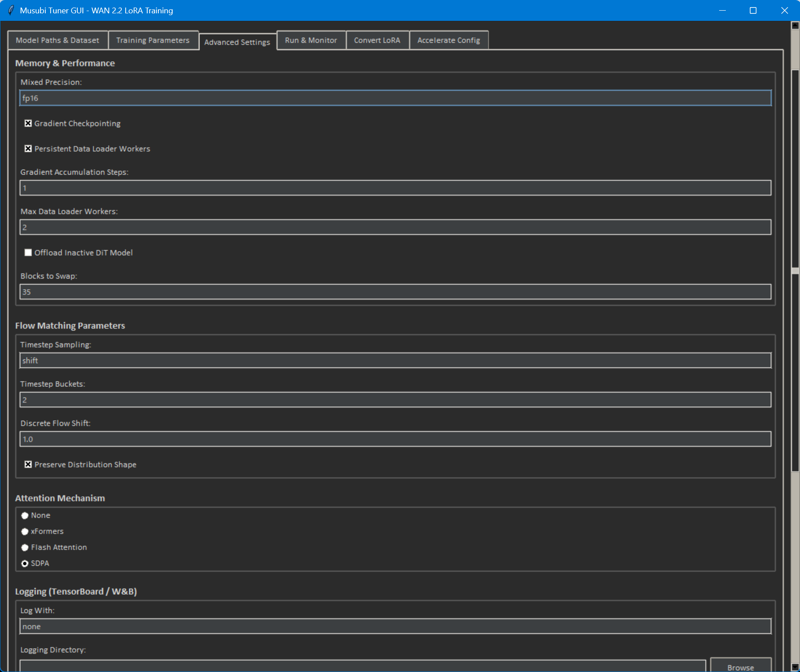

安装 Triton 和 Sageattention2(SDPA / 我不确定效果如何,但我觉得 Xformers 也会不错)

pip install -U "triton-windows<3.3"

python -s -m pip install .\triton-3.2.0-cp312-cp312-win_amd64.whl

→→→指南在此→→→https://civitai.com/articles/12848

- 可交换的模块数量(据我所知,此模型有40个模块)

35(原始为10)

●训练所需的显存

30% 的时间我使用了15GB,其余时间约为10GB。

在撰写本文时,我尝试设置为40,看是否能在12GB显存下训练,但出现了错误:

"AssertionError: 无法交换超过39个模块。请求交换40个模块。"

●训练所需内存

约使用了29GB系统内存。

因此我认为32GB应该刚刚足够。

●训练所需时间

最长耗时2小时19分钟,最短为2小时17分钟。

我训练了20个epoch,但前5个epoch才开始看到效果。

因此如果操作得当,我可以在一小时出头完成训练。(天哪,我简直不敢相信!)

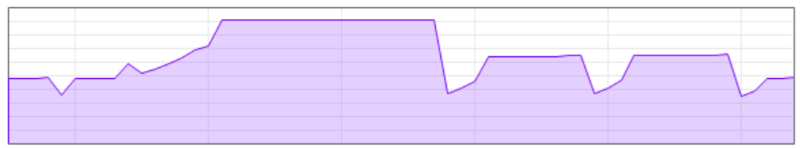

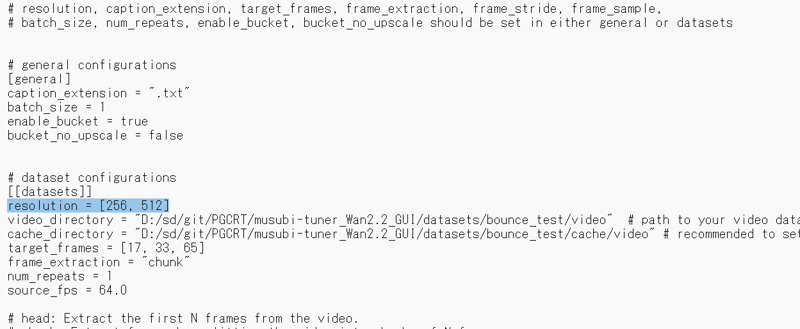

●训练分辨率(dataset_bounce_test.toml)

我认为模型会根据此配置学习,而非素材本身的分辨率。

resolution = [256, 512]

我刚意识到我不明白 "source_fps = 64.0" 是什么意思。

哦,原来原始视频确实是64FPS。

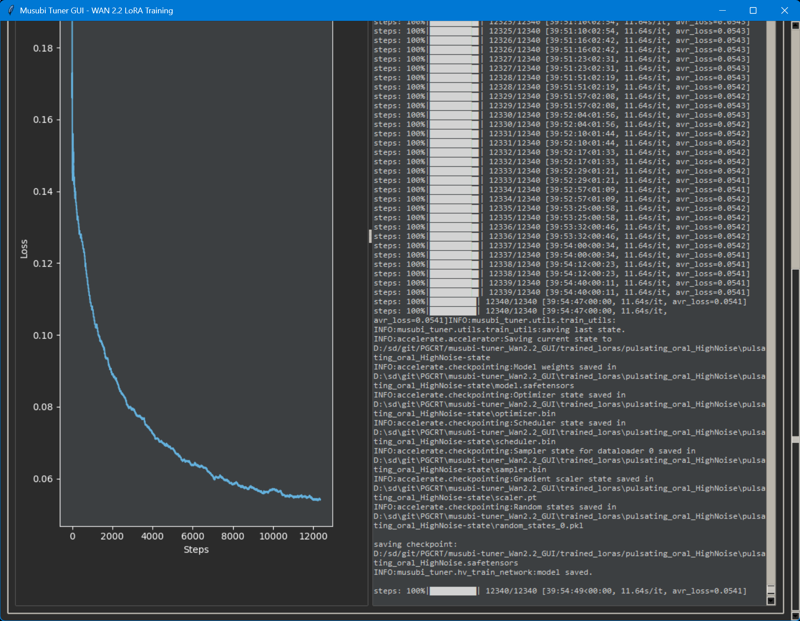

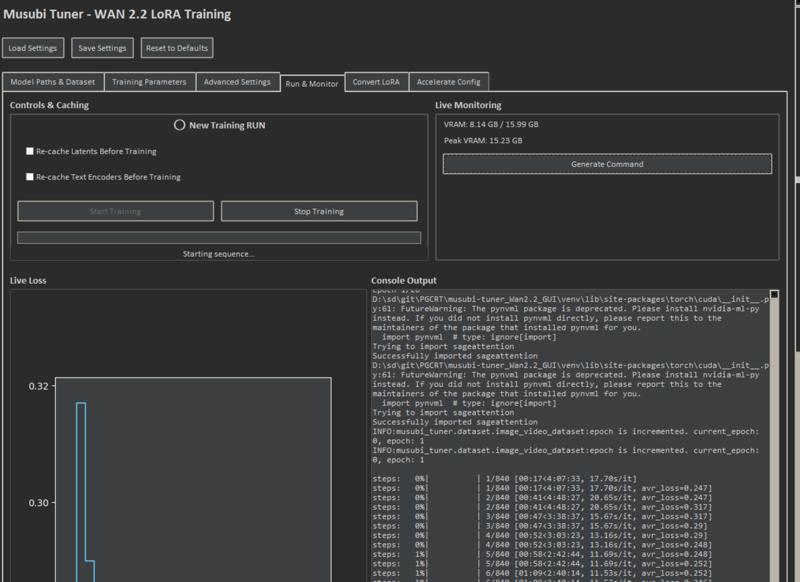

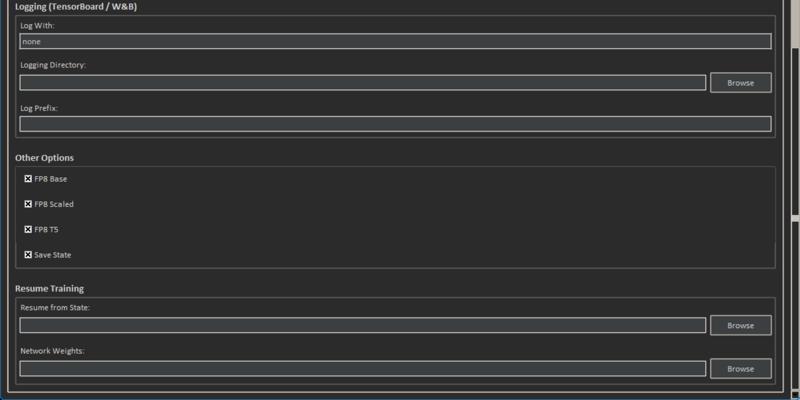

●训练界面

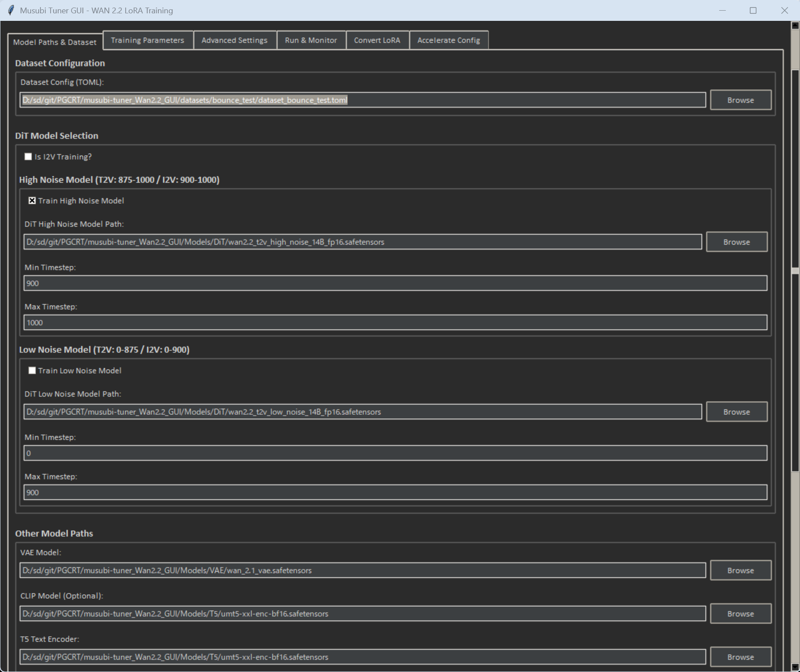

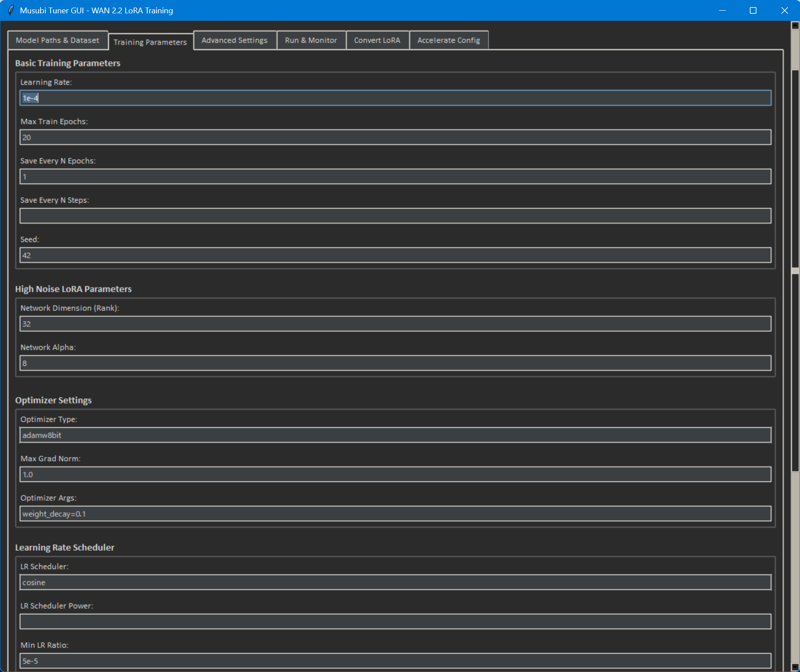

●配置

●软件及版本

PS D:\sd\git\PGCRT\musubi-tuner_Wan2.2_GUI\venv\Scripts> .\activate

(venv) PS D:\sd\git\PGCRT\musubi-tuner_Wan2.2_GUI\venv\Scripts> pip list

Package Version Editable project location

----------------------- ------------ ---------------------------------------

absl-py 2.3.1

accelerate 1.6.0

av 14.0.1

bitsandbytes 0.45.4

certifi 2025.8.3

charset-normalizer 3.4.3

colorama 0.4.6

contourpy 1.3.2

cycler 0.12.1

diffusers 0.32.1

easydict 1.13

einops 0.7.0

filelock 3.13.1

fonttools 4.60.0

fsspec 2024.6.1

ftfy 6.3.1

grpcio 1.75.0

huggingface-hub 0.34.3

idna 3.10

importlib_metadata 8.7.0

Jinja2 3.1.4

kiwisolver 1.4.9

Markdown 3.9

MarkupSafe 2.1.5

matplotlib 3.10.6

mpmath 1.3.0

musubi-tuner 0.1.0 D:\sd\git\PGCRT\musubi-tuner_Wan2.2_GUI

networkx 3.3

numpy 2.1.2

nvidia-ml-py 13.580.82

opencv-python 4.10.0.84

packaging 25.0

pillow 11.0.0

pip 22.2.1

protobuf 6.32.1

psutil 7.0.0

pynvml 13.0.1

pyparsing 3.2.4

python-dateutil 2.9.0.post0

PyYAML 6.0.2

regex 2025.9.1

requests 2.32.5

safetensors 0.4.5

sageattention 2.2.0

sentencepiece 0.2.0

setuptools 63.2.0

six 1.17.0

sympy 1.13.1

tensorboard 2.20.0

tensorboard-data-server 0.7.2

tokenizers 0.21.4

toml 0.10.2

torch 2.6.0+cu124

torchvision 0.21.0+cu124

tqdm 4.67.1

transformers 4.54.1

triton-windows 3.2.0.post19

typing_extensions 4.12.2

urllib3 2.5.0

voluptuous 0.15.2

wcwidth 0.2.13

Werkzeug 3.1.3

zipp 3.23.0

●需要多少视频片段?时长多长?

/model/1454728/blowjobs-man-in-frame

20个片段,每个3秒,16fps,512px×512px

/model/1962482/wan22-t2v-14b-prone-bone-sex

12个片段,时长3至6秒,RTX4080

/model/1954733/asshole-wan-22-t2vi2v-14b

259个512x512视频片段,每个3秒,单张5090

20个视频,每个3秒

/model/1953467/licking-breasts

23个视频,512×512,每个3秒

/model/1953632/reverseanalcowgirlwan22t2v14b

7个片段,每个约3-4秒,RTX 3090 和 32GB内存

/model/1343431/bouncing-boobs-wan-14b

7个视频,每个约4秒,4090,约35分钟完成

19个片段,每个5秒,16fps

21个片段,每个5秒,16fps

/model/1930239/missionary-anal-trans

20个片段,每个5秒,16fps

/model/1929589/kissing-tongue-action

25个片段,每个5秒,16fps

/model/1927742/side-sexspooning-trans

29个片段,每个3秒,16fps

10秒以上

/model/1927612/reverse-cowgirl-trans

41个片段,每个3秒,24fps(本应使用16fps),下次尝试

/model/1894970/wan-22-reverse-suspended-congress-i2vt2v

23个视频片段,每个3秒,主要为3D动画

/model/1869475/wan-22-anime-cumshot-aesthetics-precision-load-i2v-beta-version

39个原始动画片段,每段3秒,FPS: 16 ↑训练详情↑

/model/1944129/slop-bounce-wan-22-i2v

我3090上生成的7个旧AI视频 ↑训练数据包含↑

/model/1941041/facefuck-t2v-wan22-video-lora

12个片段,256x256像素,3至8秒

/model/1874811/ultimate-deepthroat-i2v-wan22-video-lora-k3nk

593个片段,不同分辨率,1至3秒

/model/1852647/m4crom4sti4-huge-natural-breasts-physics-wan22-video-lora-k3nk

数据集中889个片段,211个分辨率,1至3秒(部分源视频为16fps)

/model/1858645/facial-cumshot-wan-22-video-lora

307个片段,211分辨率,1至3秒

/model/1845306/sideview-deepthroat-wan22-video-lora

700个片段,不同分辨率,1至3秒

/model/1969272/4n4l-pl4y-i2v-anal-didlo-lora-wan22

98个片段,256x256分辨率,1至3秒

/model/1960102/self-nipple-sucking-lora-i2v-wan22-k3nk

319个片段,5种不同场景,不同分辨率,1至5秒,211分辨率

/model/1954774/cunnilingus-pussy-licking-lora-i2v-wan22-k3nk

121个片段,不同分辨率,1至5秒,256分辨率

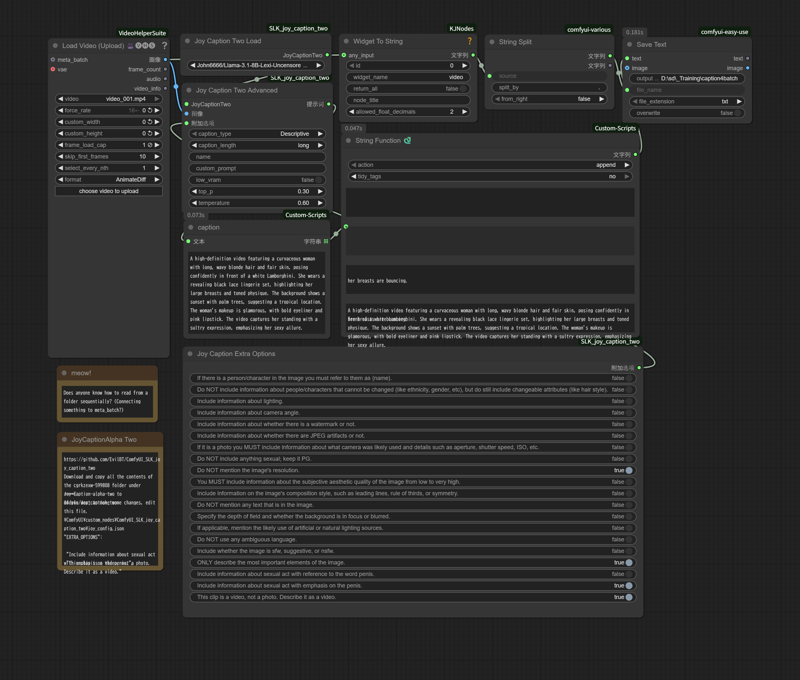

●从视频文件创建字幕(txt)(将一帧图像作为图片分析)

我认为这不是最聪明的做法,但我希望对某些人有帮助。

你可以下载该图片并拖入ComfyUI界面加载。

哎呀,我上传后工作流消失了。

字幕文本将保存为与视频文件同名。

●我尝试了下一次训练

32个视频,20个epoch,resolution = [512, 288],blockswap=36

但不知为何,生成了649个视频缓存,最终总步数达到12,340步……(耗时39小时54分钟 / 1个LoRA)