Kontext Multi-Input Edit - ControlNets and More

세부 정보

파일 다운로드

모델 설명

이 모델의 목적은 여러 입력 이미지를 사용하면서도 하나의 출력 이미지만 생성하도록 하는 것입니다. 이는 Qwen 이미지 편집과 유사하지만 Kontext용으로 설계되었습니다. 입력 이미지를 참조할 때 "image1"과 "image2"라는 키워드를 사용합니다.

아래는 프롬프트 작성 방식을 이해하는 데 도움이 되는 학습 데이터의 몇 가지 예시입니다:

예시 1:

입력:

프롬프트:

image1의 남자를 image2의 자세로 이동시켜: 허리 곧게 펴고, 발은 골반 폭만큼 벌리고, 손은 앞에서 꼭 잡고, 머리는 왼쪽으로 약간 기울이며, 동일한 중성적인 조명과 베이지색 애슬레저 복장 유지.

출력:

예시 2:

입력:

프롬프트:

image2의 남자를 image1의 OpenPose에 포착된 부드럽고 와인을 따르는 순간으로 옮겨: 허리 위까지 자르고, 몸을 약간 왼쪽으로 기울이며, 정사각형 와인 병을 잔 위로 들어 올려 황금빛 와인이 흐르게 하고, 시선은 와인에 집중된 태도로 유지하세요. 그의 매트한 선글라스, 깔끔하게 정돈된 수염, 맞춤형 검은 조끼와 넥타이, 은색 시계, 풍부한 위스키 색조, 그리고 단일 방향의 어두운 스튜디오 조명을 그대로 유지하고, image1의 OpenPose와 정확히 일치하도록 완전한 팔 동작을 정교한 바텐더 액션에 자연스럽게 결합한 선명한 초상화를 생성하세요.

출력:

예시 3:

입력:

프롬프트:

image1의 크림-하얀 정장과 분홍색 니트 넥타이를 입은 남자를 동일한 돌담 배경, 동일한 조명과 프레임으로 유지하되, image2에 보이는 기쁨에 차서 양손을 위로 치켜든 자세를 채택하세요. 손바닥은 열고 머리 높이에 수평으로, 손가락은 벌리고, image1의 정확한 미소, 복장, 배경 및 색상 팔레트를 그대로 유지하세요.

출력:

지침:

입력 이미지는 수직 이미지인 경우 옆으로 나란히, 수평 이미지인 경우 위아래로 연결하여 입력해야 합니다. 정사각형 이미지의 경우 양쪽 방식 모두 학습되었습니다.

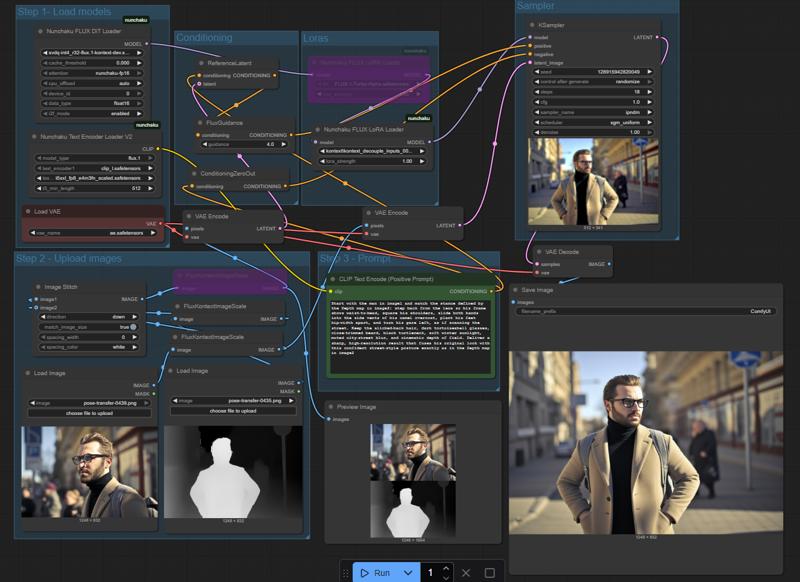

아래는 입력을 어떻게 형식화해야 하는지 보여주는 내 작업 흐름 스크린샷입니다:

이 모델은 주로 인물을 대상으로 학습되었지만 다양한 주제를 처리할 수 있습니다. Canny, Depth, OpenPose를 ControlNet용으로 학습했으며, ControlNet 없이도 이미지 간 편집(예: 캐릭터 교체, 배경 변경, 자세 직접 전달 등)을 수행하도록 학습되었습니다.

현재까지 Depth가 가장 효과적이며, OpenPose도 일반적으로 잘 작동하지만, Canny는 다소 성과가 떨어졌습니다. 이는 향후 릴리즈에서 수정할 계획입니다.

이 LoRA는 아직 약간 부족하게 학습되었으며, 더 나은 데이터셋을 확보한 후 더 높은 스텝 수로 다시 학습할 계획입니다. 그전에 여러분의 피드백을 기다리고 있습니다.