Kontext Multi-Input Edit - ControlNets and More

詳細

ファイルをダウンロード

モデル説明

このモデルの目的は、複数の入力画像を使用しながら、1つの出力画像のみを生成できるようにすることです。Qwen Image Edit と同様に機能しますが、Kontext用に最適化されています。入力画像を参照するために、「image1」と「image2」というキーワードを使用します。

以下に、プロンプトの理解を助けるためのトレーニングデータからの一部の例を示します。

例1:

入力:

プロンプト:

image1 の男性を image2 の姿勢に移動させる:背筋を伸ばして立ち、足は腰幅に開き、手は前で組み、頭は左に傾け、同じ中性の照明とベージュのアスレジャー衣装を維持する。

出力:

例2:

入力:

プロンプト:

image2 の男性を、image1 の OpenPose で捉えられた滑らかな注ぎかけの瞬間に移動させる:ウエスト以上をクロップし、体をやや左に傾け、四角いデカンタをグラスよりも高く持ち上げ、金色の液体の流れを生み出し、彼の視線をワインに集中して追わせる。彼のマットなサングラス、完璧に手入れされたひげ、仕立ての良いブラックのベストとネクタイ、シルバーの時計、豊かなウィスキーの色調、そして陰影のある片方向のスタジオ照明を維持し、image1 の OpenPose に正確に従って、彼の全身を活かした華麗な動作を洗練されたバーテンダーの行動に融合させたシャープなポートレートを作成する。

出力:

例3:

入力:

プロンプト:

image1 のクリームホワイトのスーツとピンクのニットネクタイを着た男性を、同じ石壁の背景、同じ照明と構図で、image2 に示された喜びに満ちた両手を高く掲げるポーズに変える。手のひらは頭の高さで開き、指は広げたまま、image1 からの正確な笑顔、衣装、背景、カラーパレットを維持する。

出力:

指示:

入力画像は、縦向きの画像の場合は横並びに、横向きの画像の場合は上下に結合して入力してください。正方形の画像については、どちらの方法でも学習されています。

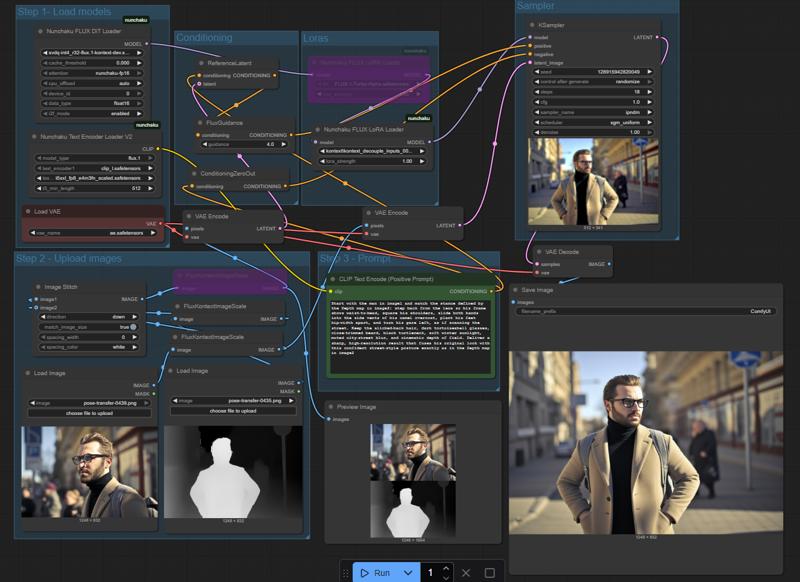

以下は、私が使用しているワークフローのスクリーンショットで、入力のフォーマット方法を確認できます:

このモデルは主に人物に対して学習されていますが、さまざまな被写体に対応可能です。Canny、Depth、OpenPose を ControlNet として学習しましたが、ControlNet を使用せずに画像間での編集(キャラクターの交換、背景の変更、ポーズの直接転送など)にも対応しています。

現在、Depth が最も優れた結果を出しており、OpenPose も一般的に良好ですが、Canny はやや未熟です。これは今後のリリースで修正する予定です。

この LoRA はまだやや学習不足であり、より良いデータセットを構築してから、ステップ数を増やして再学習する予定です。その間、ご意見やフィードバックをいただけますと幸いです。