Max quality QWEN Edit 2509 outputs, minimal workflow, and lots of info

详情

下载文件

模型描述

重要:

如果你是新手,请从 qwedit_simple 工作流开始。 在你了解单图工作流如何运作之前,不要使用多图工作流。

更新

本部分用于记录版本更新。主帖位于更新部分下方。我尚未更新主帖——目前新信息仅在此更新部分中。

更新 2025-10-14:多图工作流

原始帖子位于下方。我新增了两张图和三张图的两个新工作流。由于要找到最佳实现方式较为复杂,且我过去一周在现实生活中非常忙碌,因此花费了些时间。但现在,它来了!请尽情使用!

本更新部分中还包含关于新型 Lightning LoRA 等的额外说明。剧透:它们很糟糕 :(

-- 使用说明 --

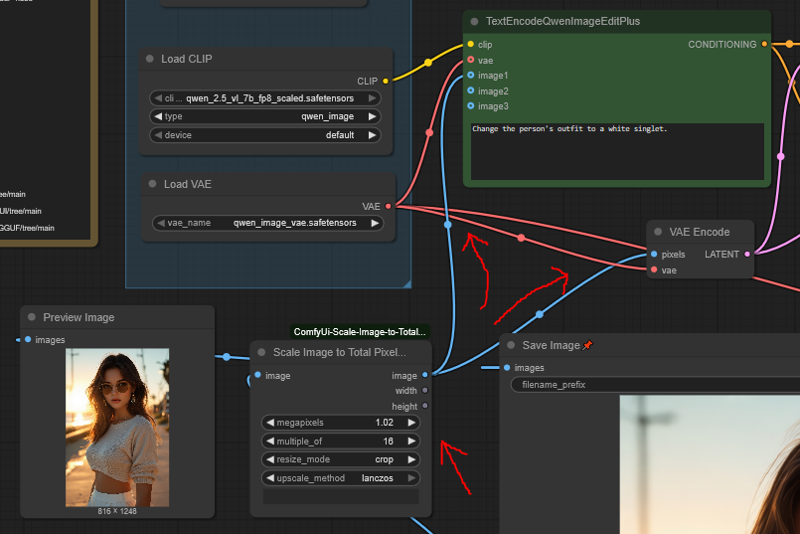

** spaghetti(杂乱连线):** 工作流连接看起来像意大利面,因为每个参考图都会添加多个节点并与其他节点交叉连接。它们仍然简单,但不再美观。

顺序: 输入图像时,图像一在右侧。因此请从右至左添加图像。它们也有标签标注。

使用正确的工作流: 由于额外节点的存在,若不正确地“绕过”第三或第二张图像,很容易出错。我建议直接分别使用这三个独立工作流,而不是试图在一个工作流中灵活处理全部三个。

多图生成速度极慢: 质量为最大,但两张图的生成耗时是单图的3倍,三张图的生成耗时是单图的5倍。

这是因为在 QWEN 编辑中,每使用一张图像,时间就会乘以1倍,而此工作流每次实际上增加了两张新图像(归功于参考潜变量)。

如果你使用 QWEN 编辑但不使用参考潜变量节点,则多图生成耗时为2倍和3倍,因为图像仅被添加一次——但质量会变得模糊,这是代价。

注意:这仅是多图工作流的问题;单图的 qwedit_simple 工作流与普通 Qwen 编辑速度相同。

缩放: 参考图像的缩放要求不那么严格。你可以放大或缩小它们。放大将使生成变慢,缩小则加快生成。

- 确保主图像按正常比例缩放,但如果你是高级用户,可以任意缩放第一张图像,并将手动尺寸的输出潜变量输入到 k-sampler 中(详见下方“高级质量”部分)。

新增可选“Consistence” LoRA: Reddit 上的 u/Adventurous-Bit-5989 建议了这个 LoRA。

链接:这里,工作流中也已链接。

我发现它能略微更好地保留细节(例如微小的面部细节,如唇部纹理)。

它也增加了随机特征被传递的可能性,例如衣服上的徽标会转移到新衣服上。

但同时,它有时也会随机轻微降低图像其他部分的质量,例如与不使用 LoRA 相比,它可能无法准确保留人物腿部的形状。

并且它会降低模型的创造力;有时你将得不到那么“有趣”的输出。

因此,这是一个权衡:如果你想保留更多精细细节,它很有用;否则不推荐。

请遵循其 CivitAI 页面的说明,但注意:即使他们声称你需要,你实际上并不需要他们的工作流。

-- 其他说明 --

新的 2509 Lightning LoRA

结论:它们很糟糕(截至今天,2025-10-14)

在质量上几乎与其他 LoRA 相同

有些人甚至说它们比其他 LoRA 更差

基本上,除非你想要更低的质量和更低的提示遵循度,否则不要使用它们

它们甚至不能作为“测试”工具,因为它们有一半时间给出的结果与正常模型完全不同

建议:当你想以更快速度“测试”时,将此工作流(不使用 LoRA)设为10步,然后在需要高质量时恢复为20步

一些人声称已修复偏移问题

也许他们修好了,也许没有——我不知道,因为他们都没有提供任何示例或证据

在有人真正证明之前,请认为该问题仍未修复

如果有人 convincingly 解决了,我会更新此处及我的 Reddit 帖子

-- 更新部分结束 --

这是什么?

目前,没有任何工作流能以基础配置输出 2509 模型的最高质量结果。此工作流配置可生成几乎与官方 QWEN 聊天版完全一致的结果。

此外,所有其他工作流都非常复杂;而这个工作流极其简洁,仅包含绝对最少的设置。这意味着你可以将其作为简易入门起点,进行扩展,或将其整合到其他复杂工作流中以获得其优势。

因此,总结来说,此工作流提供两个不同功能:

最高质量 2509 输出的配置,你可以复制到任何地方使用

一个超级简单的基础工作流,无任何多余配置

下方还有大量关于模型及使用方法的信息。

此工作流包含什么?

极简工作流,节点与设置最少

提供目前已知的 2509 模型所能达到的最高质量输出

仅需一个自定义节点:ComfyUi-Scale-Image-to-Total-Pixels-Advanced

- 如果你想运行 GGUF 版本的模型,还需另一个自定义节点

模型下载链接

你需要的一切都在这里。这些链接也在工作流中提供。

QWEN Edit 2509 FP8(需要 22.5GB 显存):

GGUF 版本(适用于低显存):

https://huggingface.co/QuantStack/Qwen-Image-Edit-2509-GGUF/tree/main

需要 ComfyUI-GGUF,使用“Unet Loader”节点加载模型

注意:GGUF 版本运行速度较慢,且质量低于 FP8(除可能的 Q8 外)

文本编码器:

通常不建议使用 GGUF 版本,可能会产生奇怪效果

VAE:

参考图链接

猫: freepik

赛博朋克调酒师女孩: civitai

穿衬衫和裙子的随机女孩: 未上传至任何平台,仅为示例生成

快速使用指南

确保你已将 ComfyUI 更新至最新版本;QWEN 文本编码器节点在 2509 模型发布时已更新

输入任意尺寸图像,图像缩放节点会自动调整大小

图像尺寸等于或大于 1MP 为最佳

你可以通过工作流中的图像缩放节点判断:理想情况下,它应该缩小而非放大你的图像

你可以使用奇怪的宽高比,无需“正常”。若宽高比超过 16:9 或 9:16,可能会出现异常结果,但有时仍能工作

不要随意改动配置细节,这完全是经过精心设计的

参考图像输入、清零、k-sampler 设置和输入图像缩放才是关键;请勿改动

你可以将 k-sampler 步数设为 10 以加速生成,或设为 30 以获得更高质量(但速度更慢)

你可以使用 GGUF 版本以降低显存需求,只需获取 ComfyUI-GGUF 自定义节点,并使用“UnetLoader”节点加载模型

- 此工作流默认使用 FP8,需要 22.5GB 显存

不要使用 Lightning LoRA,它们对 2509 来说完全是垃圾

它们技术上能运行,但会消除 2509 模型带来的大量改进,因此你实际上并未真正使用 2509 模型

例如,2509 能生成 NSFW 内容,但 Lightning LoRA 在这方面表现极差

如果你让 2509 去除一个人的衣服,它会直接做到;而 Lightning LoRA 会说:“呃,老板,这好像有点难…”

另一个例子:2509 具有极强的提示遵循能力;而 Lightning LoRA 会破坏这一点,迫使你必须生成大量次数才能得到理想结果

此工作流仅有一个参考图像输入,但你可以添加更多——只需在链中添加另一个 ReferenceLatent 节点,并连接另一个 ScaleImageToPixelsAdv 节点即可

我仅测试了最多两张参考图,但效果良好

如果你尝试超过两张时遇到问题,请告诉我

如果你需要,我可以提供一个连接更多参考图的工作流

你可以输出任意尺寸图像,只需将任意大小的空潜变量输入到 k-sampler 中即可

如果你正在生成一张新图像(即:向 k-sampler 输入特定尺寸,或使用多张参考图像),你的参考图像可以大于 1MP,这确实能提升结果质量

如果你想更进一步,可以输入一张 2MP 的人物图像,再将其面部转移到另一张图像上,结果的保真度会更高

是的,真的有效

唯一缺点是模型运行时间随参考图像尺寸成比例增长,因此建议参考图像保持在 1.5MP 至 2MP 之间(超过此尺寸无额外保真度提升)

更多细节请参见下方“高级质量”部分

关于 NSFW(成人内容)

这个问题经常被问到,这里简单说明。本部分我会尽量简短,因为它并非帖子主旨。

2509 模型具有极强的提示遵循能力,完全不在乎道德约束。它可以且会执行你要求的任何操作,但请注意它并未在所有内容上进行训练。

它不知道如何绘制生殖器,因此你可能会看到模糊的色块或“肯娃娃”式的模糊效果。

- 但如果你提供类似角度的参考图像,它可以正确绘制出来。这是一个使用裸体参考图像生成的全新画面示例(NSFW):https://files.catbox.moe/lvq78n.png

它对胸部(包括乳头)表现良好,但如果原图中胸部裸露,有时会保持不了与原图一致的尺寸。不过你也可能运气好。

如果胸部被衣物覆盖,它会保持尺寸一致。因此,如果你想保持一致性,建议先将人物换上比基尼,再进行编辑。

它不认识大多数内衣款式,但会礼貌地给你普通内裤,以免浪费你的时间。

它非常适合作为进一步编辑的起点。与其用普通模型痛苦地手动修改,不如先用 2509 将人物调整到你想要的着装状态,再用其他模型添加细节。这对快速编辑或制作衣服试穿用的人体模型非常方便。

95% 情况下有效的提示词

完全脱光 —— 非常适合作为用其他模型细化的起点,或当你只需要最基础的裸体用于服装建模时。

Remove all of the person's clothing. Make it so the person is wearing nothing.

脱光,仅保留最小化内裤。

Change the person's outfit to a lingerie thong and no bra.

比基尼 —— 这是最理想的提示,能在最大程度脱衣的同时保持所有身体比例并正确绘制。非常适合将人物变为人台以试穿其他服装,这是一个非常酷的用途。

Change the person's outfit to a thong bikini.

使用这些提示的输出结果:

🚨NSFW 链接🚨 https://ibb.co/V005M1BP 🚨NSFW 链接🚨

我会尝试将这些示例上传到图片库,这样你就不必跳转外部链接查看,但我不确定是否因涉及多个提示(我在正面提示中加了“various”)而受影响。

此外,无需多言:未经他人同意,切勿篡改真实人物的照片。普通扩散模型已经够难控制了,但像QWEN和Nano Banana这样的工具大大降低了入门门槛,这必将演变成一个大问题,最好别让自己卷入其中。

关于QWEN Edit的完整说明与常见问题解答

由于某些我无法完全解释的原因,这一特定配置能产生最高质量的结果,且效果非常明显。不过,我可以解释其中一部分,并在下文说明。为简便起见,本文后续将QWEN Edit 2509简称为“Qwedit”。

参考图像与Qwen文本编码器节点

Comfy自带的TextEncodeQwenImageEditPlus节点效果极差,因为它以最糟糕的方式盲目缩放图像。

但你仍需使用它;完全绕过它(虽然可行)会导致结果质量一般。

通过使用ReferenceLatent节点,我们可以将参考图像提供给Qwedit两次,其中第二次以非垃圾级的尺度缩放。

接着,通过将原始条件(conditioning)置零,并将该置零结果输入ksampler的负向提示中,我们可以抑制模型使用Comfy节点缩放的劣质图像,转而使用我们精心缩放的高质量版本。

注意:你必须将真实文本编码器的条件输入传递至置零环节。

尽管听起来像是“清零”了所有内容,但实际上仍会向ksampler传递大量信息。

因此,切勿向置零环节输入任何随机垃圾;你必须传入来自Qwen文本编码器节点的条件信息。

这是本工作流能产生优质结果的80%关键,若你只复制一部分,务必复制这一部分。

图像缩放

这里用到了唯一必需的自定义节点。

大多数工作流使用普通的ScaleImageToPixels节点,这是最烂、最差劲的节点之一,应从ComfyUI中删除。

该节点盲目地将所有图像缩放至1MP,完全无视所有扩散模型均以2、4、8或16的倍数运行这一基本事实。

将我的图像缩放为1177x891?好的哥们,完美契合我的Stable Diffusion模型。

这里引入ScaleImageToPixelsAdv节点。

这个神级节点不仅能将图像缩放到指定像素,还能确保其为指定数值的整数倍。

然而,缩放到1MP只是问题的一半;你将注意到本工作流实际设置为1.02MP。

这是因为TextEncodeQwenImageEditPlus会再次对图像进行缩放,使用前述的垃圾方式。

通过先缩放到1.02MP,至少迫使它进行的是下采样而非上采样,从而大幅减少结果中的模糊现象。

此外,ScaleImageToPixelsAdv会向下取整,因此若图像不能被16整除,最终尺寸会略小于1MP;而使用1.02MP则更接近该节点真实所需的1MP尺寸。

值得一提的是,Qwedit能稳定处理0.5MP到1.1MP之间的图像,因此将略大于1MP的图像传入ksampler也完全没问题。

能被16整除的尺寸效果最佳,别理那些说什么“56或112倍数”的人(原因见下文)。

使用“裁剪”而非“拉伸”,因为后者会扭曲图像,相信我,为保持高质量而牺牲10像素是值得的。

图像偏移问题——不,你无法修复它,任何声称能解决的人都是在撒谎

偏移问题指的是编辑后图像中的物体发生轻微(或显著)位移,偏离了预期位置。

本工作流能将偏移问题的发生率降至最低。

- 是的,比所有那些所谓的“56或112倍数”修复方案更低。

“56或112倍数”理论之所以无效,原因有二:

1. 这并非问题的全部根源;Qwedit模型只是随机地、毫无规律地做这种偏移,你根本无法控制。

2. 模型架构决定了,即便你将图像设为112的倍数也毫无意义——因为根本不存在一个恰好是112倍数的1MP图像尺寸;你的图像最终仍会被缩放到非112倍数的尺寸,然后你只能哭。

认真说,你无法修复这个问题——你只能降低其发生的概率,而本工作流已经尽可能做到了极致。

本工作流如何真正降低图像偏移问题?

因为90%的问题源于图像缩放。

将图像缩放到1.02MP并确保为16的倍数,能让你最接近Qwedit实际希望处理的分辨率。

不信?去官方Qwen聊天界面,上传几张不同比例的图像试试。

当它返回编辑结果时,你会发现这些图像都被缩放成了1MP且能被16整除——正如同ScaleImageToPixelsAdv节点所做的那样。

因此,Qwedit的理想图像尺寸为:1248x832、832x1248、1024x1024。

注意,非正方形尺寸的高略大于传统Stable Diffusion的尺寸。

- 不过不用紧张,本工作流对任何合理宽高比都能良好支持。

剩余10%的问题源于Qwedit内部某些诡异机制(至今无人能解决)。

甚至对完美的1024x1024图像,它有时也会出现偏移。所以,若有人声称“解决了”这个问题,你完全可以合法地扇他一耳光。

值得注意的是,你输入的提示词本身也会影响这个问题。如果某张图出现偏移,可以尝试略微重写提示词,或许能改善。

闪电LoRA,为什么不用?

简而言之,如果你使用闪电LoRA,输出质量将退化回Qwedit最初版本,完全错过2509版的所有改进。

它们对提示词的遵循能力远不如2509。

它们在处理NSFW内容时表现不佳。

它们生成的细节更差。

当你的宽高比“不标准”时,它们更容易出错。

它们理解的概念更少。

如果你追求更快的生成速度,使用10步而非20步即可。

未被绘制的部分(如人脸)仍会保持良好,但绘制部分会显得不够精细。

实际上效果没那么糟,如果你真需要速度,用10步也完全可以。

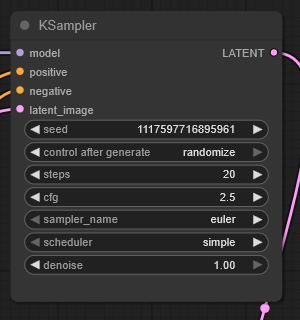

Ksampler设置?

说实话,我完全不知道为什么,但我看到别人的流程用了CFG 2.5和20步,结果就是好用。

你也可以用CFG 4.0和40步,但似乎并无明显提升,何必多此一举?

其他数值如CFG 2.0或3.0总会让结果变差,因此这个参数非常敏感。

就坚持用CFG 2.5吧,折腾它不值得。

你可以用10步加速生成;人脸和不变部分看起来完全正常,但绘制部分(如皮夹克)会细节不足。

效果其实没那么差,如果你真需要速度,10步通常是可行的。

30步相比20步在细节上略有提升,但提升幅度很小,不值得额外耗时。

绝对不要超过30步,因为超过后图像质量会开始下降。

更多参考图像?

本工作流为简化只用了一张,但你可以添加更多。

添加另一个ReferenceLatent节点和图像缩放节点。

将第二个ReferenceLatent节点接在第一个之后,将第二张图像(经缩放后)连接到它。

我已测试过使用两张图像,效果良好;三张尚不确定。

重要:参考图像实际上无需是1MP;如果你追求极致,可以输入1.5或2MP的图像作为参考,同时向ksampler提供1MP的latent输入,结果质量会显著提升。

例如,面部替换会拥有更多细节。

注意:2MP的参考图像运行时间会明显更长。

这一点也适用于单张输入,只要ksampler接收的是1MP的latent即可。

高级质量技巧

那么参考图像的讨论意味着……?

是的!如果你输入一张2MP图像,且它能精确下采样为1MP且为16的倍数(无需预下采样),再向ksampler提供目标1MP latent,你便可以直接编辑2MP图像至1MP尺寸。

结果质量明显更高!

设置麻烦,但效果确实惊人。

如何操作:

将1MP下采样版本送入文本编码器节点。

将2MP版本送入ReferenceLatent。

将正确缩放的1MP图像(必须与2MP图像1:1对应,且为16的倍数)送入ksampler。

然后,它就直接工作了™。

Qwedit能处理什么图像尺寸?

低于1MP的尺寸完全没问题。

但仍建议放大至1MP,这有助于提升提示词遵循度并减少模糊。

当超过1MP时,Qwedit会逐渐“深炸”你的图像。

同时,提示词遵循度下降,图像常因物体重复而扭曲。

除此之外,它确实还能运行。

因此,你愿意超过1MP的幅度,直接取决于你能接受图像被“炸”到什么程度,以及你愿意尝试多少次才能得到一张可用的。

实际上,1.5MP(如1254x1254)之前,图像质量不会严重下降;虽仍可察觉,但根据用途可能“勉强可接受”。

- 但请准备好多次生成,它会以其他方式出错。

若达到2MP或更高,你将遭遇严重深炸,图像会被“毒化”、物体重复。

但某些情况下,它仍可能勉强可用。

下面是一张1760x1760(3MP)的调酒师女孩编辑图:https://files.catbox.moe/m00gqb.png

你能看到效果还算可以——由于场景较暗,深炸不明显。但她的手在瓶子上被奇怪地重复了,放大看面部能发现细节扭曲。此外,她的双臂也没保持机械感。效果因图而异,正如我所说,我不建议超过1MP太多。