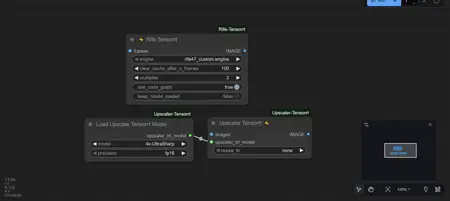

RifeTensorrt Interpolation using Tensortcore and upscaler.

詳細

ファイルをダウンロード

このバージョンについて

モデル説明

- ComfyUI Desktop および ComfyUI_Portable に対応するワンクリックインストール:

まず上部のバージョンリストから使用する CUDA バージョンを選択し、ダウンロード → 解凍 → INSTALL_RIFE.bat をクリックします。次に、ComfyUI フォルダをドラッグしてください(例:G:\ComfyUI_windows_portable1)。コマンドプロンプトに ComfyUI フォルダをドラッグすると、どの wheel をインストールするか尋ねられます。Python のバージョン(CP38 から CP313 まで)を選択してください。これで完了です!狂ったように補間できるようになります。インストール後、マネージャーから comfyui-upscaler-tensorrt もインストールできます。

完全にインストールが完了したら、インストールファイルは削除しても問題ありません。

https://github.com/yuvraj108c/ComfyUI-Rife-Tensorrt?tab=readme-ov-file

https://github.com/yuvraj108c/ComfyUI-Upscaler-Tensorrt

ノードの作成者である https://github.com/yuvraj108c/ComfyUI-Rife-Tensorrt に感謝します。

私は以前、VF1 フィルム補間と RIFE 補間を使用していましたが、20秒の動画を補間するのに少し遅かったため、RIFE TensorRT を動かす方法のチュートリアルを作成しました。非常に高速です。TensorCore を使用したアップスケーラーも同様に高速です。

- 手動インストール方法:

- ステップ1:NVIDIA TensorRT ダウンロードページへ移動:https://developer.nvidia.com/tensorrt

- ステップ2:アカウントが必要なので、ログインまたは NVIDIA に登録してください。

- ステップ3:ログイン後、適切なファイルをダウンロードします。私の場合、TensorRT 10.14.1 GA for Windows 10, 11, Server 2022 and CUDA 13.0 ZIP Package をダウンロードしました。なぜなら、最新の ComfyUI ポータブル版は CUDA 13.0 に対応しているためです。

- ステップ4:ダウンロード後、どこかのフォルダに解凍します。フォルダを開き、PYTHON フォルダに入ると、tensorrt-10.14.1.48-cp313-none-win_amd64.whl というファイルが表示されます。CP313 は Python のバージョンです。

- ステップ5:ステップ4で入手した wheel をインストールします。ComfyUI フォルダ(例:G:\ComfyUI_windows_portable\python_embedded)に移動し、検索バーに「CMD」と入力してコマンドプロンプトを開きます。以下を入力します:python.exe -m pip install ...\\...\\python\\tensorrt-10.14.1.48-cp313-none-win_amd64.whl

(...\\...\\python\\ の部分は、ダウンロードした tensorrt-10.14.1.48-cp313-none-win_amd64.whl ファイルの実際のパスに置き換えてください)

インストールを実行します。

- ステップ6:Python_embedded フォルダ(例:G:\ComfyUI_windows_portable\python_embedded\Lib\site-packages)に移動し、site-packages 内に tensorrt_libs という新しいフォルダを作成します。そのフォルダに、以下のリンクからすべてのファイルをコピーしてください:

https://huggingface.co/pitou69/tensorrt_libs/tree/main/tensorrt_libs

(注:これらのファイルは Python 3.13、3.12、任意の CUDA で使用可能です。すべてダウンロードして tensorrt_libs フォルダ内にコピーしてください。)

- ステップ7:モデルフォルダ(例:G:\ComfyUI_windows_portable\ComfyUI\models)内に tensorrt という新しいフォルダを作成します。その中に rife というフォルダを作成し、以下のリンクからエンジンをダウンロードして rife47_custom.engine を配置します:

https://huggingface.co/pitou69/tensorrt_libs/tree/main/tensorrt/rife

すべての RIFE エンジン(モデル)はこちら:

https://huggingface.co/pitou69/tensorrt_libs/tree/main/rife%20engine

RIFE 49 が推奨されていたため、RIFE 49 および 48 用のエンジンを構築しました。

- 手動ダウンロード:(Python 3.13 および 3.12(CUDA 13.0)専用。

tensorrt_libsは引き続き使用できますが、チュートリアルのステップ1〜4を実行する必要があります。CUDA 124 など他のバージョンを使用している場合は、独自に wheel をビルドしてください。)

もし私のアーカイブを信頼してファイルをダウンロードする場合、以下のようにしてください:

- ステップ1:アーカイブをダウンロードし、フォルダに解凍します。

- ステップ2:tensorrt、tensorrt_libs、tensorrt-10.14.1.48.dist-info の3つのフォルダをすべて、G:\\ComfyUI_windows_portable\\python_embedded\\Lib\\site-packages にコピーします。

- ステップ3:モデルフォルダ(例:G:\\ComfyUI_windows_portable\\ComfyUI\\models)に移動し、tensorrt フォルダを作成します。その中に rife フォルダを作成し、rife47_custom.engine ファイルをコピーします。これで完了です。

この迅速なインストール方法は、他のダウンロードを信頼できる場合にのみ使用してください。そうでない場合は、私が作成したチュートリアルに従ってください。また、この迅速インストールは、Python 3.13 または 3.12(CUDA 13.0)用の新しい ComfyUI ポータブル版専用です。

これで、超高速補間が利用可能になります!

編集:すべての設定が完了したら、TensorRT アップスケーラーもインストールできます。https://github.com/yuvraj108c/ComfyUI-Upscaler-Tensorrt

マネージャーから補間ツールとアップスケーラーの両方をダウンロードできます。アップスケーラーは、チュートリアルを完了またはアーカイブをダウンロードした後で動作します。

注:720p 以上の解像度でアップスケーリングする場合、VRAM を若干消費します。480p からでも同様です。VRAM 使用量を減らす方法は見つけていません。RIFE TensorRT ノードの後に「Clean VRAM Used」ノードを挿入することをお勧めします。これにより効果がある場合があります。