Wan2.2 AIO Workflow (SVI 2.0 Pro - For-Loop I2V - S2V - Upscaler - Frame Interpolation - Faceswap)

세부 정보

파일 다운로드

모델 설명

우선, 이 워크플로우의 기초를 제공해 주신 thesharque588님께 모든 감사의 말을 전합니다!

시나리오 및 자동화를 위한 장편 영상용 통합 워크플로우

이 워크플로우에 관대해 주시길 바랍니다! (저는 8월에 ComfyUI를 처음 시작해 혼자서 만들었습니다!)

이 워크플로우의 목표는 제가 필요로 하는 모든 기능을 한 곳에 모아 연결할 수 있도록 하는 것입니다. 그리고 충분히 유용하다고 생각되어 공유하기로 결정했습니다.

이 워크플로우에는 다음이 포함됩니다:

- 인덱스를 통한 시나리오 제어

- 각 인덱스의 지속 시간을 개별적으로 선택

- 자동 프롬프트 번역기

- 색상 매칭

- 얼굴 교체 (ReActor Faceswap)

- 프레임 보간 (RIFE-VIF)

- S2V (MMaudio 사용, 오디오 소스 불필요)

- 업스케일러 x2-x4 (Upscaler Tensorrt(x4) + Video Upscaler(x2))

- 그룹별 제어: 각 그룹을 개별적으로 실행

이 워크플로우는 어떻게 작동하나요?

가장 중요한 점! 모든 그룹은 "GroupExecutor" 노드를 사용하여 실행해야 합니다. 이 노드는 선택한 그룹만 실행하도록 설계되었습니다. 이렇게 하면 대기 중인 그룹의 모델을 로드하지 않고도 모든 그룹을 활성 상태로 유지할 수 있습니다. ComfyUI의 "Execute" 버튼을 사용해 생성을 실행하면, I2V 생성 초기에 MMAudio 모델이 병렬로 로드되어 I2V에 사용 가능한 VRAM이 줄어들 수 있습니다. 때때로 "GroupExecutor" 노드 중 하나가 작동을 멈출 수 있습니다(왜 그런지 아직 찾고 있습니다). 이럴 경우 새 노드로 교체하거나 워크플로우 내 다른 노드를 사용하세요.

각 처리 단계는 4개의 그룹으로 나뉩니다: 이미지 → 영상, 오디오 → 영상, 업스케일러, 72fps로 전환(프레임 보간).

I2V

단계 1: I2V 향상 – 영상에 적용할 향상 기능을 선택하세요.

"Select Source Image"에서 0 또는 1을 선택해 소스 이미지를 선택하세요:

0 = 개별 이미지 로드

1 = 폴더에서 이미지를 로드하고 설정된 이미지 개수만큼 처리 (이 기능은 AFK 상태에서 워크플로우를 계속 실행할 수 있도록 설계되었습니다. 각 생성 후 폴더 내 다른 이미지로 루프하며 재시작됩니다 - 폴더 경로를 설정하는 것을 잊지 마세요). 아직 개선이 필요하며 작업 중입니다.

단계 2: 준비 – 영상 파라미터 설정

배치 크기와 총 스텝 수를 설정하세요 (각 인덱스는 1 스텝입니다. 스텝 수가 3이면 인덱스 0부터 2까지 총 3개의 인덱스를 사용합니다).

이미지 크기를 가능한 가장 큰 크기로 조정하세요 (항상 동일한 해상도를 사용하지 않으므로 자동화를 목적으로 설계되었습니다. 더 많은 제어가 필요하면 노드를 자유롭게 변경하세요).

슬라이더를 사용해 각 인덱스의 지속 시간을 개별적으로 설정하세요 (슬라이더는 WanImageToVideo와 동일한 프레임 값으로 설정되어 있으며, 4씩 증가합니다. 다른 INT 값 노드로 변경할 수 있으나, 음성 프롬프트 상자 뒤에 숨겨진 Any Switch Index에 연결해야 합니다).

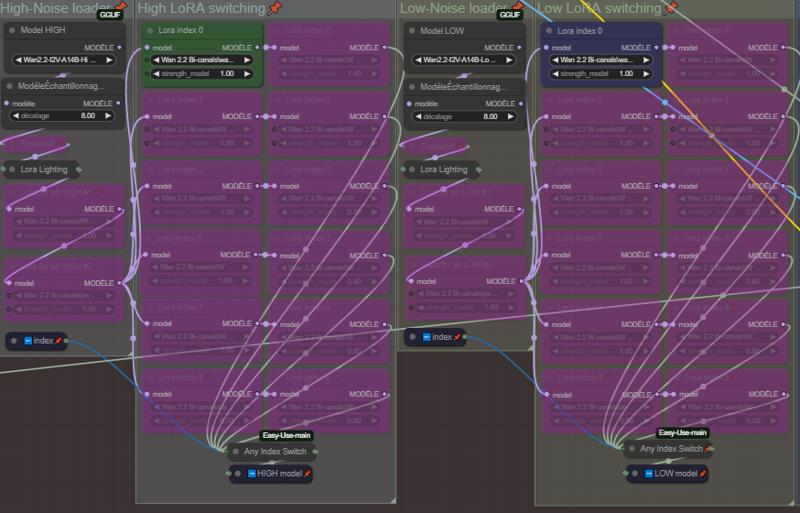

단계 3: 로더 – 모델 및 LoRA 설정

고/저 노이즈용 모델(GGUF)과 Lightning LoRA, FusionX LoRA를 선택하세요 (Lightning 및 FusionX LoRA는 필수는 아닙니다. 사용하지 않으려면 노드를 비활성화하세요).

고노이즈 및 저노이즈 로더 그룹의 LoRA는 모든 인덱스에 적용되는 일반 LoRA입니다.

각 인덱스별로 LoRA를 선택하세요. 이 부분은 5개 인덱스(인덱스 0부터 시작)를 기준으로 설계되었습니다. 필요에 따라 추가하거나 삭제할 수 있습니다. 추가할 경우 각 열 아래의 AnySwitchIndex에 연결하세요.

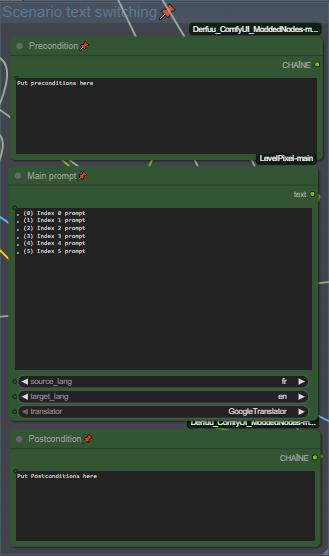

단계 4: 프롬프트 – 시나리오 설정

🚨🚨🚨🚨 영어에 자신이 없다면 이 프롬프트에 내장된 번역기 사용하세요 🚨🚨🚨🚨

사전 및 사후 조건을 설정하고 각 인덱스별로 시나리오 프롬프트를 입력하세요. 프롬프트 내 인덱스 구분은 줄 바꿈으로 이루어집니다. 저는 시나리오를 더 명확하게 보기 위해 ", (0)", ", (1)" 같은 구분자를 사용합니다(다른 방식도 가능하며, 필요시 그룹 노드 뒤에 숨겨진 구분 방식을 변경하세요).

🚨🚨 번역할 소스 언어 및 대상 언어를 설정하는 것을 잊지 마세요 🚨🚨

단계 5: 얼굴 교체 – 얼굴 교체 파라미터 설정

Wan2.2는 얼굴 왜곡/변화를 유발하는 많은 LoRA를 가지고 있어, ReActor Faceswap을 추가하여 일부 LoRA의 얼굴 왜곡을 보완했습니다. 기본 설정은 적절하지만, 실험을 위해 자유롭게 조정하세요. (ComfyUI Manager에서 사용 가능, 모델은 자동으로 다운로드됩니다.)

교체할 이미지 소스를 선택하세요:

0 = 소스 이미지 로드

1 = 시작 이미지를 소스로 사용

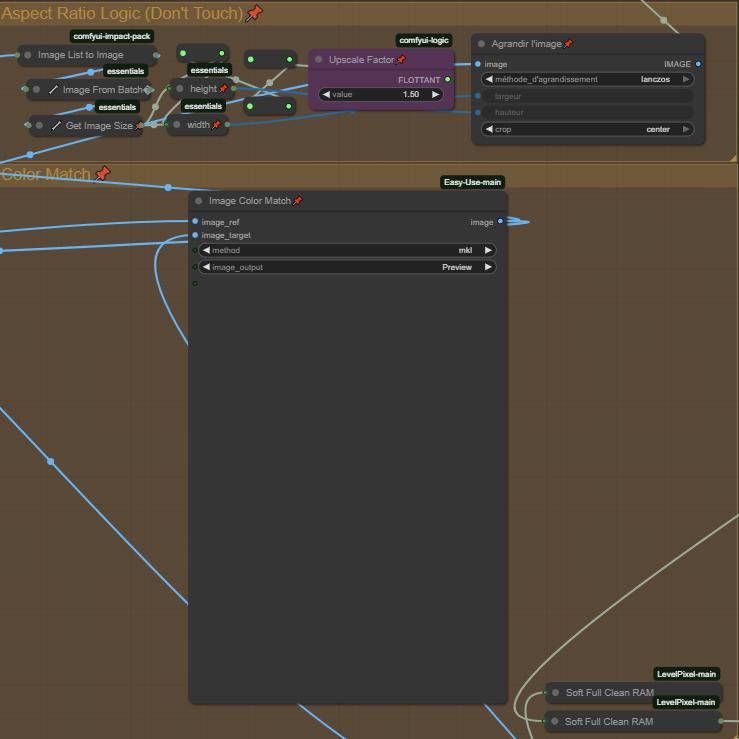

단계 6: 종횡비 로직 + 색상 매칭

종횡비 로직은 영상을 약간 개선하기 위한 단순한 줌 기능입니다. 줌 정도를 변경하려면 업스케일 팩터를 조정하세요.

이미지 색상 매칭은 소스 이미지의 색상을 유지하고 일치시키는 것을 목적으로 합니다. 비활성화할 수 없으며, 우회해도 다음 노드로 아무것도 전달되지 않습니다. 색상 문제가 발생하면 "Method"를 변경하거나 노드를 삭제하세요. 이 문제는 향후 업데이트 버전에서 수정될 예정입니다.

(중요)

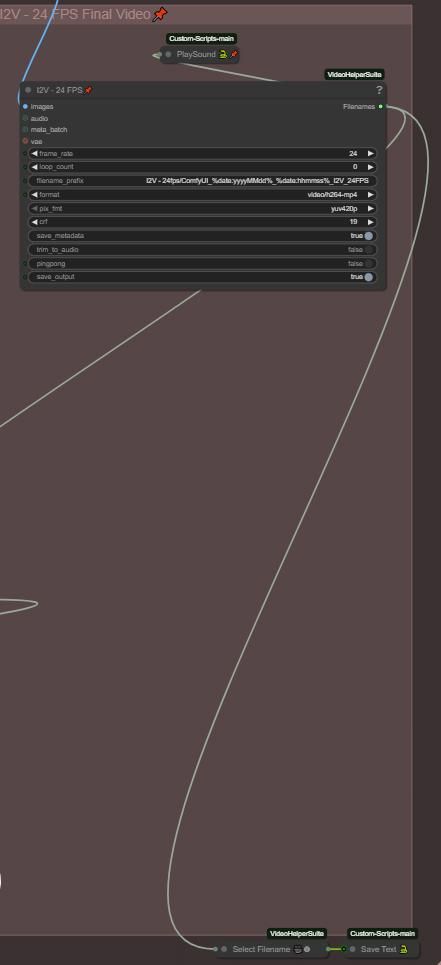

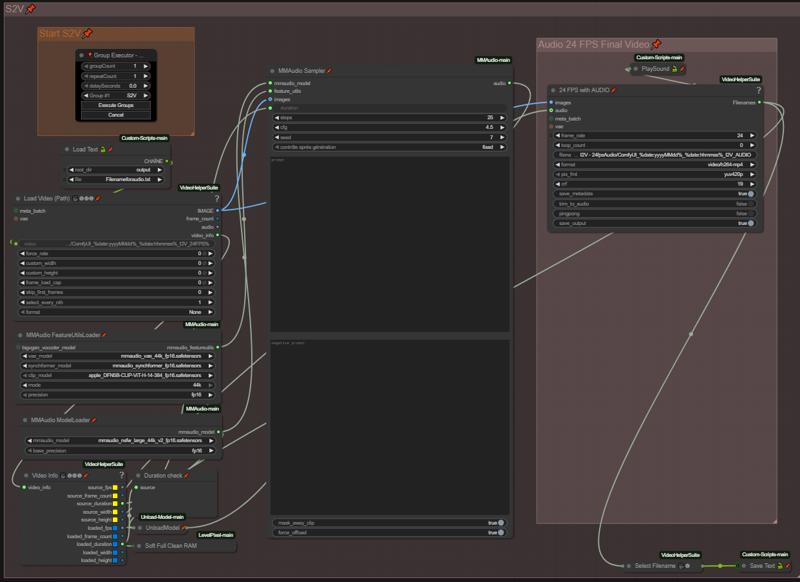

단계 7: 최종 영상 및 체인 기능

모든 최종 영상의 폴더 경로는 텍스트 파일(Save Text 노드)에 저장됩니다. 이 기능은 생성을 체인으로 연결하기 위함입니다. I2V를 마친 후, 텍스트 파일에 저장된 마지막 생성 영상 파일명을 로드하여 다음 그룹이 시작할 수 있도록 합니다. 텍스트 파일 이름을 변경하려면 "Save Text" 및 "Load Text" 노드의 파일명과 반드시 일치시켜야 합니다!

최종 영상은 MMaudio와의 호환성을 높이기 위해 24fps로 설정됩니다(MMaudio는 24fps로 학습됨). 영상에 오디오를 생성하지 않을 경우 16fps로 낮출 수 있습니다.

워크플로우 생성이 완료되었을 때 알림을 주는 "Playsound" 노드도 포함되어 있습니다. 필요하지 않다면 삭제하셔도 됩니다.

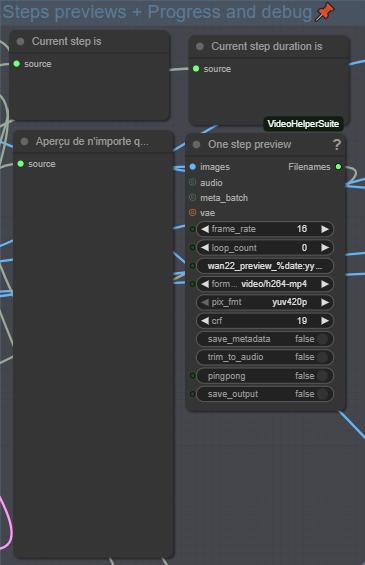

단계 8: 프로세스 모니터링 및 디버그

이 섹션은 현재 처리 중인 인덱스, 전체 프레임 수, 프롬프트, 각 인덱스의 미리보기를 표시합니다. 이를 통해 생성 과정을 모니터링하고 필요한 조정을 할 수 있습니다.

S2V

여기서 오디오 프롬프트를 입력하세요. 기본 모델보다 NSFW MMaudio를 사용하는 것을 권장합니다(더 나은 결과). 모든 과정이 자동화되어 있으므로, 긍정/부정 프롬프트를 완료한 후 그룹만 실행하면 됩니다. "Load Text" 노드를 통해 이전 I2V 생성 영상을 자동으로 로드하고 오디오를 추가합니다.

업스케일러 x2-x4

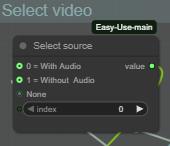

단계 1: 소스 영상 선택 (오디오 포함/미포함)

여기서는 MMaudio 그룹에서 생성된 오디오 영상인지, I2V 그룹에서 생성된 오디오 없는 영상인지 선택합니다.

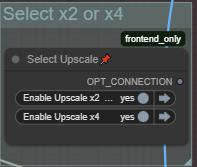

어떤 업스케일 그룹을 실행할지 선택합니다.

참고:

x2 업스케일러는 TensorRT를 사용하지 않기 때문에 x4보다 훨씬 느립니다. x2 업스케일링을 더 빠르게 할 수 있는 더 나은 방법이 있다면 제안해 주세요.

x4 업스케일러는 TensorRT를 사용합니다. 이미 .\models\upscale_models 폴더에 업스케일 모델이 있다면 자동으로 불러와집니다. x4 업스케일러 전용이며, x2 모델을 불러오거나 변환해보았으나 작동하지 않았습니다.

필요 시 업스케일러 파라미터를 수정한 후 "GroupExecutor" 노드로 그룹을 실행하세요.

프레임 보간 (72fps로 전환)

이전 그룹과 동일한 로직입니다.

단계 1: 소스 영상 선택 (업스케일/오디오 포함/미포함)

마지막 생성 그룹에 따라 선택하세요.

0 = 업스케일 없음 (MMaudio 24fps 오디오 영상 로드)

1 = 업스케일 있음 (업스케일된 영상 로드)

2 = 오디오 없음 & 업스케일 없음 (I2V 그룹의 영상 로드)

단계 2: 조정

최종 영상은 오디오 그룹을 사용한 경우 음성과 동기화를 유지하기 위해 72fps로 설정됩니다. 오디오 그룹을 사용하지 않는 경우 필요 시 60fps로 낮출 수 있습니다.

이전 그룹과 마찬가지로, 보간기 파라미터를 필요에 따라 수정하는 것을 잊지 마세요.

자원

사용자 정의 노드는 ComfyUI Manager에서 자동으로 찾을 수 있습니다. 일부가 누락된 경우 알려주세요.

이 워크플로우는 RTX 5080 16GB, 64GB RAM 환경에서 사용하고 있습니다.

GGUF 모델 및 VAE:

https://huggingface.co/QuantStack/Wan2.2-T2V-A14B-GGUF/tree/main

NSFW ClipVision:

https://huggingface.co/ricecake/wan21NSFWClipVisionH_v10/tree/main

Umt5 xxl 인코더 GGUF:

https://huggingface.co/city96/umt5-xxl-encoder-gguf/tree/main

NSFW MMaudio:

https://huggingface.co/phazei/NSFW_MMaudio (다운로드 후 "mmaudio_nsfw_large_44k_v2_fp16.safetensors"로 이름 변경)

Lightx2v LoRA:

https://huggingface.co/lightx2v/Wan2.2-Lightning/tree/main/Wan2.2-T2V-A14B-4steps-lora-250928

FusionX LoRA:

https://huggingface.co/vrgamedevgirl84/Wan14BT2VFusioniX/tree/main/FusionX_LoRa

이 워크플로우는 지속적으로 최적화되고 있으며, 곧 V2 버전이 나올 예정입니다. 빠진 내용이 있다면 추가하겠습니다. 필요 시 질문해 주세요(프로필의 Discord 링크를 통해 문의하는 것이 모두에게 편합니다).

_이 ComfyUI 워크플로우를 사용해 주셔서 감사합니다. 책임감 있고 존중하는 태도로 사용해 주세요.

이 워크플로우는 창의적, 기술적, 개인적 실험을 위해 제작되었으며, 해악, 괴롭힘, 또는 어떤 형태의 남용을 위한 것이 아닙니다._