Prompt Hunter - Simple IMG-2-TXT Workflow (Epic Prompts for Z-Image, Qwen, Flux etc.)

详情

下载文件

关于此版本

模型描述

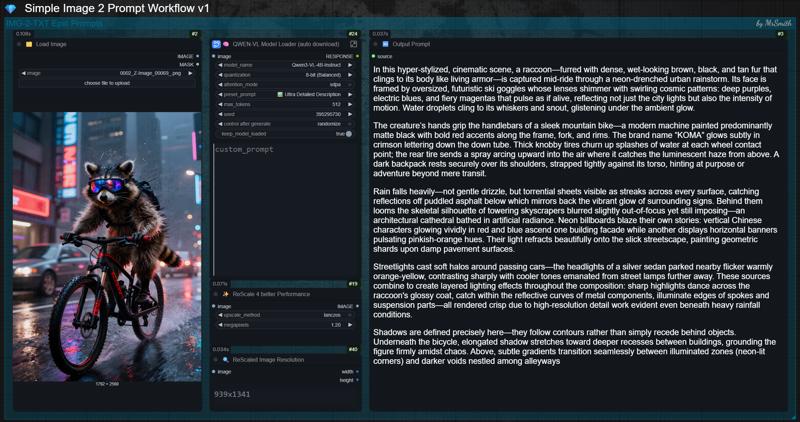

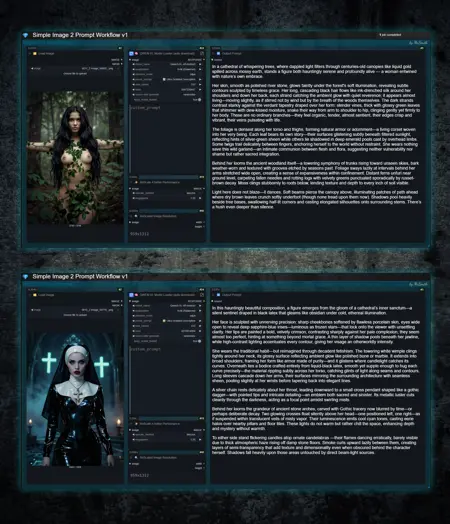

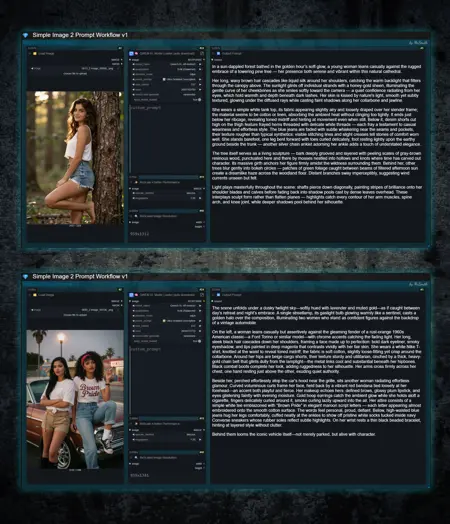

⚡ QWEN3-VL 图片转提示词工作流 ⚡

为 Flux、Qwen、Z-Image 等众多模型生成自然语言史诗级提示词的简易图片转文本工作流。

此工作流解决了提示词丢失或被隐藏的令人沮丧的问题。 👌

✨ 它有什么用?(使用场景)

你在网上发现了一张让你灵感迸发的图片,希望部分或完全重现它。

你在这里的 CivitAI 上看到一张吸引人的图片,对它的提示词感兴趣,但创作者选择隐藏了它。

你想重新生成你之前的一个作品,但已经找不到原始提示词。

在所有这些情况下,只需将图片拖入工作流,它就会输出一个详细且高质量的提示词,在大多数情况下能生成完全一致的结果。根据图片和提示词的复杂程度,结果甚至常常更好。

🚀 你如何立即开始使用?

此工作流——只需下载,解压文件,将 *.json 加载到 ComfyUI 中。

无需手动下载模型。所选模型将自动下载。

❓ 运行此工作流需要特殊节点吗?

此工作流使用的所有节点均为通用节点,应已安装在你的 ComfyUI 环境中。若 ComfyUI 提示缺失节点,只需通过 ComfyUI Manager 安装并重启即可。

本工作流使用的自定义节点:

💡 使用方法:

将你想要的图片拖入或加载到工作流中。

从下拉菜单中选择你的 Qwen3VL 模型。首次运行时会自动下载,因此首次运行会稍慢一些。你可以在控制台查看下载进度。

根据你的 GPU(VRAM 大小)选择 QwenVL 模型。我在 16GB 显卡上使用 Qwen3-VL-4B-Instruct 模型,效果非常好,能生成极其出色的提示词。

除非你享受看着你的 GPU 试图从最近的窗户逃走,否则不要使用 32B 模型。😉

选择你想要的“预设提示词”。Ultra Detailed 或 Cinematic 在大多数情况下效果极佳。

量化? 仅使用 8-bit。16-bit 仅会拖慢处理速度而不会提升结果。你也可以尝试 4-bit,某些设置下这会更快。

准备就绪! 点击“RUN”即可!

⬇️ 手动下载模型文件:

如果你希望手动下载模型,可以在 Huggingface 找到不同版本,只需将它们放置在 /models/LLM/Qwen-VL/ 目录中。

❓ 为什么使用 ReScale Image 节点?

大图处理耗时更长。为提升性能,该节点会自动将大图缩小至 1.2MP。如果结果仍可接受,你可进一步降低分辨率,以进一步加快处理速度。

对于低分辨率图片,情况相反。它们处理迅速,但根据分辨率不同,可能缺乏足够的图像信息。此时,图像将被上采样至 1.2MP,以确保有足够的像素用于准确分析。

❓ 为什么选择 Qwen3-VL 而非 Florence2?

我已对两个模型进行了广泛测试与对比。在我看来,Qwen-VL 提供了更优越的结果。它能提供更丰富的选项,生成的提示词在构图上更贴近原图,远胜于 Florence2。

Qwen3-VL 因其对艺术风格、写实效果、光影和复杂构图的深刻理解而备受推崇,能生成可直接用于高级自然语言模型(如 Flux、Z-Image、Qwen 等)的生产级提示词。

如果你对本工作流有任何问题或反馈,欢迎留言。若遇到问题,请具体说明哪里不正常。

💕 别忘了传递爱意

点赞并关注我,以免错过未来更新和类似的新工作流。👍

享受吧!🙂