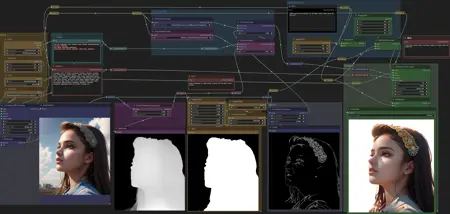

ComfyUI Workflows

세부 정보

파일 다운로드

모델 설명

BGMasking V1:

설치 방법:

https://github.com/Fannovel16/comfy_controlnet_preprocessors 설치

https://github.com/Fannovel16 감사드립니다.

다운로드:

/model/9251/controlnet-pre-trained-models

Canny는 최소한 필요하며, Depth 모델은 선택 사항입니다.

또는 차이 모델 (당신의 모델을 입력으로 받으며, 더 정확할 수 있음)

/model/9868/controlnet-pre-trained-difference-models

이 ControlNet 모델들을 ComfyUI/models/controlnet 폴더에 넣으세요.

Ally 감사드립니다.

첨부 파일을 다운로드하여 ComfyUI/custom_nodes 폴더에 넣으세요.

다음 노드 일부를 포함하고 있습니다 (모든 노드는 아님)

/model/20793/was-node-suites-comfyui

ComfyUI 재시작

사용법:

먼저 출력 샘플러에서 잠재 입력을 분리하세요.

원하는 프롬프트를 생성하세요. "open sky background"를 추가하면 장면에 다른 물체가 생기는 것을 막는 데 도움이 됩니다.

이미지 필터에서 밝기 조정을 하세요. 제가 테스트했을 때 -0.200 이하의 값이 효과적입니다. 흔히 문제 발생하는 부분은 흐르는 머리카락이며, 벽 같은 물체에 기대는 자세입니다.

자립형 자세와 짧고 곧은 머리카락은 매우 잘 작동합니다.

밝기 조절의 목적은 깊이 맵의 범위를 제한하여 당신의 주제에 맞는 마스크를 생성하는 것입니다.

배경 이미지를 선택하세요. 이는 동일한 잠재 이미지일 수도 있고, 노드로 생성한 빈 이미지일 수도 있으며, 또는 로드한 이미지일 수도 있습니다.

또는 노란색과 같은 중간에 이미지 필터를 추가하여 웨딩 조명 효과를 부여하거나 주제와 새 배경 간의 블렌딩을 조금 더 자연스럽게 만들 수 있습니다.

마스크가 만족스러울 정도로 완성되면, VAEEncodeForInpaint 잠재 출력을 Ksampler (WAS) 출력에 다시 연결하고, 프롬프트 큐를 누르세요.

이 방식이 작동하려면 Canny ControlNet이 반드시 필요합니다. HED와 Normalmap도 시도해봤지만, Canny가 가장 잘 작동하는 것으로 확인되었습니다.

당신의 주제에 따라 다른 ControlNet 유형이 필요할 수 있습니다.

Canny 전처리기를 다른 것으로 변경하고, 필요에 따라 다른 ControlNet 모델을 설치해야 합니다.

깊이 ControlNet을 적용하는 것은 선택 사항입니다. 강도에 따라 출력에 약간의 3D 효과를 추가합니다.

예를 들어 애니메이션이나 회화처럼 2D 작업을 주로 한다면, Depth ControlNet을 건너뛸 수 있습니다.

단순히 Depth ControlNet의 조건을 제거하고 Canny ControlNet에 입력하면 됩니다. 그러나 Canny ControlNet이 없는 경우, 출력 생성 결과는 시드 미리보기와 매우 달라질 것입니다.

이 작업 흐름을 더 명확히 하기 위해 많은 루트 재배치 노드를 추가했습니다.

automatic1111에서 이 워크플로우를 재현하려면, 마스크를 만들기 위해 3자 제3자 프로그램을 사용하더라도 많은 수동 스텝이 필요하므로, Comfy를 사용하면 매우 편리합니다.

면책 조항: 일부 배경 색조가 최종 이미지로 스며들어 보일 수 있습니다.

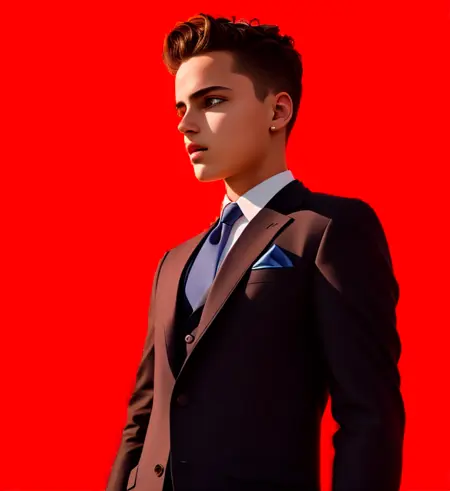

BGRemoval V1:

요구사항:

https://github.com/Fannovel16/comfy_controlnet_preprocessors

/model/9251/controlnet-pre-trained-models

(openpose 및 depth 모델 포함)

선택 사항이지만 매우 추천:

https://civitai.com/api/download/models/25829

F222 및 protogen과 같은 다른 모델들로도 테스트해봤습니다.

다음 설명과 안내는 워크플로우 내 텍스트 노드에도 포함되어 있습니다:

Load Addition 노드에서 다양한 "마스크"를 사용해봤는데, 결과는 크게 달라졌지만 모두 배경을 반환했습니다. 또한 같은 마스크를 다른 색으로 사용해보기도 했습니다.

이 경우는 완전히 검은 배경 위에 생성된 흰색 그라데이션입니다.

이 AI가 노이즈 분포를 가이드하는 데 사용한다고 추측할 수 있습니다.

녹색 조건 조합 노드의 입력 순서는 실제로 중요합니다. 녹색 "Depth Strength" 출력은 하단 입력에 연결되어야 합니다.

이 노드의 상단 입력은 자세 정보를 포함한 CLIP 긍정 시그널에서 옵니다.

파란 샘플러 섹션은 오직 깊이 맵을 생성하고, 이 맵을 잠재로 인코딩한 후 청색 출력 샘플러의 잠재 입력으로 사용하는 역할만 수행합니다.

녹색 이미지 스케일의 경우, 원본 이미지 크기와 항상 일치시키는 것이 좋으며, 자르기(Crop)는 비활성화하세요.

DEPTH STRENGTH 설정은 최종 이미지에 크게 영향을 미치며, 너무 높게 설정하면 원래 긍정 프롬프트의 가중치를 상실하게 됩니다.

때로는 0에서 시작할 수 있지만, 배경이 나타날 경우 강도를 늘려야 하며, 최대 1까지 증가시켜도 됩니다. (낮을수록 더 좋음)

이미 다운로드하고 설치하지 않았다면, 다음 을 추천합니다:

Fannovel의 전처리기

https://github.com/Fannovel16/comfy_controlnet_preprocessors

시드 노드 및 시드 입력 샘플러는 여기에서 다운로드 가능

https://civitai.com/api/download/models/25829

OpenPose 및 Depth 모델은 여기에서 찾을 수 있음

/model/9251/controlnet-pre-trained-models

또는 WAS의 Depth 전처리기를 사용해 볼 수도 있지만, 저는 지나친 세부 정보나 유용한 임계치가 없는 깊이 맵을 생성하여 이 작업에 적합하지 않다고 판단했습니다.

사용 중인 모델은 여기에서 찾을 수 있음