Wan 2.2 First-to-Last Frame Workflow

詳細

ファイルをダウンロード

モデル説明

このワークフローを即座に試してみませんか?

このWan 2.1 First-to-Last Frameワークフローは、SeaArt上で事前設定済みで、セットアップをスキップしたい方のためにすぐに実行できます。

注:これはワークフローのホスト版への直接リンクです。モデルやLoRAをローカルに手動でダウンロードして設定したくない方におすすめです。

AI動画の終わり方がどうなるか推測するのをやめよう。自分で定義しよう。

AI動画生成における最大の課題の1つは、制御です。素晴らしいスタート画像は持っているのに、最終フレームでは混沌とした状態に流れてしまうことがよくあります。もしスタートとエンドの両方を固定して、AIにその間の遷移を自動で生成させられたらどうでしょうか?

それがまさにWan 2.2 First-to-Last Frameワークフローが実現するものです。Wan 2.2の140億パラメータモデルと「Lightning」スピード最適化を組み合わせたこのComfyUIワークフローにより、キャラクターのポーズを変化させたり、照明を切り替えたり、まったく異なるシーン間をプロフェッショナルな一貫性で遷移させることができます。

なぜこのワークフローを使うのか?

私たちのテストと結果に基づき、このワークフローは3つの主要な課題を解決します:

精密な制御:単に前進してアニメーションするのではなく、あなたが提供する2つの特定の画像の間を補間します。

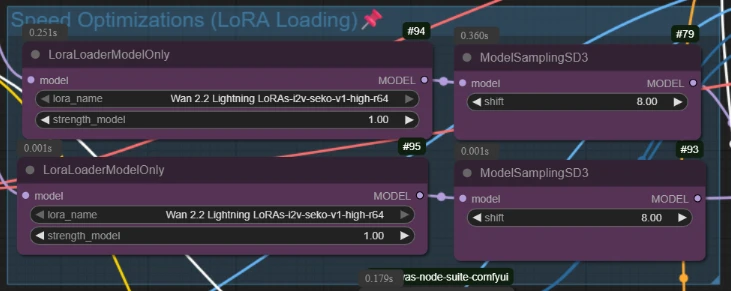

高速かつ高品質:Wan 2.2 Lightning LoRAsを活用し、140億パラメータモデルの詳細を損なうことなく、レンダリング時間を大幅に短縮します。

滑らかな再生:内蔵の**RIFE VFI(動画フレーム補間)**システムにより、生の出力を自動的に滑らかな32FPSの動画に変換します。

ステップバイステップガイド:仕組み

以下にワークフローのロジックを解説しますので、すぐに作成を始められます。

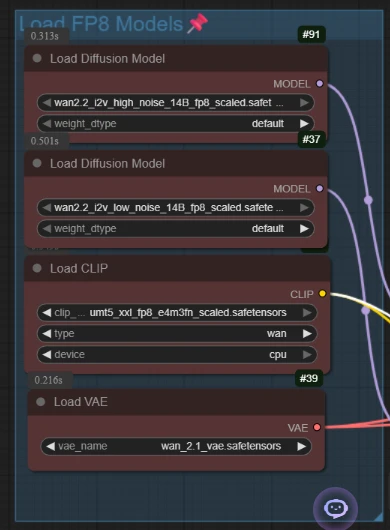

1. セットアップ:高性能モデル

ワークフローは、重いモデルを読み込むことから始まります:Wan 2.2の140億パラメータ扩散モデル(高ノイズ版と低ノイズ版に分割)とT5エンコーダー。

- プロのヒント:このセットアップでは、強度1.0に設定された「Lightning LoRAs」を使用しています。これが、迅速な実験を可能にする秘訣です。

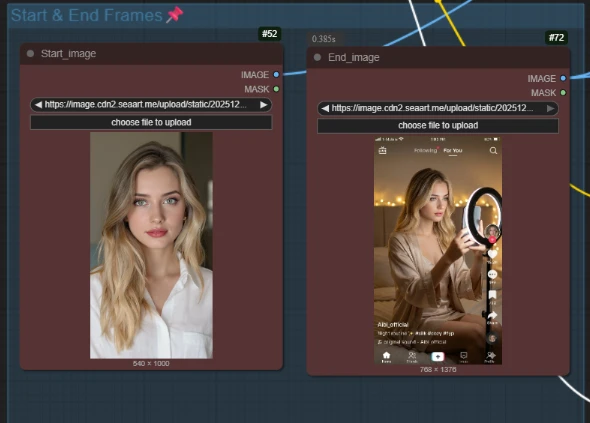

2. ナラティブの定義(スタートとエンド)

ここが魔法が起こる場所です。1枚の画像をアップロードするのではなく、2枚アップロードします:

スタート画像:初期のシーン(例:白いシャツを着た女の子)

エンド画像:最終的な目標(例:同じ女の子がTikTokの照明設定で携帯電話を手に持っている)

ワークフローは専用のノードWanFirstLastFrameToVideoを使用して、この2つの異なるビジュアルの間の潜在的遷移を計算します。

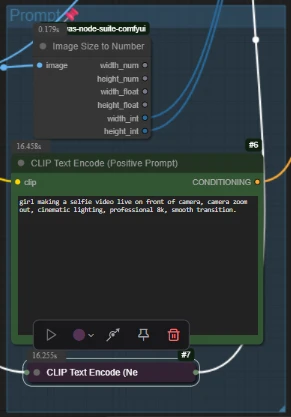

3. テキストによるガイド

遷移をシンプルなテキストプロンプトでガイドします。

ポジティブプロンプト:発生しているアクションを記述(例:「女の子がセルフィー動画を撮っている… カメラがズームアウトする」)

ネガティブプロンプト:ぼやけや歪みを防ぐための標準的な品質フィルター

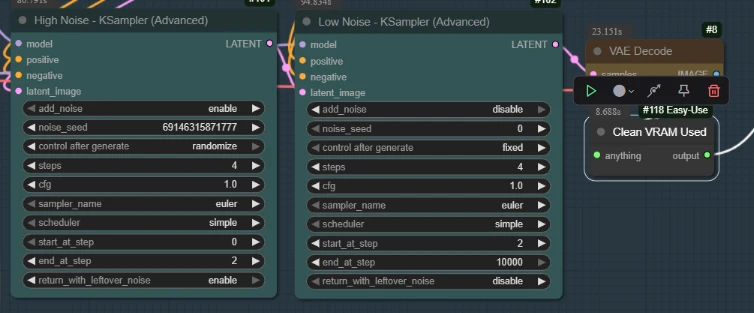

4. 「デュアルサンプラー」エンジン

基本的なワークフローとは異なり、このワークフローはスマートな2段階サンプリングプロセスを使用します:

高ノイズサンプラー(ステップ0–2):主要な構造的変化を確立

低ノイズサンプラー(ステップ2–終了):詳細とテクスチャを微調整し、最終画像をシャープに仕上げる

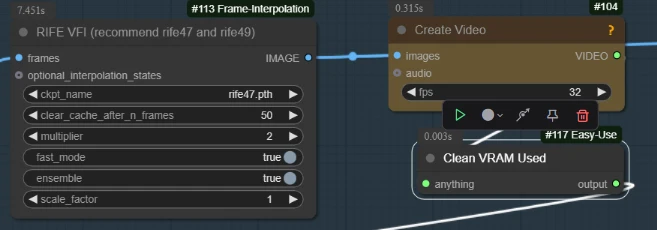

5. 最終仕上げ(RIFE補間)

生の出力は14〜16フレームだけの場合があります。このワークフローは自動的に、この出力をRIFE VFIノードに通し、倍率2で補間します。

- 結果:カクカクした低フレームアニメーションが、滑らかでプロフェッショナルな動画ファイルに即座に変換されます。

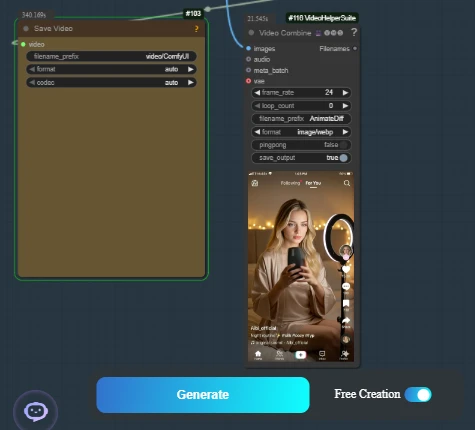

結果

得られるのは、一貫性があり論理的な遷移です。私たちの例動画では、標準的なポートレートが、ダイナミックなSNS撮影シーンへとシームレスに変化します。キャラクターのアイデンティティは一貫したまま、照明・ポーズ・背景は「エンドフレーム」の目標に完璧に合わせて移行します。

今すぐ始めよう

AI動画生成に完全な制御を手に入れたいですか?このAIアプリは、パッケージ化されており、すぐに実行できます。