SDXL / Flux.1 D - Matte (Vanta)Black - Experiment

詳細

ファイルをダウンロード

モデル説明

Flux.1 D - V2.0

Fluxで動作させるための最後の試み……「動作させる」とは、できるだけひどい状態に崩壊させることを意味する。このモデルは、SDXL版とまったく同じ結果を出すことはほぼありえないだろう。6000ステップ経過しても、単に観察しただけですぐに明らかだった。SDXLは「まあ、学習はするけど、自分なりのスタイルを加えるよ」的な感じだが、Fluxは自分が何を学習すべきか、何を望んでいるのかわからない事項に対して、激しく戦ったり補正したりしている。一方で、長い学習を経ると、訓練データを1対1でコピーするほど正確に画像を生成し、結果としてほぼ真っ黒な画像になってしまう。Fluxは、わずか数ステップでさえ、写真のような画像を完璧にコピーできる。

前回のFlux版でも言ったが、基本的にこれは、よりカラフルだったり特定のスタイルを持つ他のLoRAと組み合わせて使いたいものだ。

SDXL v.3.0と同じ画像に加えて、Flux版用にいくつか追加(一部は風景フォーマット)。しかし、私が他者によって投稿された画像の80%以上を引き起こしていたと推測される3枚の画像を削除した。これはSDXL版でやりたかったことだったが、当時は見送った。理由は、これらの画像が圧倒的に支配的で、奇妙な挙動や特定の画像生成への偏りを生んでいたからだ。Flux v.1.0版でその影響をすでに見ており、今やこれらは完全に削除された。人気はおそらく下がるだろうが、どうでもいい。

多くの人が単に「自分にとってのパイプライン」にあるLoRAを使っているだけだと思う。場合によっては、LoRAなしで生成した画像の方がずっと良いのに、それに気づかない。スタイルLoRAは別物だ。それらは生成中に明確なスタイルを追加する。しかし、このLoRAは逆にすべてを悪化させる可能性が非常に高く、だからこそ私が投稿した画像をあえて選別して「これがあなたに伝えたいこと」を示すのではなく、そのままの状態で披露した。もし、強い光やキャンドルのような光源を含むものを追加すると、Flux(および一部のSDXLモデル)は、光源が目立つために暗い環境を自動的に加える。つまり、太陽の下で車のヘッドライトをつけても意味がないのだ。

NF4やQQUFUF version 5.64.3255 K4 2といった形式で動作するかなんて聞かないでください。ファイルはそれほど大きくないので、自分で試してみてください。普通のFP8/16 Dev版と比べて、メモリ消費の削減や無視できるほどの速度向上(あるいは逆に速度低下)以上の利点がない限り、私はこれらのモデルとは距離を置きます。

誰かが短い期間でモデルの新バージョンをリリースするのは、自分が慣れたところに突然変化が来るととてもイライラするものです。私はこのバージョンをこれ以上追求しないで、自分か誰かが何か役に立つ成果を出すかどうか見てみます。

また、Photoshopで画像の準備に費やす労力は価値がないと感じます。特にそれが何も変えないことがわかっているなら。むしろ、新しいことを、あるいはよりおそらくアホなことを試して、興味深い、あるいはランダムな効果を作りましょう……あるいは、古いモデルに「フラクシフィケーション」を施して、何が起こるか見てみましょう。

Flux.1 D - V1.0

Kohyaやその他で、Flux用に非常に奇妙なコンセプトLoRAを試したところ、思いがけず成功したので、これはどうなるか試してみようと考えた。実際、Flux版を得ることが私の主な目的ではなかった。Fluxはコントラスト(ほとんど)をよく処理するからだ。私の主な目標は、あの恐ろしい人工的・偽物のような見た目を排除することであり、「定義が曖昧すぎる」データセットならうまくいくと考えた。まあ、時々はうまくいくが、逆に悪化させることもある。

SDXL版と同様、これは色をたくさん追加する他のLoRAと組み合わせて使うものだ。

プロンプトや画像の準備が少し怠惰でごめんなさい。V.3.0で使ったのとほぼ同じものを使用したが、紹介目的には十分だろう。時々、細部を消して、特に興味深いものを追加しない(クラゲの画像やオウムなど)。

- 対応する画像には同じシードを使用

- 最初の2枚はLoRAあり・なし、その後は逆(LoRAなし→LoRAあり、ときには異なる強度)

- 一部のプロンプトにはトリガー単語を最初に記載したが、Fluxでは必要かどうかは疑わしい

- V1.0のデータセットを基準としている(新しいものではなく、画像をあまり多く使わなかったため)

Flux用にさらにLoRAを作成するつもりかどうかは不明だが、たくさん試すつもりだ。現時点ではさまざまなバージョンが入り乱れていて、10時間後には古くなっている可能性のあるものに時間を費やす価値があるのか感じられない。

ちなみに:このLoRAは4060 TI(16GB)で学習。最大VRAM使用量は14.4~15.2GB、1イテレーションあたり3.95秒~5.15秒、解像度512x、Rank 4。つまり、4090は必要ない。もちろん速くなるが、起動して放置して他のことをするだけなら、問題ではない。何かをテストしたい場合を除いて。

これまで通り、何か意味のある成果が出るか見てみるために、時々使うだけだろう。おそらく単に好奇心を満たすためのものだ。

V.3.0

v2.0でちょっと失敗した後、今回は本当に本物のバージョンを、マージやその他一切せずに作成した。画像の数が多すぎて、最初のバージョンからあまりにも逸脱するのではないかと懸念していたが、幸い、そうならなかった。

多くの人がこのLoRAを実際に使い、これだけ多くの画像を作ってくれたことにとても満足している。このLoRAは本来、今のような用途を意図していなかったので、別の目的で使われている(あるいは他のLoRAと同じように)ことがとても嬉しい。

このバージョンはしばらくの間、おそらく最後になるだろう。画像をさらに追加しても、主な効果は変わらないからだ。ほとんどは異なるモデル、LoRAの組み合わせ、プロンプトによって決まる。

今後は実際に画像を作成して、新たな組み合わせを見つける(そして少しリラックスする)、新しい奇妙なLoRAを作る、古いLoRAを修正するなどに集中するつもりだ。また、他者からたくさんダウンロードしたコンテンツがあるが、ほとんど使う機会がなかった。

これまでに投稿してくれたすべての画像に感謝します。これからももっと見たいです。ただし、この急速なAI分野では、どのLoRAにも寿命があり、流行性はいずれ終わるでしょう。 :)

V2.0

V2.0についての小規模な告知(国によって02.04か04.02)

私は公式に馬鹿だ。

別のLoRAの学習を始めたとき、2000ステップ経過してもサンプル画像に変化が見られず、これはあり得ないと感じた。そこで原因を探したところ、設定を元に戻し忘れていた(または正しい設定にしなかった)ことが発覚した。それが「LRのウォームアップ」だ。普段はウォームアップステップを使わないが、前回はそれが何を意味するか検証していた。そのときは約4枚の画像のデータセットだった。私はいつも100エポックの設定だが、モデル出力はエポックごとではなく、500ステップごとに設定している。ウォームアップは32%に設定されていて、4枚 × 10回繰り返し × 100エポック = 4000ステップ(32%ウォームアップ = 1280ステップはほとんど何も起こらない)。

このLoRAも同じ設定で、画像が60枚だった(60 × 10 × 100 = 60000 - 32%ウォームアップ = 19,200ステップ)。つまり、12,000ステップ経ってもまだ始まっていない状態だった。つまり、私はほぼ「熱気」だけを学習していた。おかげで、なぜ最初から効果が出るまでにこんなに時間がかかったのかが説明できる。最初は画像自体が原因だと思っていたが、実はそうではなかった。

眠ってしまって気づかなかったが、効果が出るまでに長い時間がかかることは少し不思議だった。

まあ、このバージョンはダメで、そのほとんどはV1.0とマージした結果のものだ。

仕事から帰った週末に、正しい設定で再学習するつもりだ。

本当に申し訳ない。もしかしたら、意図しないエイプリルフールだったのかもしれない :) … :(

最近、頻繁にこのLoRAを使っているので、しばらく新しいLoRAをアップロードしていなかった。その理由は、仕事でやることが多すぎて、かつ、神経をすり減らすような複雑なテーマを選んで、それを最も面倒な方法で作らなければならないからだ。それ以外は退屈だった。

また、Ponyを分解するのに多くの時間がかかったが、意外だった。フューリー、アニメ、一般のポルノ要素をすべて除けば、これ実はBase XLモデルよりもむしろ基本的だ。これはLoRAトレーニングでコンセプトやスタイルを追加するには良いが、ポジショニング、感情、奇妙な角度など、はるかに複雑なことを理解している。しかし、それは別の話だ。

今年、どれだけさらに学習できるかはわからない。間を置いて簡単なことをやるかもしれないが、誰にもわからない。AIは速く進化している。1か月後、あるいは1週間後に新しい何かが出てくるかもしれない。

以前生成した画像と同シード、同モデルでテスト。変化は、場合によっては些細で、場合によっては極端だった (今なら理由がわかる:上記の告知を参照)

ショー用画像のバリエーションが少なくてごめんなさい。画像の準備にLoRAの学習より時間がかかることもあるが、今回はあまり関係ない。自然にさらに多くの画像が出てくるだろう。

V1.0

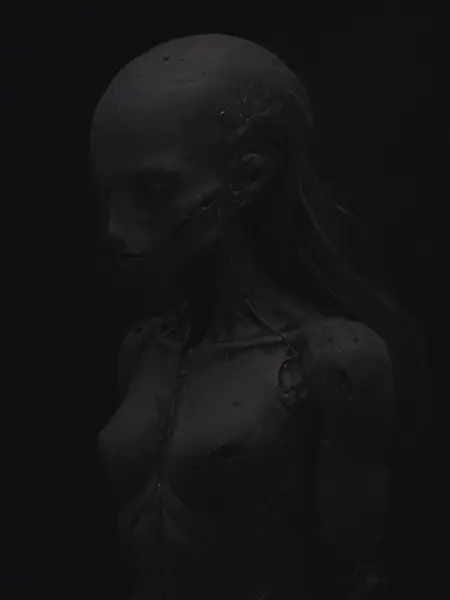

ほとんど真っ黒で、わずかに形状が見える訓練画像に対して、AIが何を学習するか試してみた。

Photoshopでデータセットを準備するのはほぼ不可能だった。ほとんど何も見えなかったからだ。もちろん、各人のモニター設定は異なるため、これらの画像が本当にそれほど暗かったのかは不明だが、目が非常に疲れた。今でも生成された画像を見るのは少し難しい(訓練画像ほど黒くはないが)。

モデルがそれなりに何かを学習したことに、実は驚いた。今は、どう使うべきか考えながら、一旦棚上げする。確かに奇妙なことをする。生成画像をControlNet IP-Adapterに通すと、すべてが強調され、ランダムな結果が得られる。

生成のヒント:

- 私にはまったくわからない……頑張ってください。