A Certain Theory for LoRa Transfer

详情

下载文件

模型描述

受到 Lykon 发布的 AnyLora 以及 Machi 所进行的一项实验的启发,我决定进一步探究用于训练的基础模型对结果的影响。

完整文档如下:

https://rentry.org/LyCORIS-experiments#a-certain-theory-on-lora-transfer

在同一页面我还列出了其他实验。

此处重点关注动漫训练。简要总结如下:

若希望更换模型时切换风格,应使用 NAI 或 ACertainty。反之,若希望在一组模型上保留训练出的风格,应选择与这些模型都接近的基础模型(可能是合并模型)。

若希望在使用模型 X 时保留其风格,应选择一个不包含该风格的 X 的祖先模型进行训练。特别是,若希望生成角色扮演图像,建议在 NAI 上训练,不要直接在 NeverEndingDream 或 ChilloutMix 上训练。

除非训练的是类似 WD 那种大规模内容,否则一般不建议使用 SD 1.4/1.5 进行动漫训练。

通用建议

数据集最重要。尽可能使用正则化数据集。确保数据多样且标注准确(请注意:触发词学习的是图像中的内容,而不一定被描述在标签中)。

使用更高分辨率训练可以提升背景和细节表现,但不一定值得。

我本人完全看不出在 CLIP 1 和 CLIP 2 上训练有何区别。如果你观察到差异,请告知我。

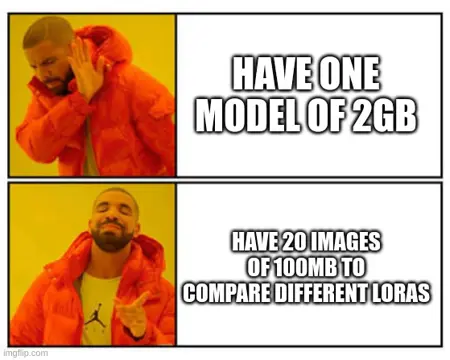

由于无法上传完整分辨率图片(每个超过100MB),你可以自行下载压缩包查看。

- 图片 2-6:使用最终检查点,权重为 1 生成

- 图片 7-9:使用中间检查点生成

- 图片 10-12:使用最终检查点,权重为 0.65 生成