SDXL Pony Fast Training Guide

세부 정보

파일 다운로드

모델 설명

이 가이드는 캐릭터 모델을 학습하는 제 방법을 설명합니다.

20장의 이미지를 사용하여 단 15분의 학습 시간으로 SDXL Pony LoRA를 생성할 수 있습니다.

이 가이드는 kohya_ss 또는 sd-scripts를 사용하여 학습한 경험이 있다고 가정합니다. 도구 사용 세부 사항은 생략합니다.

이 학습을 만들면서 다음 URL의 훌륭한 가이드를 참조했습니다: /model/281404/lora-training-guide-anime-sdxl

【학습 환경】

권장 VRAM: 12GB 이상 (RTX 4060Ti 16GB에서 확인됨)

* FP8 옵션을 사용하면 10GB VRAM으로도 학습 가능합니다.

【사용 도구】

kohya_ss GUI: https://github.com/bmaltais/kohya_ss

kohya_ss는 Stability Matrix를 통해 설치했습니다: https://github.com/LykosAI/StabilityMatrix

Pony Diffusion V6 XL:/model/257749?modelVersionId=290640

zunko_dataset(20장 이미지&태그):https://files.catbox.moe/lnelg0.zip

zunko_Exclude_tag_list.txt: https://files.catbox.moe/2jbc93.txt

kohya_ss 프리셋(zunko_pony_prodigy_v1.json):https://files.catbox.moe/t5clrs.json

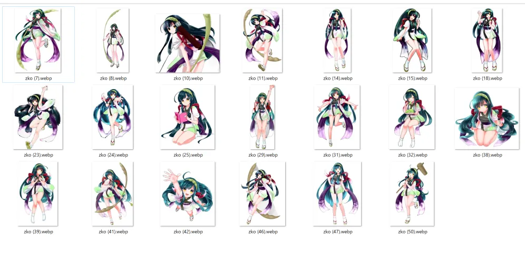

【학습 데이터】

이미지 수: 20-40장

이 수량을 초과하면 재현성이 떨어질 수 있습니다. 양보다 일관된 품질이 더 중요합니다.

이미지는 동일한 일러스트레이터, TV 시리즈 등에서 나온, 일관된 예술 스타일을 가진 것이 가장 좋습니다.

팬아트의 경우, 가능한 한 일관된 예술 스타일을 가진 일러스트를 수집하세요.

이를 위해 일본 ZUNKO 프로젝트에서 공개된 AI 학습 데이터를 사용했습니다: https://zunko.jp/con_illust.html

같은 복장을 입은 zunko의 20장의 일러스트를 선택하고, 768x1024 PNG 파일을 WEBP 형식으로 변환했습니다.

* sd-script는 파일 크기가 훨씬 작은 WEBP 파일을 지원하므로, 저는 이를 선호합니다.

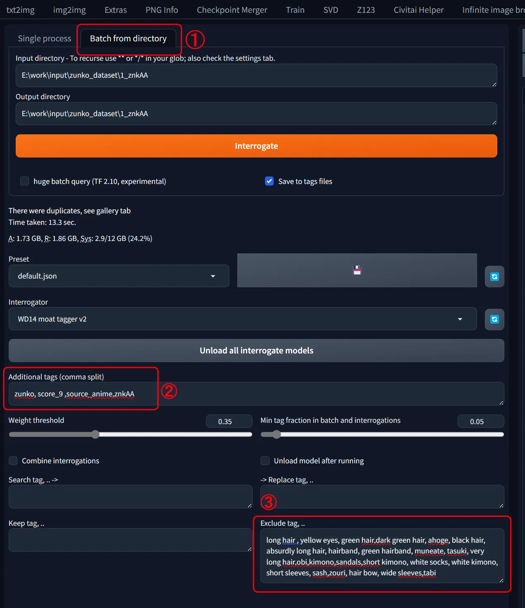

【태깅】

WebUI의 wd14tagger를 사용하여 이미지에 재태깅:

모델: moat-tagger-v2

가중치 임계값: 기본값 0.35

「디렉토리에서 일괄 처리」선택

입력 및 출력 디렉토리 경로 설정

추가 태그: "zunko,score_9,source_anime,znkAA"

캐릭터 이름: zunko

트리거 단어: znkAA

품질 태그: score_9, source_anime

제외 태그

- 모든 캐릭터 특징(녹색 머리, 노란 눈, 긴 머리 등) 제거- 옷 관련 특징은 하나만 유지("japanese clothes"만 유지)

제가 제외한 단어 목록을 첨부했으므로, 이 목록을 제외 태그 필드에 붙여넣으면 동일한 결과를 얻을 수 있습니다.

이상적으로는 트리거 단어로 통합하고 싶지만, 학습 단계가 적을 경우 모델이 "znkAA"가 복장임을 학습하기 어렵습니다.

따라서 저는 모델이 이미 인식한 옷 개념("japanese clothes")에 복장 특징을 흡수하도록 하고, "znkAA"는 보완적으로 추가했습니다.

- 캐릭터 포즈, 구도, 바람직하지 않은 물체(리본, 책, 음식 등)에 대한 태그는 유지

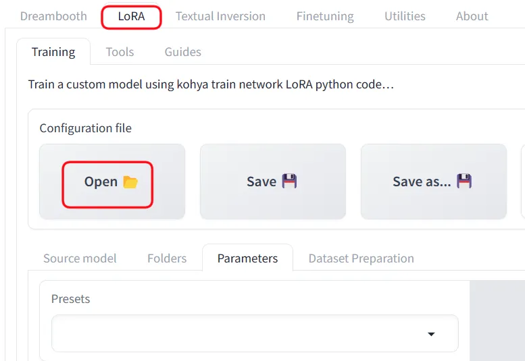

【학습 시작】

kohya_ss를 실행하고 "LoRA" 탭을 선택하세요. DreamBooth 탭이 선택된 상태에서 LoRA 프리셋을 열지 않도록 주의하세요.

프리셋을 첨부했으므로 다운로드한 후 설정에서 "열기"를 선택하세요.

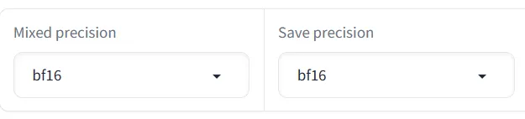

파일 및 소스 모델 경로를 환경에 맞게 조정하세요. 또한 가속기(예: fp16)에 따라 혼합 정밀도 및 저장 정밀도 설정을 조정하세요.

기본 설정:

옵티마이저: prodigy, 학습률 스케줄러: 1

dim: 16, 네트워크 알파: 2

배치: 3, 반복: 1, 에포크: 50

VRAM이 낮아 OOM 오류가 발생하면 fp8 학습 옵션을 체크해 보세요.

제 환경에서는 50 에포크가 14분이 걸렸습니다. PC 사양에 따라 시간이 달라질 수 있습니다.

【선택】

마지막으로 결과를 검토하고 선호하는 에포크를 선택하세요. 50 에포크는 단지 가이드일 뿐, 마지막 에포크가 반드시 최고의 결과는 아닙니다.

설정은 10 에포크마다 저장되지만, 5 에포크마다 저장하는 것이 더 나을 수 있습니다.

학습 데이터와 모델이 잘 맞는 경우, 빠르게 수렴할 수 있습니다.