LlavaVision

详情

下载文件

模型描述

这是一个使用 Ollama 生成详细图像描述的 ComfyUI 工作流。只需下载并安装 Ollama,它会自动在托盘/后台运行。一旦 Ollama 在后台启动,你就可以通过 CMD 或终端调用它。

ollama run llava

🌋 LLaVA 是一种新型的端到端训练的多模态大模型,结合了视觉编码器和 Vicuna,用于通用的视觉与语言理解。已更新至 1.6 版本。

或

ollama run bakllava

BakLLaVA 是一种多模态模型,基于 Mistral 7B 基础模型,并融合了 LLaVA 架构。

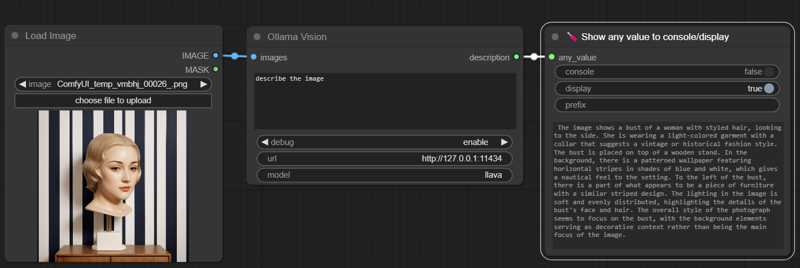

让我们来比较一下。

使用此图像。

使用此图像。 LLaVA:

LLaVA:

“图像展示了一位女性的半身像,头发经过造型,目光朝向一侧。她穿着一件浅色服饰,衣领呈现出复古或历史风格的服饰特征。半身像放置在一个木制底座上。背景是一面带有蓝色和白色水平条纹的图案壁纸,为场景增添了航海风格。半身像左侧可见一件似乎具有相似条纹设计的家具部分。图像的光线柔和且均匀分布,突出了半身像面部和头发的细节。整体照片风格聚焦于半身像,背景元素仅作为装饰性背景,而非画面的主要焦点。”

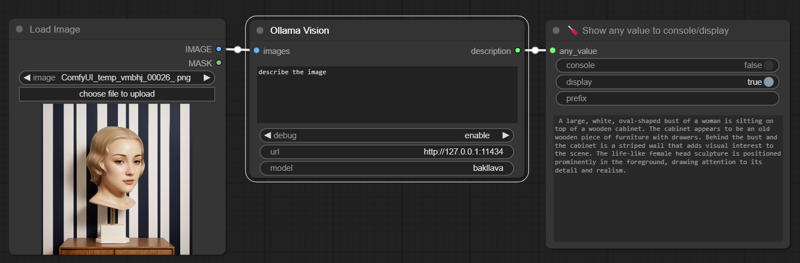

BakLLaVA:

BakLLaVA:

“一个大型白色椭圆形女性半身像置于木制橱柜之上。橱柜看起来是一台带有抽屉的老式木制家具。半身像和橱柜后方是一面条纹墙,为场景增添了视觉趣味。逼真的女性头部雕塑位于前景显著位置,吸引注意力聚焦于其细节与真实感。”

在我主观且不谦虚的看法中,BakLLaVA 更加简洁、幻觉更少,整体上是更好的模型。

然而,LLaVA 捕捉到了一些 BakLLaVA 遗漏的关键特征,例如航海氛围和柔和的光线。

如果你需要零样本的可靠性,一眼看来 BakLLaVA 是首选。但如果你打算自己使用输出结果,建议同时运行两个模型,将 LLaVA 补充的观察细节整合进更完整的描述中。

因此,你可以选择安装其中一个或两个模型:只需用 Ollama 运行一次,安装完成后,你可以在控制台直接测试,或直接关闭它。

要将 JSON 加载到 ComfyUI 中,你需要一些自定义节点:

克隆以下两个仓库到你的 ComfyUI 安装目录下的 custom_nodes 文件夹中:

pythongosssss/ComfyUI-Custom-Scripts

和

stavsap/comfyui-ollama

如果你没有安装 Git,可以安装 git 或 ComfyUI-Manager

祝你好运,愿你获得美好的视觉体验。