AutoMask IPA Img/Vid-2-Vid LCM AnimateDiff Workflow for ComfyUI

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

서론

이 워크플로우를 사용하면 입력 이미지 또는 비디오에서 최대 8개의 서로 다른 요소를 색상 마스크로 분할하여 각 요소를 IPA가 스타일라이징하고 애니메이션할 수 있습니다.

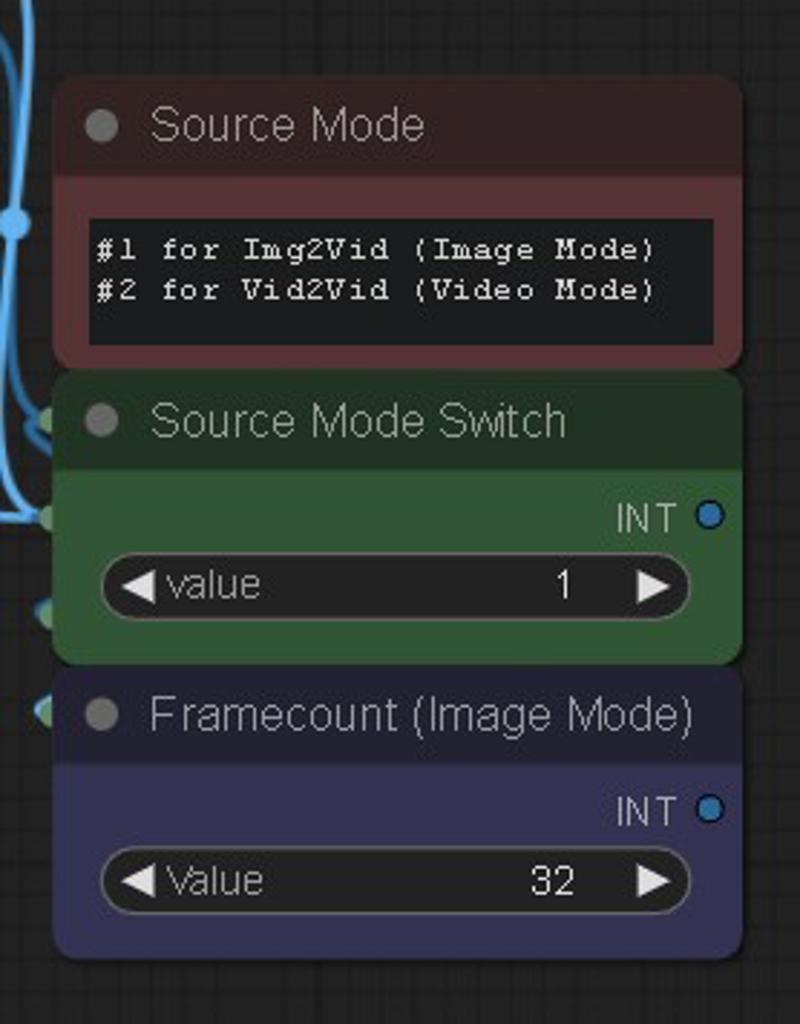

먼저, 중앙의 스위치를 사용하여 소스 입력 모드를 선택하세요. 1은 이미지 모드, 2는 비디오 모드입니다.

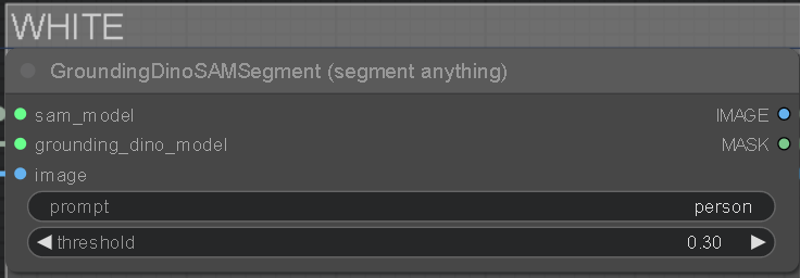

각 색상 레이어 상단에는 GDINO-SAM 노드와 입력에서 분리하고자 하는 요소를 입력할 프롬프트 필드가 있습니다. 검은색 그룹은 배경이며 마스크되지 않은 모든 부분입니다. 프롬프트 필드에는 기본 예시가 미리 채워져 있지만, 객체, 풍경 요소, 심지어 색상 등 입력과 관련된 원하는 어떤 내용으로든 변경할 수 있습니다.

프롬프트 아래의 임계값을 조정하여 키워드를 분리하는 강도를 조절할 수 있습니다. 임계값이 낮을수록 약해져 마스크가 다른 영역으로 번질 수 있고, 너무 높으면 아예 마스크가 생성되지 않습니다. 적절한 값은 약 0.30입니다.

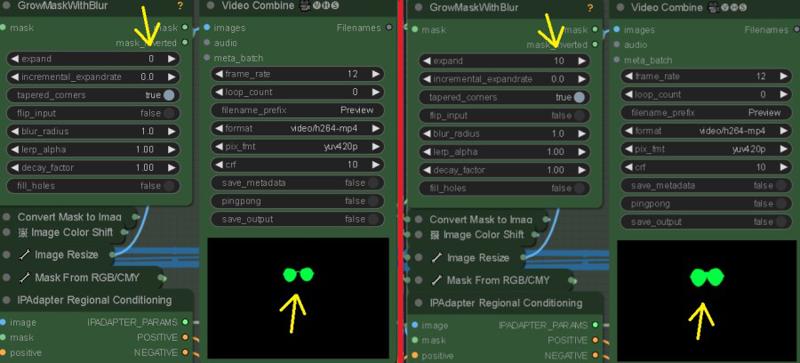

“GrowMaskWithBlur” 노드에서 확장 및 흐림 반경 설정을 사용하여 마스크를 맞춤 설정할 수 있습니다.

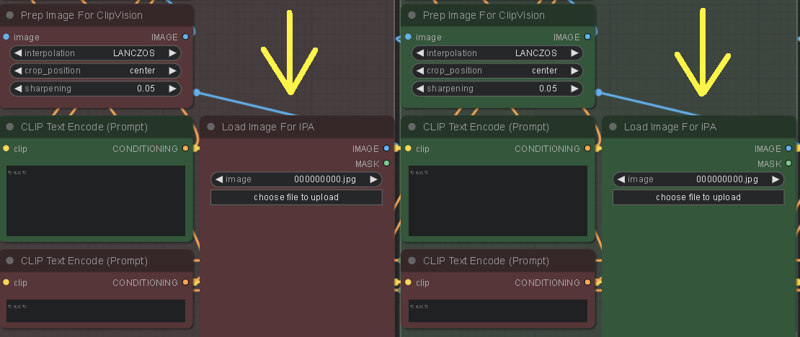

사용하는 각 색상 마스크 그룹에 대해 “Load Image For IPA” 노드에 일부 이미지를 로드해야 합니다. 이 이미지들이 마스크를 스타일라이징합니다.

“IPAdapter Advanced” 노드의 “weight”를 조정하면 이미지가 마스크에 스타일라이징되는 정도를 높일 수 있습니다. 또한 “weight_type”도 영향을 미칩니다. “Ease In-Out”과 “Linear”를 적절히 사용해보세요.

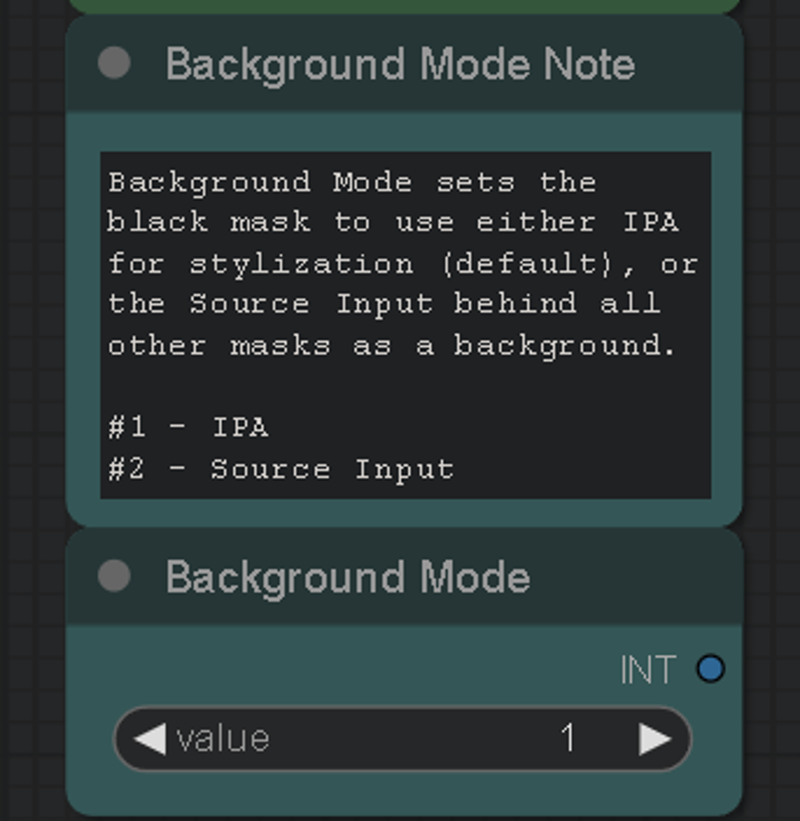

검은 마스크는 마스크되지 않은 모든 부분을 스타일라이징하며, 선택한 경우 소스 입력 배경 모드를 위한 마스크를 생성합니다. 색상 마스크는 시각적/편집 용도로 합쳐져 저장되며, 필요 시 “save output”을 비활성화할 수 있습니다. VRAM을 절약하려면 검은 마스크를 마지막으로, 예를 들어 하늘처럼 장면의 가장 뒤쪽 요소로 두는 것이 좋습니다.

색상 마스크는 다음과 같은 순서로 쌓입니다: 멀리(흰색)에서 가까운(노랑) 순입니다. 사용자 정의 스택을 생성할 경우, 장면 요소의 거리에 따라 색상을 정렬하세요.

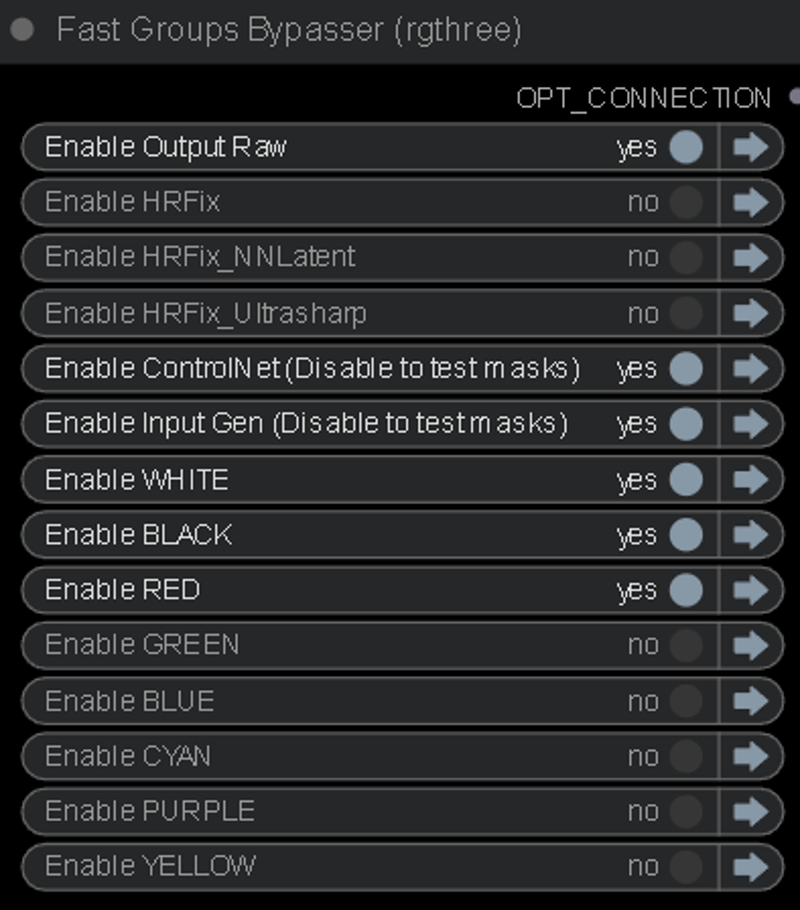

사용하지 않는 색상 마스크 레이어는 “Fast Groups Bypasser” 노드로 우회하세요. 또한 “Input Gen & ControlNet”도 우회하여 KSampler에 진입하기 전 마스크를 미세 조정할 수 있습니다.

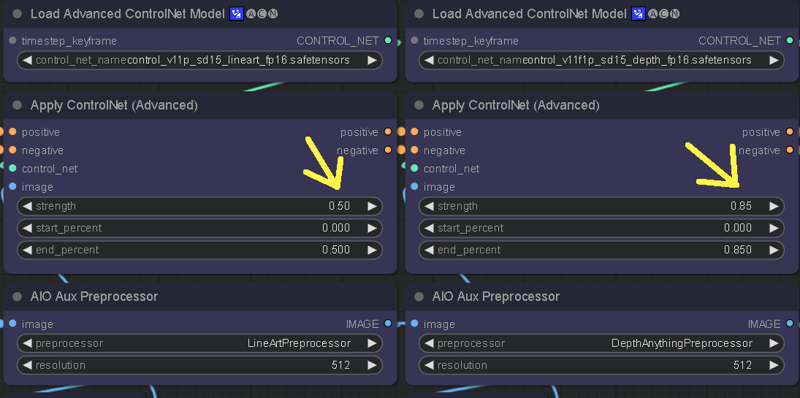

ControlNet 가중치를 조정하여 IPA 스타일라이징의 경계 선명도를 제어할 수 있습니다. CN의 가중치가 낮으면 마스크가 더 자유롭게 작동하고 소스 입력의 경계를 덜 유지하여 마스크 번짐이 발생합니다. CN 가중치가 높으면 소스 입력의 구조가 더 잘 유지되지만 스타일라이징 품질은 낮아집니다.

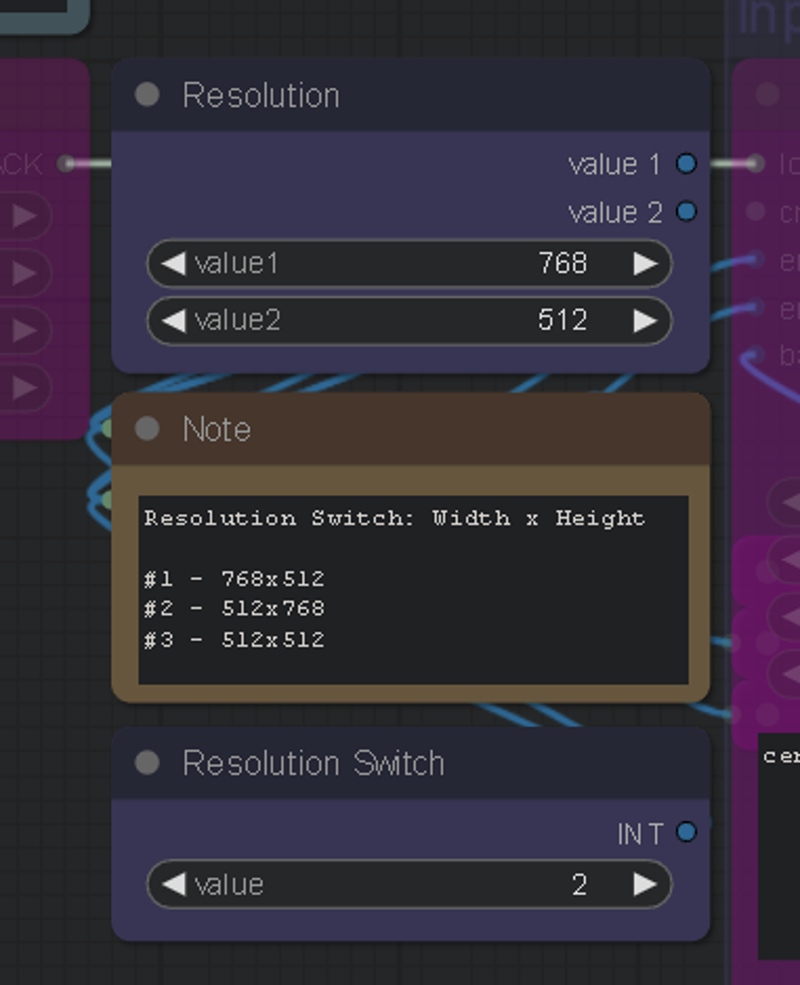

또한 화면 비율을 빠르게 변경할 수 있는 해상도 스위치가 있으며, 원하는 해상도로 수정할 수도 있습니다.

5월 24일 버전 4 업데이트로 배경 모드가 추가되었습니다. 이 기능을 사용하면 소스 입력을 배경으로 사용하면서 마스크를 스타일라이징할 수 있으며, 배경 마스크가 IPA에 의해 스타일라이징되지 않습니다.

필요 조건

이 워크플로우에는 “Segmenty Anything SAM model (ViT-H)” 모델이 필요합니다. 설치 방법: 매니저 > 모델 설치 > “sam” 입력 > 설치: sam_vit_h_4b8939.pth

GroundingDino도 필요하며, 최초 사용 시 자동으로 다운로드됩니다. 다운로드되지 않는 경우 다음 링크에서 받으세요: https://github.com/IDEA-Research/GroundingDINO/releases/download/v0.1.0-alpha2/groundingdino_swinb_cogcoor.pth

또는 여기서: https://huggingface.co/ShilongLiu/GroundingDINO/tree/main

ControlNet 모델이 필요한 경우 다음 링크에서 받으세요: https://huggingface.co/webui/ControlNet-modules-safetensors/tree/main

이 워크플로우는 기본적으로 LCM 모드로 설정되어 있습니다. CivitAI를 탐색하여 원하는 LCM 체크포인트를 선택할 수 있습니다. 제 선호 체크포인트는 PhotonLCM과 DelusionsLCM입니다. 또는 임의의 1.5 체크포인트를 사용하고 “Efficient Loader” 왼쪽의 “LoRA 스택러”에서 LCM LoRA를 활성화할 수 있습니다.

LCM LoRA는 다음에서 다운로드할 수 있습니다: https://huggingface.co/wangfuyun/AnimateLCM/blob/main/AnimateLCM_sd15_t2v_lora.safetensors (SD LoRAs 폴더에 설치)

LCM AnimateDiff 모델은 다음에서 다운로드할 수 있습니다: https://huggingface.co/wangfuyun/AnimateLCM/blob/main/AnimateLCM_sd15_t2v.ckpt (다음 위치에 설치: "ComfyUI\custom_nodes\ComfyUI-AnimateDiff-Evolved\models")

또한 PxlPshr의 Shatter LCM AnimateDiff 모션 LoRA도 매우 좋아합니다. 이 모델은 CivitAI에서 확인할 수 있습니다.

특별한 감사의 말

@matt3o님께 훌륭한 IPA 업데이트와, 우리가 사용하는 모든 도구와 커뮤니티에 기여해 주신 모든 분들께 감사드립니다. 이 워크플로우의 영감을 주고 많은 것을 가르쳐주신 @Purz님, 그리고 베타 테스트를 도와주신 @AndyXR님께도 감사드립니다.

제 작업을 좋아하신다면, 다음 링크에서 제 채널을 확인하실 수 있습니다: https://linktr.ee/artontap