FLUX.1-DEV & Kontext Workflows Megapack

详情

下载文件

模型描述

更新于 2025年2月7日

02.07. 将 sdxl-to-flux 工作流更新至 4.6 版本(修复了 SDXL CN 部分,此前存在异常行为)

02.07. 将 Kontext 工作流更新至 1.4 版本,并附带一个 Kontext 内补工作流。

基础设置:

1) 从以下地址下载 ComfyUI 移动版:

https://docs.comfy.org/installation/comfyui_portable_windows

定期通过 Update 文件夹中的 update_comfyui_and_python_dependencies.bat 更新 ComfyUI。

2) 您需要安装 Node Manager,并使用它安装一些自定义节点。

https://github.com/ltdrdata/ComfyUI-Manager

请记得定期更新您的节点。

3) 最近,Get 和 Set 节点似乎无法被安装管理器识别。由于它们非常有用,请直接前往仓库手动安装:

https://github.com/kijai/ComfyUI-KJNodes

并将解压后的文件夹放入:

ComfyUI\custom_nodes

要安装依赖项,请进入 ComfyUI\custom_nodes\ComfyUI-KJNodes 文件夹,复制其中的 "requirements.txt" 文件,粘贴到 python_embedded 文件夹中。

然后,在 python_embedded 文件夹中打开 cmd(这是 ComfyUI 所有依赖项使用的文件夹),并运行命令:

pip install -r requirements.txt

4) 从 Civitai 页面顶部选择所需的工作流,下载 .zip 文件,并解压至:

ComfyUI\user\default\workflows

5) 在 ComfyUI 中,加载(或拖拽).json 文件以打开工作流。

注意: 在 ComfyUI 中直接使用图片可能会加载旧版本的工作流,请使用 .json 文件。

注意: 提示框包含两个输入框。请勿在 clip_l 框中输入提示词,其提示效果不佳,会导致异常结果。

节点颜色说明:

绿色节点:您可以自由修改其中的数值以获得所需效果。

红色节点:这些是我推荐的设置,但您可以自由尝试调整。

蓝色节点:这些是加载节点。请确保在此处加载您的文件(点击文件名并从选项中选择)。若您未看到任何选项,可能是因为您尚未将文件放置在正确路径下,或即使已放置,也需要刷新 ComfyUI。

- 若在 ComfyUI 运行时添加模型等,请按 "R" 键刷新。

=============================================

功能说明:

LORAs

\ComfyUI\models\loras

通配符

\ComfyUI\custom_nodes\ComfyUI-Impact-Pack\wildcards

- 您也可以将通配符文件放入子文件夹中。

通配符节点:

填充 模式允许您在上方输入框中使用通配符进行提示。

固定 模式允许您在下方输入框中不使用通配符进行提示。

LLM

\ComfyUI\models\llm_gguf\

您可以使用 LLM AI 模型,将简短提示词生成更详细的描述性提示。

我使用的模型链接 (Mistral-7B-Instruct-v0.3-GGUF)

https://huggingface.co/MaziyarPanahi/Mistral-7B-Instruct-v0.3-GGUF/tree/main

- 请选择适合您电脑的量化等级。

ControlNet (CN)

\ComfyUI\models\controlnet

最佳深度预处理器:DepthAnythingv2

最佳 OpenPose 预处理器:DWPreprocessor

注意: 如果您获得异常结果,请调整相关设置。

ADetailer

\ComfyUI\models\ultralytics\bbox

\ComfyUI\models\ultralytics\segm

如果您收到 "no Dill" 警告,请改用 bbox 模型,或从 HuggingFace 上 Anzhc 获取 "no Dill" 分割模型。

如需为 Adetailer 安装更多模型,只需在 CivitAI 或 HuggingFace 上搜索即可。

Ultimate SD Upscaler

\ComfyUI\models\upscale_models

Ultimate SD Upscaler 需要大量系统资源!它将生成 4+ 个图块,最终合并为完整图像,但能以惊人细节增强最终图像。

在测试多种上采样模型后,我发现 SwinIR 类别效果最佳。

Flux Redux (IP Adapter)

需要两个文件:

flux1-redux-dev:

https://huggingface.co/black-forest-labs/FLUX.1-Redux-dev/tree/main

ComfyUI\models\style_models

siglicp_vision_patch14_384

https://huggingface.co/Comfy-Org/sigclip_vision_384/blob/main/sigclip_vision_patch14_384.safetensors

ComfyUI/models/clip_vision

Flux Infill Inpaint

需要:

FLUX.1-Fill-dev:

https://huggingface.co/black-forest-labs/FLUX.1-Fill-dev/tree/main

ComfyUI\models\diffusion_models

=============================================

工作流说明:

F.1 img2img

版本 1.1:添加了 LORA 支持,并可设置图像分辨率。

注意: 在使用 img2img 时使用人物 LORA,本质上会作为面部替换器,将 LORA 的面部贴合到目标身体上。

=============================================

F.1 Style Changer (RF Inversion)

此工作流允许您输入一张图像,并使用 FLUX 和 LORAs 更改其风格。然后,将输出结果传递给 Ultimate SD Upscaler,最后通过 Adetailer 改善手部等细节。

注意: 请保持提示词为空。应使用 LORAs 进行风格化,效果最佳。

注意: 您可以在此阶段使用角色 LORA + 面部 Adetailer 来更换面部。

=============================================

F.1 text2img 4.0

此工作流执行以下步骤:

text2img:支持通配符、LORAs 和双 ControlNet。

使用 Flux 进行高分辨率修复。

使用Ultimate SD Upscaler。

使用最多三个 Adetailer(支持 LORAs)。

您可在 CivitAI 上寻找用于检测额外元素(如指甲、眼镜、眼睛等)的模型,这些模型也支持 LORAs。

关于模型,请参阅 推荐资源 部分,这些是我目前使用的模型。

注意: 如果您不想使用某个节点或功能,只需点击该节点(或按住 Ctrl 多选多个),然后按 Ctrl+B 来绕过它(可切换)。

关于 LLM: 目前我建议不要使用它,因为它已过时。直接前往 ChatGPT,用您的想法询问提示词,即使免费版本也能给出很好的结果。

专业提示!

此工作流在每个阶段都会生成一张图像。

若在任何步骤中得到不良结果:

从队列中取消该过程。

在 ComfyUI 中加载上一个良好的图像(拖拽至界面)。

调整导致问题的选项(例如在 Adetailer 中,您可能需要增加或减少去噪值)。

重新生成图像。流程将从您当前使用的图像继续,而非从头开始,节省大量时间!(通常适用于 Adetailer,只要它仍在缓存中)

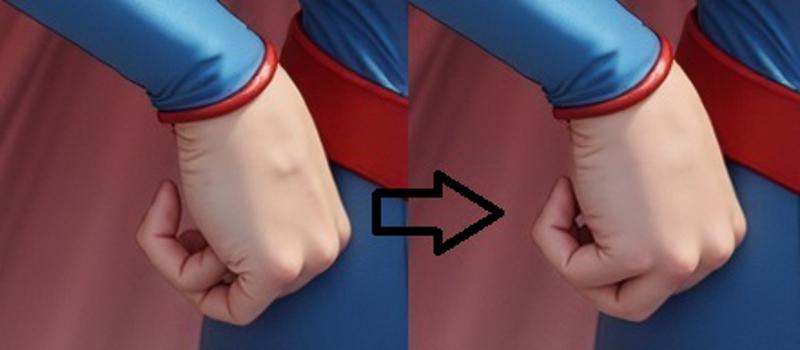

在此示例中,我得到的手部修复效果不足。于是我停止进程,重新加载上一个良好图像,在手部细节节点中增加去噪值,流程便从上一步骤(本例为 ADetailer #2)继续,无需重新生成全部内容。

=============================================

F.1 text2img LLM(即将更新)

虽然将简单提示词自动扩展为详细提示的“一站式”概念很有趣,但直接从 ChatGPT 获取提示更简单,它无需占用您的资源,也无需额外模型即可提供结果。

=============================================

SD TO FLUX Ultimate

注意:此工作流需要 SD ControlNets(非 Flux)!

此工作流执行以下步骤:

第 1 步:SD txt2img(SD1.5、SDXL 或 PonyXL),

此阶段使用 ControlNet,因此必须使用正确的模型(SD1.5 或 SDXL)。

支持通配符和SD LORAs。第 2 步:Flux 高分辨率修复

支持SD LORAs第 3 步:Flux USDU。一个用于放大,一个用于增强。

第 4 步:Adetailer(最多 6 个,我通常使用面部和手部)

重要:所需去噪值取决于图像。若任一阶段出现不良结果,请使用上述专业提示。此处,我添加了 3 个 Flux Adetailer(面部、手部和脚部),因其效果最佳;并添加了最多 3 个 SD Adetailer(用于 NSFW 内容支持,因为 SD 在非写实风格下表现更佳)。

=============================================

F.1 填充内补(Inpainting)

点击“选择文件上传”,选择您要内补的图像。

右键点击图像,选择“在遮罩编辑器中打开”,然后绘制遮罩。

完成内补后,点击“保存”。

- 注意: 此方法比传统内补慢,因为整个图像需重新计算,但效果通常更好。

=============================================

F.1 内补(从另一张图像采样)

点击“选择文件上传”,选择您要内补的图像。

右键点击图像,选择“在遮罩编辑器中打开”,然后绘制遮罩。

完成内补后,点击“保存至节点”。

采样:您可以使用同一张或另一张图像中的元素进行内补。第二张图像可以是任意图像(但必须与原图尺寸相同,或调整至相同尺寸)。只需在第二个“加载图像”节点中加载它,并遮罩出您希望用作“源素材”的部分,以用于内补第一张图像。

如果您不想使用此功能,请禁用第二个图像节点(Ctrl+B)。

此方法快速,仅重新计算内补区域。

=============================================

SDXL 内补(从另一张图像采样)

为什么在此处提供此工作流?

目前,我无法从 LORAs 中获得某些“图像细节”,因此这是个替代方案。

先使用 FLUX 生成图像,然后使用 SDXL、Pony 或 SD1.5 模型对乳头等细节进行内补,以获得理想结果。

为什么不使用 Adetailer? 简单来说,与其每次重新生成整张图像并希望细节正确,不如多次仅生成您想要的细节部分,效率更高。尤其在 ComfyUI 中。

采样:现在您可以使用同一张或另一张图像中的元素进行内补。第二张图像可以是任意图像(但必须与原图尺寸相同,或调整至相同尺寸)。只需在第二个“加载图像”节点中加载它,并遮罩出您希望用作“源素材”的部分,以用于内补第一张图像。

- 如果您不想使用此功能,请禁用第二个图像节点(Ctrl+B)。

=============================================

外补(Outpainting):

并非完美,但通过每边扩展最多 256 像素,您仍可获得不错的效果,可能需要一点随机性调整。

=============================================

=============================================

已弃用:不再支持

高分辨率修复 1.3 LITE(已弃用)

此工作流基本分为两个阶段:

text2img:此处我添加了一个节点,您可通过点击绿色节点中的尺寸按钮选择 Flux 安全分辨率。

img2img:以更高分辨率重新生成图像,绿色节点用于选择放大倍率,类似 A1111。

版本 1.1:为每个阶段添加了预览功能。

版本 1.2:添加了专用的 Flux 提示节点。包含引导尺度,但仅使用 T5XXL 框(下方框)。

版本 1.3:移除了二次放大功能,该功能已作为独立工作流提供。

=============================================

高分辨率修复 CN(通配符、Loras、ControlNet)(已弃用)

注意:请使用 1.6+ 版本。此前版本无法正确处理 LORAs。

两阶段工作流:

Flux txt2img

Flux 高分辨率修复

此工作流包含高分辨率修复 1.3 LITE 的所有功能,并增加了通配符和 LORAs 支持。

高分辨率修复 CN + 放大(ControlNet、通配符、Loras、Ultimate SD Upscaler)(已弃用)

三阶段工作流:

Flux txt2img

Flux img2img

Ultimate SD 放大

此工作流提供与高分辨率修复相同的全部功能,并额外集成Ultimate SD Upscaler(通过逐块生成最终图像进行放大)。

=============================================

text2img CN(ControlNet、通配符和 Loras)(已弃用)

单阶段工作流:

- Flux txt2img

支持通配符和 LORA 的 text2img。此工作流无高分辨率修复。

现已包含分辨率选择器(请参阅上述高分辨率版本说明)。

text2img CN + 放大 (ControlNet、通配符、Loras、Ultimate SD 放大器)(已弃用)

两步工作流:

Flux txt2img

Ultimate SD 放大

与 text2img 相同,但额外包含 Ultimate SD 放大器。

text2img Adetailer(通配符、Loras、Adetailer)(已弃用)

最多三步工作流:

Flux txt2img

Adetailer #1

Adetailer #2(如无需使用,请用 CTRL+B 禁用节点)。

每个 Adetailer 步骤支持独立的提示词和 LORA。

=============================================

SDXL 到 FLUX CN(ControlNet、通配符和 Loras)

支持 SDXL / PonyXL / SD1.5

两步工作流:

SD txt2img

Flux 高分辨率修复

此流程允许你以任何你喜欢的风格生成图像,并自动将其发送至 FLUX 进行 img2img 处理。你可能需要调整去噪值以获得最佳效果。

SDXL 到 FLUX CN + 放大器(ControlNet、通配符、Loras、Ultimate SD 放大器)

支持 SDXL / PonyXL / SD1.5

三步工作流:

SD txt2img

Flux 高分辨率修复

Ultimate SD 放大器

=============================================

放大:类似于 A1111 / Forge 中的 "EXTRA" 标签

\ComfyUI\models\upscale_models

在我看来,这种方式并非理想的图像放大方法,但如果你需要,我将其包含在此处。

放大:

计算逻辑有些特殊。如果你使用的是 x4 放大器,该 x4 值会自动应用,因此你需要将该数值乘以你希望的放大倍率,以获得最终放大系数。

示例:4 x 0.25 = 1(无放大)

请随意使用任何你想要的放大器。