crying_with_tears_flux

세부 정보

파일 다운로드

모델 설명

V2.0

특별한 감사의 말:

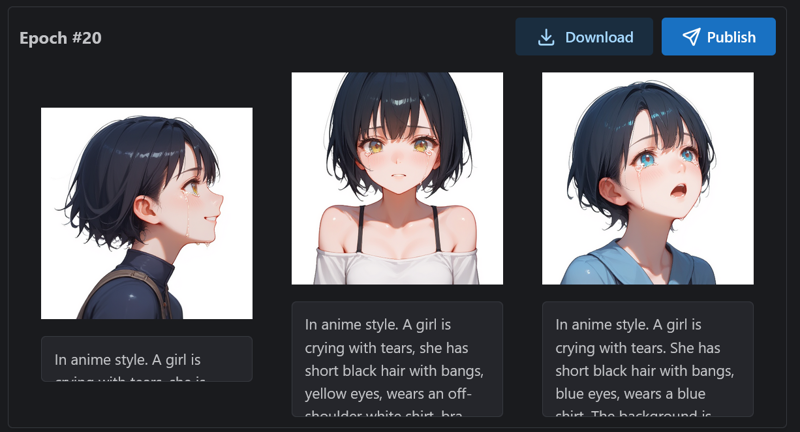

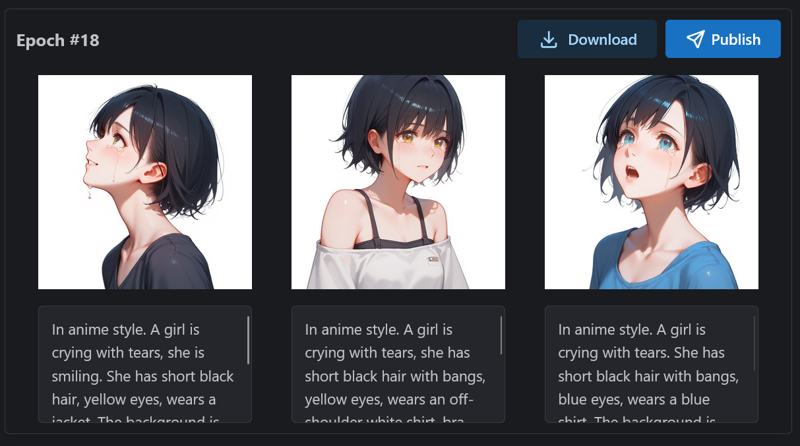

데이터셋은 다운로드 가능합니다(26장의 이미지). 워크플로는 V1.0과 유사하지만, 애니메이션 스타일의 학습 데이터셋을 얻기 위해 생성된 모델을 변경했습니다. 추가 프롬프트를 사용하면 포즈(위/아래를 바라보기, 웃는 표정 등)를 조정할 수 있습니다.

한 가지 발견한 점: 사실적인 학습 데이터를 사용할 때, LoRA는 사실적인 사진을 생성할 수 있었지만, 애니메이션 스타일의 이미지를 생성하기는 어려웠습니다(비록 "anime" 프롬프트를 추가해도). 반면, 애니메이션 학습 데이터를 사용하는 것이 더 나았습니다. 사실적인 스타일을 피하려면 생성 시 "photorealistic" 프롬프트를 추가할 수 있습니다.

(학습 데이터에 "애니메이션 스타일" 태그를 추가했으며, 이 것이 영향을 미쳤을 수도 있나요?)

{

"engine": "kohya",

"unetLR": 1,

"clipSkip": 1,

"loraType": "lora",

"keepTokens": 0,

"networkDim": 2,

"numRepeats": 6,

"resolution": 512,

"lrScheduler": "cosine",

"minSnrGamma": 5,

"noiseOffset": 0.1,

"targetSteps": 1040,

"enableBucket": true,

"networkAlpha": 12,

"optimizerType": "Prodigy",

"textEncoderLR": 0,

"maxTrainEpochs": 20,

"shuffleCaption": false,

"trainBatchSize": 3,

"flipAugmentation": false,

"lrSchedulerNumCycles": 3

}

최종적으로, 저는 에포크 #18 모델을 출판하기로 선택했습니다.

최종적으로, 저는 에포크 #18 모델을 출판하기로 선택했습니다.

V1.0

특별한 감사의 말:

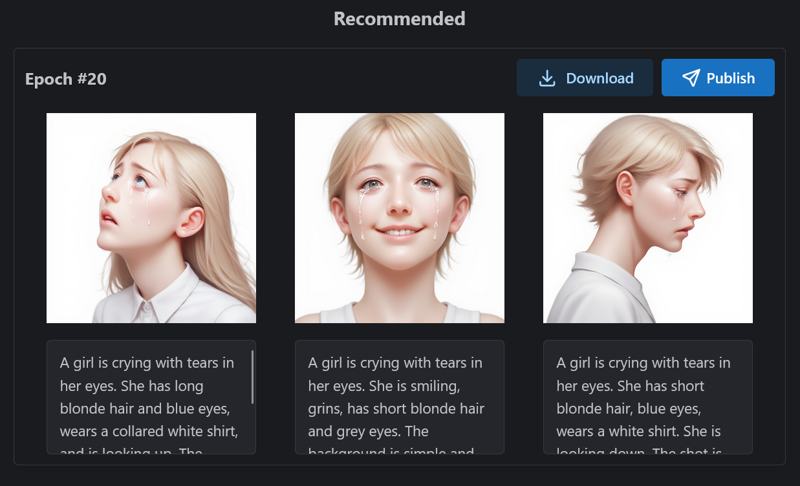

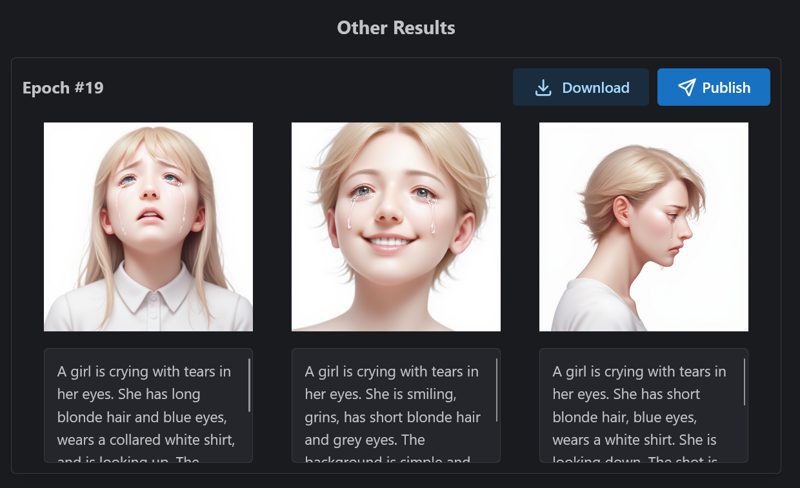

데이터셋은 다운로드 가능합니다(27장의 이미지). 이 이미지들은 위의 두 모델을 통해 생성된 것입니다(1024×1024 크기로 생성한 후, 512×512로 축소). 이후 WebUI의 도구를 사용해 태그를 부여하고, 이러한 자동 생성 태그를 바탕으로 자연어로 수동 재태그했습니다. 마지막으로, 이 LoRA를 사용하면 추가 프롬프트를 통해 포즈를 조정할 수 있습니다(위/아래를 바라보기, 웃는 표정, 입을 다문 상태 등).

학습 파라미터:

{

"engine": "kohya",

"unetLR": 1,

"clipSkip": 1,

"loraType": "lora",

"keepTokens": 0,

"networkDim": 2,

"numRepeats": 6,

"resolution": 512,

"lrScheduler": "cosine",

"minSnrGamma": 5,

"noiseOffset": 0.1,

"targetSteps": 1080,

"enableBucket": true,

"networkAlpha": 12,

"optimizerType": "Prodigy",

"textEncoderLR": 0,

"maxTrainEpochs": 20,

"shuffleCaption": false,

"trainBatchSize": 3,

"flipAugmentation": false,

"lrSchedulerNumCycles": 3

}

최종 에포크가 #19 에포크보다 약간 더 나은 것 같아, 최종 에포크를 선택했습니다.

최종 에포크가 #19 에포크보다 약간 더 나은 것 같아, 최종 에포크를 선택했습니다.