Lighting based picture control controlnet

세부 정보

파일 다운로드

모델 설명

ioclab/control_v1u_sd15_illumination_webui · Hugging Face

지난 일주일 동안 상세 설명을 추가하지 못해 매우 죄송합니다. 작업 시간 문제로 인해 아래에 보완하도록 하겠습니다.

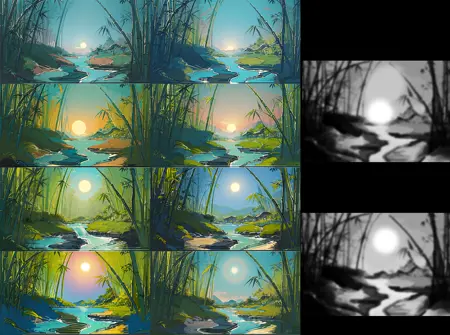

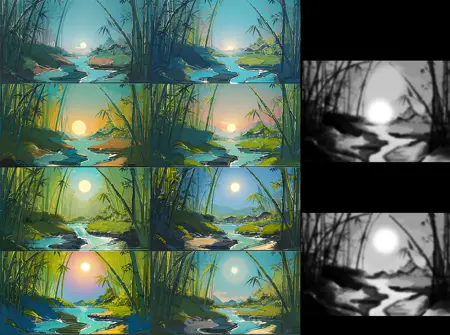

이 ControlNet은 Depth와 유사하지만, 0에서 1 사이의 조명 구성 조절이 가능한 ControlNet입니다.

- 지난 일주일 동안 상세 설명을 추가하지 못해 매우 죄송합니다. 작업 시간 문제로 인해 아래에 보완하도록 하겠습니다.

- 이 ControlNet은 Depth와 유사하지만, 0에서 1 사이의 조명 구성 조절이 가능한 ControlNet입니다.

0-1 단계의 조명 구성 조절 — 텍스트에서 이미지 생성

- 0-1 단계의 조명 구성 조절 — 텍스트에서 이미지 생성

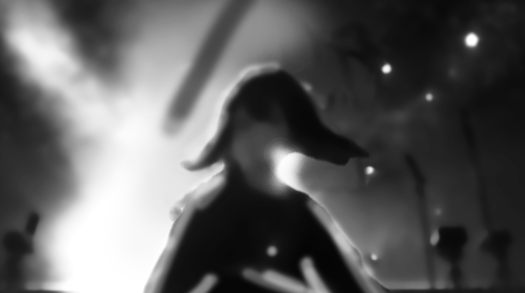

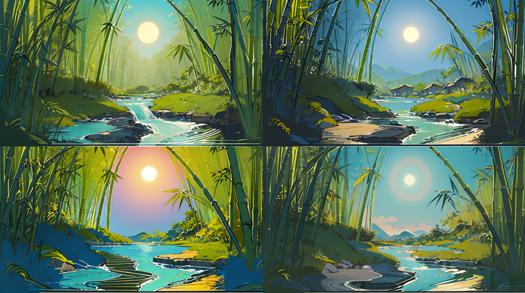

화가이거나 Photoshop과 같은 소프트웨어로 이미지를 이동하거나 조합할 수 있다면, 원하는 구성 이미지를 만들어낼 수 있습니다. 아래 이미지처럼 왼쪽에 조명광선처럼 강조된 시각적 초점을 원하고, 공기 중에 반짝이는 광점이 떠 있는 상태를 표현하면 됩니다.

- 화가이거나 Photoshop과 같은 소프트웨어로 이미지를 이동하거나 조합할 수 있다면, 원하는 구성 이미지를 만들어낼 수 있습니다. 아래 이미지처럼 왼쪽에 조명광선처럼 강조된 시각적 초점을 원하고, 공기 중에 반짝이는 광점이 떠 있는 상태를 표현하면 됩니다.

이 이미지를 ControlNet 입력으로 사용하고, 가중치를 0.6으로 조정하며, 종료 값을 0.65로 설정합니다(후에 설명합니다). 프롬프트 입력에는 "masterpiece, best quality, High contrast, dim environment, bright lights, 1girl, standing in the center of the stage, spotlight hit her, ((floating stars))"를 입력합니다.

이렇게 하면 아래와 같은 결과를 얻을 수 있습니다.

이 그림을 ControlNet 입력으로 사용하고, 가중치를 0.6으로 조정, 종료 값을 0.65로 설정합니다(뒷부분 설명 예정). 프롬프트에 "masterpiece, best quality, High contrast, dim environment, bright lights, 1girl, standing in the center of the stage, spotlight hit her, ((floating stars))"를 입력합니다.

다음과 같은 결과를 얻을 수 있습니다.

전통적인 이미지 생성 방식과 비교해 보면, 이 방식이 조명과 그림자 간 관계를 좀 더 명확하게 조절할 수 있다는 점에서 차이가 있음을 알 수 있습니다. 그럼 이제 수정을 진행해 봅시다.

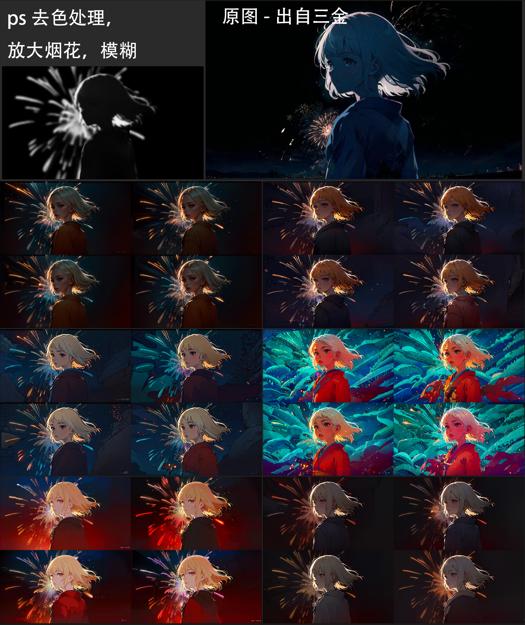

제가 오른쪽 하단의 구성이 마음에 드는데, 여성 캐릭터의 조명 계층을 더 풍부하게 하고 싶습니다. 예를 들어 옷 위에 반사광을 넣고, 비율 조정도 하고 싶네요. Photoshop이나 기타 이미지 편집 소프트웨어를 사용해 색 제거, 가우시안 블러, 추출 작업을 거쳐 아래와 같은 이미지를 얻을 수 있습니다. 또는 원하시면 직접 다시 그려도 됩니다.

전통적인 이미지 생성 방식과 비교해 보면, 이 방식이 조명과 그림자 간 관계를 좀 더 명확하게 조절할 수 있다는 점에서 차이가 있음을 알 수 있습니다. 그럼 이제 수정을 진행해 봅시다.

제가 오른쪽 하단의 구성이 마음에 드는데, 여성 캐릭터의 조명 계층을 더 풍부하게 하고 싶습니다. 예를 들어 옷 위에 반사광을 넣고, 비율 조정도 하고 싶네요. Photoshop이나 기타 이미지 편집 소프트웨어를 사용해 색 제거, 가우시안 블러, 추출 작업을 거쳐 아래와 같은 이미지를 얻을 수 있습니다. 또는 원하시면 직접 다시 그려도 됩니다.

이러한 이미지를 제공할 때는 다소 흐리게 만드는 것이 좋습니다. 그러면 AI가 더 많은 세부사항을 보완할 수 있습니다.

이제 프롬프트와 ControlNet 입력을 조정한 후, 이미지를 출력합니다. 이 과정에서 LoRA, 다른 ControlNet 등을 활용해 이미지 조절력과 통제력을 더 강화할 수 있습니다. 이 ControlNet은 HDR 대비 조절을 유지하도록 훈련되어 있어, 과도한 노출이나 오버다운 현상 없이 이미지 세부사항을 손실 없이 유지합니다. 일반적인 noise offset 등을 통해 대비를 높이는 조명용 LoRA와 함께 사용하면 더욱 효과적입니다. 이 과정에서 과적합 등의 현상이 나타나면, ControlNet의 가중치와 종료 시간을 적절히 낮춰 조정하면 됩니다.

아래와 같은 이미지가 생성됩니다:

이러한 이미지를 제공할 때는 다소 흐리게 만드는 것이 좋습니다. 그러면 AI가 더 많은 세부사항을 보완할 수 있습니다.

이제 프롬프트와 ControlNet 입력을 조정한 후, 이미지를 출력합니다. 이 과정에서 LoRA, 다른 ControlNet 등을 활용해 이미지 조절력과 통제력을 더 강화할 수 있습니다. 이 ControlNet은 HDR 대비 조절을 유지하도록 훈련되어 있어, 과도한 노출이나 오버다운 현상 없이 이미지 세부사항을 손실 없이 유지합니다. 일반적인 noise offset 등을 통해 대비를 높이는 조명용 LoRA와 함께 사용하면 더욱 효과적입니다. 이 과정에서 과적합 등의 현상이 나타나면, ControlNet의 가중치와 종료 시간을 적절히 낮춰 조정하면 됩니다.

아래와 같은 이미지가 생성됩니다.

보시면, "floating star"와 같은 밝은 의미를 가진 단어가 이미지 내 가장 밝은 부분에 잘 나타나 있음을 알 수 있습니다. 이를 이용해 과거에 조절하기 어려웠던 재료—예를 들어 칼빛, 별빛, 물飞 등—을 효과적으로 유도할 수 있습니다. 마지막 예시를 참고해 주세요.

만약 생성한 이미지에서 인물이 예상 위치에 나타나지 않는다면:

보시면, "floating star"와 같은 밝은 의미를 가진 단어가 이미지 내 가장 밝은 부분에 잘 나타나 있음을 알 수 있습니다. 이를 이용해 과거에 조절하기 어려웠던 재료—예를 들어 칼빛, 별빛, 물飞 등—을 효과적으로 유도할 수 있습니다. 마지막 예시를 참고해 주세요.

만약 생성한 이미지에서 인물이 예상 위치에 나타나지 않는다면:

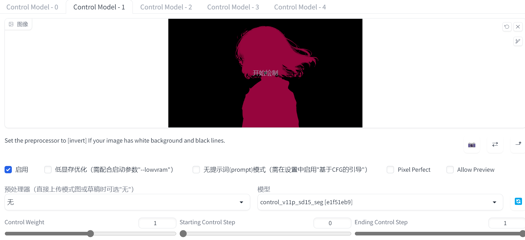

이 경우, 매끄럽게 롤링을 계속할 수도 있고, 구성 요소를 조정할 수도 있습니다. 하지만 우리는 혼자 fighting하지 않습니다! 이것은 하나의 ControlNet이며, 다른 ControlNet들과도 완벽하게 호환됩니다. 과거의 ControlNet에는 이러한 seg가 있었으며(조금 흉측하지만 AI는 이해합니다):

- 이 경우, 매끄럽게 롤링을 계속할 수도 있고, 구성 요소를 조정할 수도 있습니다. 하지만 우리는 혼자 fighting하지 않습니다! 이것은 하나의 ControlNet이며, 다른 ControlNet들과도 완벽하게 호환됩니다. 과거의 ControlNet에는 이러한 seg가 있었으며(조금 흉측하지만 AI는 이해합니다):

두 번째 ControlNet을 활성화하면 인물이 예상 위치에 올바르게 나타남을 확인할 수 있습니다. 이 논리를 다른 ControlNet과도 결합해 사용할 수 있습니다.

- 두 번째 ControlNet을 활성화하면 인물이 예상 위치에 올바르게 나타나 있음을 알 수 있습니다. 이 논리를 다른 ControlNet과도 결합해 사용할 수 있습니다.

이제 tile 또는 img2img를 사용해 고화질 처리하거나, 해상도를 높여 hires 기능을 사용하거나, 시드 값을 변경하여 AI가 t2i에서 생성하는 다른 결과를 살펴볼 수 있습니다. 그러나 보존된 별, 왼쪽 초점, 빛을 받은 머리카락과 목 등은 그대로 유지됩니다.

- 이제 tile 또는 img2img를 사용해 고화질 처리하거나, 해상도를 높여 hires 기능을 사용하거나, 시드 값을 변경하여 AI가 t2i에서 생성하는 다른 결과를 살펴볼 수 있습니다. 그러나 보존된 별, 왼쪽 초점, 빛을 받은 머리카락과 목 등은 그대로 유지됩니다.

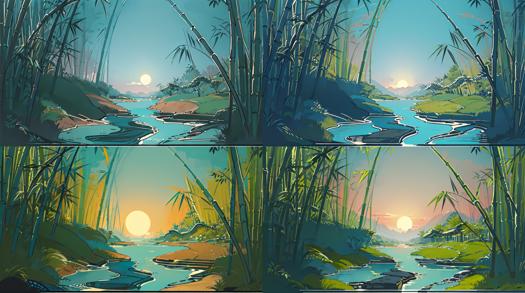

다른 ckpt를 시도해 보세요. 이런 관계는 유지될까요?

그 결론은 예입니다!

다른 ckpt를 시도해 보세요. 이런 관계는 유지될까요?

그 결론은 예입니다!

이 ControlNet을 통해 AI는 생성 시 어디가 그림자이고 어디가 밝은 부분인지 인식할 수 있습니다.

- 이 ControlNet을 통해 AI는 생성 시 어디가 그림자이고 어디가 밝은 부분인지 인식할 수 있습니다.

1-1.5 단계의 조명 조정

- 1-1.5 단계의 조명 조정

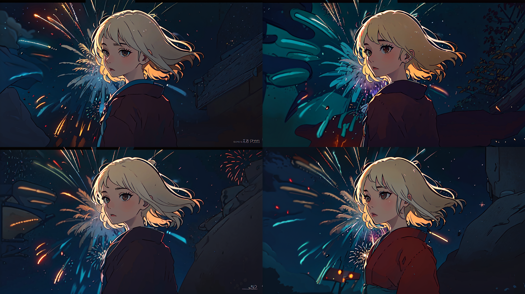

이 예시 이미지에서는 머리카락의 가장자리 빛과 뒤쪽의 화약류가 매우 마음에 드는데, 제 ckpt에서 이와 같은 구성 재현을 시도하고 싶습니다. 하지만 알고 있듯이, SD가 다시 롤링하면 보존하고 싶었던 구성이 사라질 수 있습니다. 따라서 Photoshop으로 화약류를 제거하고 아래와 같은 입력 이미지를 만들어낼 수 있습니다.

- 이 예시 이미지에서는 머리카락의 가장자리 빛과 뒤쪽의 화약류가 매우 마음에 드는데, 제 ckpt에서 이와 같은 구성 재현을 시도하고 싶습니다. 하지만 알고 있듯이, SD가 다시 롤링하면 보존하고 싶었던 구성이 사라질 수 있습니다. 따라서 Photoshop으로 화약류를 제거하고 아래와 같은 입력 이미지를 만들어낼 수 있습니다.

또한 원본 이미지가 있기 때문에, 아래와 같은 seg를 만들었습니다.

- 또한 원본 이미지가 있기 때문에, 아래와 같은 seg를 만들었습니다.

- 아래의 결과를 직접 체험해 보세요!

네, 동일한 구성, 동일한 머리카락 가장자리 빛이지만 더 큰 화약류가 나타났습니다! ControlNet과 SD의 프롬프트 이해를 통해 화약류는 예상된 위치에 밝은 요소로 표현되었습니다.

기존 모델을 바꿔 보시고, 더 다양한 효과를 확인하시면 됩니다. 여기서 기존에 보존하고 싶었던 요소들은 모두 유지됩니다:

네, 동일한 구성, 동일한 머리카락 가장자리 빛이지만 더 큰 화약류가 나타났습니다! ControlNet과 SD의 프롬프트 이해를 통해 화약류는 예상된 위치에 밝은 요소로 표현되었습니다.

기존 모델을 바꿔 보시고, 더 다양한 효과를 확인하시면 됩니다. 여기서 기존에 보존하고 싶었던 요소들은 모두 유지됩니다:

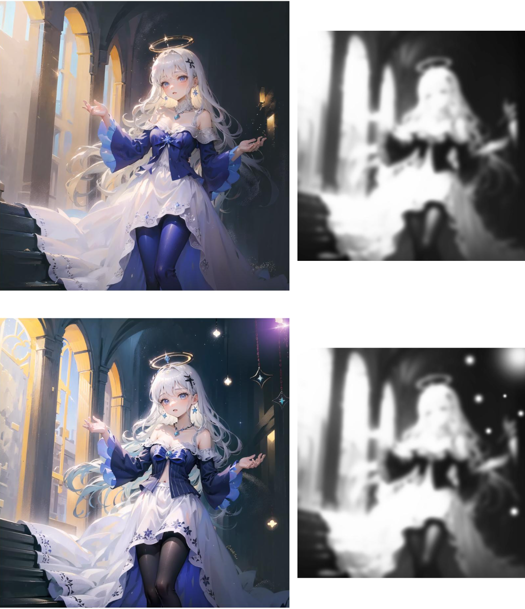

마찬가지로, 이미지에 새로운 광원과 부유 요소를 추가할 수 있습니다.

- 마찬가지로, 이미지에 새로운 광원과 부유 요소를 추가할 수 있습니다.

칼날에 금속 반사를 넣고, 주변에 물飛나 칼빛이 나타나도록 유도할 수도 있고, 뒤에 조명을 추가할 수도 있습니다. 너무 사실적으로 그릴 필요는 없습니다. 의도만 전달하면 됩니다.

- 칼날에 금속 반사를 넣고, 주변에 물飛나 칼빛이 나타나도록 유도할 수도 있고, 뒤에 조명을 추가할 수도 있습니다. 너무 사실적으로 그릴 필요는 없습니다. 의도만 전달하면 됩니다.

다른 장면에서도 이 ControlNet은 의미를 유지할 수 있으며, 다음과 같은 이미지를 만들 수 있습니다:

- 다른 장면에서도 이 ControlNet은 의미를 유지할 수 있으며, 다음과 같은 이미지를 만들 수 있습니다:

사용 방법:

- 사용 방법:

ControlNet을 다운로드하여 다른 ControlNet 모델과 동일한 모델 폴더에 넣기만 하면 됩니다. 모델 목록을 새로 고치면 됩니다. 현재는 통합 전처리기가 준비되지 않았으며, 제안 있으시면 댓글 남겨 주세요.

- ControlNet을 다운로드하여 다른 ControlNet 모델과 동일한 모델 폴더에 넣기만 하면 됩니다. 모델 목록을 새로 고치면 됩니다. 현재는 통합 전처리기가 준비되지 않았으며, 제안 있으시면 댓글 남겨 주세요.

QA:

img2img 역시 비슷한 효과를 낼 수 있을 것 같은데, 차이는 무엇인가요?

네, 과거에는 img2img나 다른 방법으로 조명을 조절하는 사례가 있었습니다. 하지만 그 조작은 종종 여러 번의 롤링이나 세밀한 처리를 필요로 했습니다. ControlNet을 사용하면 t2i 단계에서 훨씬 더 많은 통제와 가능성, 그리고 0부터 시작한 구상의 구현이나 스크린 레이아웃 구성을 더 잘 도울 수 있습니다.

img2img 역시 비슷한 효과를 날 수 있을 것 같지만, 차이점이 무엇인가요?

네, 과거에는 img2img 또는 다른 방식으로 조명을 조절하는 사례가 있었습니다. 하지만 그 조작은 종종 여러 번의 롤링이나 세밀한 처리를 필요로 했습니다. ControlNet을 사용하면 t2i 단계에서 훨씬 더 많은 통제와 가능성, 그리고 0부터 시작한 구상의 구현이나 스크린 레이아웃 구성을 더 잘 도울 수 있습니다.

왜 제 이미지에서 문제가 발생하고, 과적합처럼 보이나요?

이 ControlNet은 대량의 실세계 데이터셋을 기반으로 훈련되어, 현실의 조명과 이미지 간 관계를 학습했습니다. 따라서 만화처럼 구체적인 장면에서 사용할 경우, 가중치와 종료 시점을 낮춰야 합니다. 가중치 0.6, 종료 시간 0.6으로 시도해 보세요. 다음 버전에서 개선이 예정되어 있으며, 여러분의 피드백이 훈련 방식을 조정하는 데 도움이 됩니다.

왜 제 이미지에서 문제가 발생하고, 과적합처럼 보이나요?

이 ControlNet은 대량의 실세계 데이터셋을 기반으로 훈련되어, 현실의 조명과 이미지 간 관계를 학습했습니다. 따라서 만화처럼 구체적인 장면에서 사용할 경우, 가중치와 종료 시점을 낮춰야 합니다. 가중치 0.6, 종료 시간 0.6으로 시도해 보세요. 다음 버전에서 개선이 예정되어 있으며, 여러분의 피드백이 훈련 방식을 조정하는 데 도움이 됩니다.

다른 예시나 토론이 있나요?

저도 ControlNet을 훈련하고 싶은데, 어떻게 시작하면 되나요?