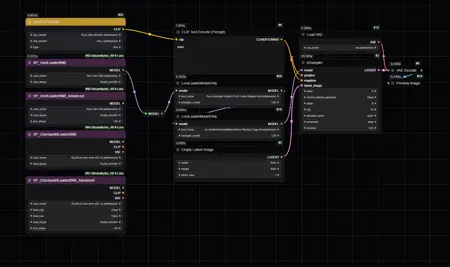

NF4+LoRA, FP8 to NF4 + LoRA For ComfyUI (Workflow) - For 8GB VRAM and less

詳細

ファイルをダウンロード

モデル説明

カスタムノード用 - https://github.com/bananasss00/ComfyUI_bitsandbytes_NF4-Lora

直接リンク: https://github.com/bananasss00/ComfyUI_bitsandbytes_NF4-Lora/archive/refs/heads/master.zip

ノードの主な機能

リアルタイム変換: ノードはFP8モデルをNF4形式にリアルタイムで変換します。LoRAを使用しても生成速度は低下しません。

モデル読み込みの最適化: ユーザーがモデルのデータ型(load_dtype)を指定できるようにすることで、不要な再変換を避け、モデル読み込み時間を短縮しました。

生成後のモデルアンロードの修正: 生成後にモデルを適切に部分的にアンロードするよう修正し、以前のメモリ管理に影響を与えていた問題を解決しました。

このワークフローが気に入ったら、サポートをお願いします:Buzz / いいね / 投稿やレビュー追加 / フォロー - ありがとうございます!

2つのLoRA:HyperFlux+realism_loraを8ステップで使用した際のNF4-FP8-GGUF_Q4_0の生成比較:

https://imgsli.com/MzA0Nzgz https://imgsli.com/MzA0Nzg0 https://imgsli.com/MzA0Nzg2 https://imgsli.com/MzA0Nzg3

最高品質を得るためのヒント

FP8モデルを使用してください: NF4モデルもサポートされていますが、LoRAの適用品質はFP8モデルを使用した場合ははるかに高くなります。

NF4モデルでのLoRA重みを調整してください: NF4モデルを入力として使用する場合、LoRAの効果が明らかでない場合があるため、LoRA重みを増加させる必要があります。また、高度なノードセクションで、rounding_formatパラメータをプリセットの**2,1,7**に設定してみてください。ただし、これらの設定を使用するとアーティファクトが発生する可能性があることに注意してください。カスタム値を試すことでより良い結果が得られるかもしれません。NF4モデルへのLoRA適用の効果的な方法は、私はまだ確立していません。

このノードは、ComfyUIから改変された丸め関数を使用しています。詳細は以下をご覧ください:https://github.com/comfyanonymous/ComfyUI/blob/203942c8b29dfbf59a7976dcee29e8ab44a1b32d/comfy/float.py#L14

プリセットを2, 1, 7またはカスタムに設定すると、この3つの値は関数内のEXPONENT_BITS、MANTISSA_BITS、EXPONENT_BIASを決定し、浮動小数点演算の精度を制御します。

GitHubリポジトリでプロジェクトをご覧になり、貢献してください。

https://github.com/bananasss00/ComfyUI_bitsandbytes_NF4-Lora