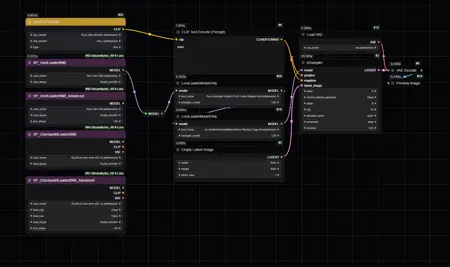

NF4+LoRA, FP8 to NF4 + LoRA For ComfyUI (Workflow) - For 8GB VRAM and less

详情

下载文件

模型描述

针对 custom_nodes - https://github.com/bananasss00/ComfyUI_bitsandbytes_NF4-Lora

直接下载链接:https://github.com/bananasss00/ComfyUI_bitsandbytes_NF4-Lora/archive/refs/heads/master.zip

节点主要功能

实时转换:该节点支持将 FP8 模型实时转换为 NF4 格式,使用 LoRA 时生成速度不会降低。

模型加载优化:通过允许用户指定模型的数据类型(load_dtype),避免不必要的重复转换,从而提升模型加载速度。

生成后模型卸载修复:确保生成后模型能正确部分卸载,解决了此前可能影响内存管理的问题。

如果您喜欢这个工作流,请支持一下:点赞 / 点赞 / 发帖或评论 / 关注 —— 谢谢!

使用两个 LoRA:HyperFlux + realism_lora,在 8 步内生成的 NF4-FP8-GGUF_Q4_0 效果对比:

https://imgsli.com/MzA0Nzgz https://imgsli.com/MzA0Nzg0 https://imgsli.com/MzA0Nzg2 https://imgsli.com/MzA0Nzg3

最佳质量建议

使用 FP8 模型:虽然支持 NF4 模型,但若使用 FP8 模型,LoRA 的效果质量将显著更高。

调整 NF4 模型的 LoRA 权重:当使用 NF4 模型作为输入时,可能需要提高 LoRA 权重,否则 LoRA 效果可能不明显。同时,在高级节点部分,尝试将 rounding_format 参数设为预设值 2,1,7。请注意,使用这些设置可能会导致伪影——尝试自定义数值可能获得更佳效果。目前我尚不清楚如何有效将 LoRA 应用于 NF4 模型。

该节点使用了来自 ComfyUI 的修改版四舍五入函数,详见:https://github.com/comfyanonymous/ComfyUI/blob/203942c8b29dfbf59a7976dcee29e8ab44a1b32d/comfy/float.py#L14

当预设值设为 2, 1, 7 或 自定义 时,这三个数值分别确定函数内的 EXPONENT_BITS、MANTISSA_BITS 和 EXPONENT_BIAS,用于控制浮点运算的精度。

欢迎访问 GitHub 仓库查看项目并贡献代码。

https://github.com/bananasss00/ComfyUI_bitsandbytes_NF4-Lora