EML_LTX_TTV/ITV_v1.0

詳細

ファイルをダウンロード

このバージョンについて

モデル説明

ダウンロード:

ダウンロード:

## ワークフローガイド:説明

----------------------------

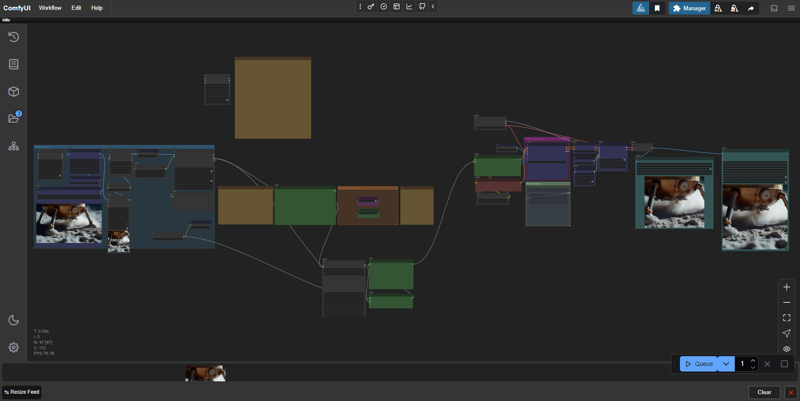

この「EML_LTX_TTV/ITV」と呼ばれる制作プロセスは、LightricksのLTX-Videoに基づいた高品質な動画を実現するための先進的なテクニックを備えています。

✅ 8GB VRAMのグラフィックカードで動作します

✅ 1つのスイッチで「テキスト→動画」と「画像→動画」の2つの動作モードを切り替え可能

✅ 生成された画像のサポート:ユーザーはしばしば「凍結した動画」、つまり画像のノイズ不足の問題に直面します。この制作プロセスは、crfを介して自動的にノイズを追加し、ニューラルネットワークに「全体像」の理解を与えます

✅ Florence2モデルによる画像認識

✅ 1文で複雑なプロンプトを生成

✅ WebPおよびMP4への保存

✅ 方面比の一覧が便利。16:9のヒントを追加

デフォルトでは、モデルの解像度は768x512、アスペクト比は3:2です。カスタム解像度を使用する場合は自己責任で、ノードヘルパー「LTXV Model Configurator」の公式リストから選択することをお勧めします。

これはWorkflow XODA-LTXV /model/974859 をベースとしています

❤❤❤ワークフローを提供していただき、ありがとう❤❤❤

## ワークフローガイド:準備

----------------------------

0. ワークスペースを起動した後、必要なノードが欠けている可能性があります。Manager → Install Missing Custom Nodes → すべて選択(IDの横)→ インストール

インストール後、Comfy UI が再起動を要求するので、クリックして次のステップに進んでください。

0.1 モデルの選択

私は、Mochiのltx-2b-v0.9-bf16.safetensorsモデルとt5xxl_fp16.safetensorsを組み合わせて使用しています

https://huggingface.co/MayensGuds/ltx-video-quants

6GB VRAM以下のグラフィックカードをお使いの場合は、ltx-video-2b-v0.9-fp8_e4m3fn.safetensorsモデルとclip loaderのt5xxl_fp8_e4m3fn.safetensorsをお試しください

「ltxv」モードが有効になっていることを確認してください

💡ヒント:Flux1を使用して画像を生成すると、類似のテキスト変換アルゴリズムを使用しているため効果的です。

0.2 最適化のヒント

私のNVIDIA RTX 2060s 8GB VRAMグラフィックカードでは、デフォルト設定(768x512、25fps、97フレーム、30ステップ)で約10秒/イテレーション、つまり約5分/動画の速度で処理されます。左側の「🅛🅣🅧 LTXV Model Configurator」モジュールを使用して推奨値を導き出すことができます。このモジュールは、空間の他のすべてのクローンと同様に、何とも接続されておらず、参照用として使用されます。

処理速度を上げるには、解像度を変更するよりもフレーム数を減らす方が効果的ですが、その場合映像の長さは短くなります。通常、私は約50フレームで十分で、25fpsでは2秒の動画になります。また、20ステップに設定することをお勧めします。なぜなら、私の見解では画質に大きな差はありません。結果として、速度と品質のバランスが良く、最適化後は約5秒/イテレーション、動画全体の所要時間は約1分30秒になります。後処理(例:スローモーション)のために、2秒の動画があれば十分なショットが得られます。Llamaは大量のVRAMを消費しますが、より効率的な消費方法が開発中です。

0.3 Llamaのインストール

0.3.1 https://ollama.com/download からLlamaをダウンロードしてインストールしてください。

0.3.2 CMDまたはPowerShellを開き、次のコマンドを貼り付けます:ollama run llama3.2

※コピーはCtrl + C、CMDへの貼り付けはマウスの右クリックで行います。これにより、Llamaは自動的にコンピュータにインストールされ、トレイで実行されます。次のバージョンでは、この方法はggufモデルに置き換えられます。

## ワークフローガイド:動画生成

----------------------------

1. 画像をアップロード(画像を読み込む > アップロードするファイルを選択)

*ワークフローは自動的に画像に最適な説明文を選択します。

2. ディレクターとしてプロンプトを指定:

-- 説明:「画像/テキスト→動画」モード選択セクションで、画像→動画とテキスト→動画の切り替えが可能です。画像で作業するか、テキストで作業するかを選択してください。画像を動画に変換したい場合は、すべての設定が左側の「Image Interpret」グループにあります。テキストのみで作業したい場合は、すべての設定が右側の「Text To Video」グループにあります。

fps、ステップ、cfgなどの追加設定は、このワークフローの最も右側にありますが、デフォルト設定でも問題ありません。--

2.(1). LLM Llama 3.2 は、あなたのプロンプトに基づいてヒントを生成します。動き、光の演出、すべての動的な要素について、すべてを記述する必要があります。Florence2は静的なプロンプトを担当します。

2.(2). マニュアルモード(開発中):次回のバージョンで追加されます。現在、ワークフローはLLM入力のみをサポートしていますが、自分でマニュアルモードに切り替えることができます:

- 簡潔に、明確に書いてください。むしろストレートに。

- 画面上で何が起こるかを記述:誰かが歩く、回転する、次のシーンの展開を示す。

- シーンのジャンルとトーン(現実的、映画的、漫画的)を強調。

- シーンが特定のメディア形式(映画、アニメ、写真)から着想を得ているかを明記。

- カメラは静止したままか、キャラクターの前方、後方、周囲、または特定の第一人称視点で動くのか。

例:

濃紺の制服と同色の帽子を着た2人の警察官が、フレーム左側のドアから、薄暗い部屋に入ってきます。最初の警察官は短い茶色の髪と口ひげを持ち、次に、頭を剃ってあごひげのある相棒が続きます。両者は真剣な表情で、部屋の奥へ確実な歩調で進んでいきます。カメラは固定されたまま、彼らが入ってくる様子をやや低いアングルで捉えます。部屋の壁は露出したレンガ造りで、天井は波形金属板、背景には鉄格子の窓が見えます。照明は低調で、警察官の顔に影を落とし、憂鬱な雰囲気を強調しています。このシーンは映画やテレビ番組から着想を得ているように見えます。

💡ヒント:英語が母語でない場合、GoogleストアのDeepL AIブラウザ拡張機能を使用してテキストを翻訳できます。テキストを選択し、Ctrl + Shift + Xを押して、事前に翻訳言語を選んでください。

公式の手順:

主なアクションを1文で始める

動きやジェスチャーの具体的な詳細を追加

キャラクター/オブジェクトの外観を正確に記述

背景や環境の詳細を含める

カメラの角度と動きを指定

照明と色を記述

変化や突発的な出来事を注記

プロンプト作成ウィンドウの横に、より詳細な手順が記載されています。

3. すべてのカスタマイズは青くマークされたグループ内で行います。それ以外の部分は触れないでください。同様に、「LTXVScheduler」ノードも、ステップパラメータ(デフォルト30)以外は変更しないほうが良いです。

3.1 CFGも調整可能です。デフォルトは3.0、公式推奨は3.0–3.5ですが、多くのユーザーは5を使用しています。私の観察では、このパラメータはより動的な結果やコントラストの強い画像に必要ですが、PixArt-XL-2-1024-MSモデルのテキストエンコーダーでは、YouTube上の動画から判断すると、より安定した結果をもたらし、より多くのメモリを必要とします。したがって、弱いグラフィックカードでは3.0–3.5の低負荷値を使用してください。ただし、これがどのように影響を与えるかは、まだ完全に理解できていません。

4. 「Queue」をクリックし、結果を待ってください。ファイルはComfyUI\outputフォルダに保存されます。出力は動画:.webp、.mp4、および一時画像:.pngです。必要なければ削除してください。

💡ヒント:私のWebPコンバーターを使用すると、.mp4をプロセスから除外し、プロンプトと設定を失うことなく、より速く.WebP形式で動画を保存できます。

▶️ https://github.com/dvl12000/webp-converter/releases/tag/v1.0.1

💡ヒント:処理後、Topaz Video AIの「Theia」モードで画像を×2または×4倍にズームインし、シャープネスを約50に設定し、デフォルトでグレインを適用してください。これにより大幅な品質向上が実現できます!

⚠現在、このワークフローはやや多くのビデオメモリを必要とし、手動ワークフローの品質には及んでいませんが、次のバージョンではプロンプトエンジニアリングの手順が改善されます。現在はアーカイブ内の手動ワークフローファイルを使用することをお勧めします。こちらはより安定しており、少ないビデオメモリで動作します。

----------------------------

このビルドに評価をつけて、コメントをお寄せください!楽しい生成を! 🔥