EML_LTX_TTV/ITV_v1.0

详情

下载文件

关于此版本

模型描述

下载:

下载:

## 工作流指南:描述

----------------------------

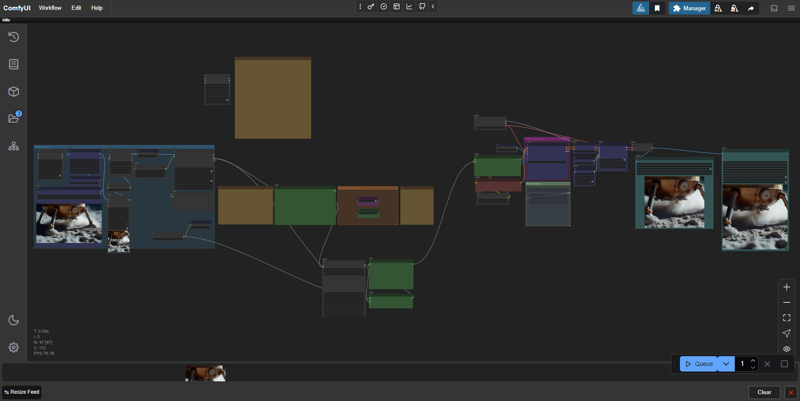

此生产流程称为“EML_LTX_TTV/ITV”,采用高级技术基于Lightricks的LTX-Video实现高质量视频。

✅ 适用于8GB显存的显卡

✅ 两种操作模式:文本转视频和图像转视频,只需一键切换。

✅ 支持生成图像:用户常遇到“静止视频”问题,即图像缺乏噪声。此流程通过crf自动添加噪声,使神经网络理解“全局画面”。

✅ 使用Florence2模型进行图像识别

✅ 基于一句话生成复杂提示

✅ 支持保存为WebP和MP4格式

✅ 方便的宽高比列表。新增16:9提示

默认模型分辨率为768x512,宽高比为3:2。请自行承担使用自定义分辨率的风险,建议从节点助手“LTXV Model Configurator”中的官方列表中选择。

基于Workflow XODA-LTXV /model/974859

❤❤❤感谢提供工作流!❤❤❤

## 工作流指南:准备

----------------------------

0. 启动工作区后,您很可能缺少所需的节点。前往 Manager -> 安装缺失的自定义节点 -> 全选(ID旁)-> 安装

安装完成后,Comfy UI会提示重启,请点击并继续下一步。

0.1 模型选择。

我偏好使用LTX-2b-v0.9-bf16.safetensors模型,搭配来自Mochi的t5xxl_fp16.safetensors:

https://huggingface.co/MayensGuds/ltx-video-quants

若您的显卡为6GB显存或更低,请尝试使用ltx-video-2b-v0.9-fp8_e4m3fn.safetensors模型,搭配clip loader:t5xxl_fp8_e4m3fn.safetensors

请确保已激活“ltxv”模式

💡提示:使用Flux1生成图像,因其采用相似的文本转换算法。

0.2 优化建议。

在我的NVIDIA RTX 2060s 8GB显存显卡上,默认设置为768x512、25fps、97帧、30步,生成速度约为10秒/帧,即每段视频约5分钟。左侧的“🅛🅣🅧 LTXV Model Configurator”模块可帮助您获得推荐参数。该模块与其所有空间克隆体一样,未连接任何内容,仅作为参考。

为加快速度,建议减少帧数而非改变分辨率,但视频时长会相应缩短。通常我使用约50帧(25fps = 2秒视频)已足够。建议设置20步,因为在我看来质量并无明显差异。最终获得速度/质量的良好平衡,优化后约为5秒/帧,速度提升一倍,总耗时约1分30秒。如需后续慢动作处理,两秒视频已足够制作优质镜头。Llama占用大量显存,更高效内存使用方案正在开发中。

0.3 安装Llama。

0.3.1 从 https://ollama.com/download 下载并安装Llama。

0.3.2 打开CMD或PowerShell,粘贴以下命令:ollama run llama3.2

ps:复制请按Ctrl + C,在CMD中粘贴请用鼠标右键。之后Llama将自动安装并后台运行。下一版本将采用gguf模型取代此方法。

## 工作流指南:视频生成

----------------------------

1. 上传图像(加载图像 > 选择要上传的文件)

* 工作流会自动为图像选择合适的描述。

2. 作为导演指定提示:

-- 描述:您可在“图像/文本转视频”模式选择部分切换图像转视频与文本转视频。选择您希望处理图像还是文本。若要将图像转为视频,所有设置位于左侧“图像解释”组;若仅处理文本,所有设置位于右侧“文本转视频”组。

帧率、步数、CFG等额外设置位于本工作流最右侧,但默认值已表现良好。--

2.(1). LLM Llama 3.2 根据您的提示生成动态提示,您需明确描述所有与运动、光影变化及动态元素相关的内容,Florence2负责静态提示。

2.(2). 手动模式(开发中)将在后续版本中添加。目前工作流仅支持LLM输入,但您可自行切换至手动模式:

- 请简洁清晰地描述,甚至可以说直白一点。

- 描述画面中将发生什么:有人行走、转身、下一步场景将走向何处。

- 强调场景的类型与基调(写实、电影感、卡通化)。

注明场景是否受特定媒介形式启发(电影、动画、摄影)。

- 摄像机是静止不动,还是向前推进、跟随角色、环绕角色,或采用某种特殊的第一人称视角。

示例:

两名身穿深蓝色制服和匹配帽子的警察,从画面左侧门道进入一间昏暗房间。第一位警察短发棕发、留有胡须,率先步入;其搭档光头、留有山羊胡紧随其后。两人表情严肃,步伐稳健地深入房间。摄像机保持静止,以略低的角度捕捉他们进门的全过程。房间墙壁为裸露砖块,天花板为波纹金属,背景可见铁栅栏窗户。照明为低照度,投下阴影于警员面部,凸显阴郁氛围。画面风格似电影或电视剧。

💡提示:非英语使用者可使用Google商店中的DeepL AI浏览器插件翻译文本。选中文本后按Ctrl + Shift + X,事先选择目标语言。

官方指南:

以单句开头描述主要动作

添加关于运动与手势的具体细节

精确描述角色/物体外观

包含背景与环境细节

指定镜头角度与移动方式

描述光照与色彩

注明任何变化或突发事件

更多详细说明请参见提示生成窗口旁的指引。

3. 所有自定义设置均在蓝色标记的组中进行。不建议修改其余部分。同样,节点“LTXVScheduler”中也建议仅修改步数参数(默认30),其余勿动。

3.1 您也可调整CFG参数。默认值为3.0,官方推荐值为3.0–3.5,但许多用户使用5。根据我的观察,此参数有助于获得更动态或对比更强的画面,但在PixArt-XL-2-1024-MS模型的文本编码器上,使用3.0–3.5能产生更稳定结果(YouTube视频可佐证),且更节省显存。因此,对于显存较弱的显卡,建议使用3.0–3.5。不过我仍未完全理解其影响机制。

4. 点击“Queue”并等待结果。文件将保存在ComfyUI\output文件夹中,输出为视频:.webp .mp4 及临时图像 .png,您可以删除临时文件。

💡提示:您可以使用我的WebP转换器,跳过.mp4生成链,直接以更快的速度保存为.WebP格式,且不丢失提示与设置。

▶️ https://github.com/dvl12000/webp-converter/releases/tag/v1.0.1

💡提示:处理完成后,可在Topaz Video AI中以“Theia”模式放大2倍或4倍,默认添加锐化约50%与颗粒效果,可显著提升画质!

⚠ 目前工作流对显存需求较高,质量略逊于手动工作流,但后续版本将改进提示工程说明。当前推荐使用存档中的手动工作流文件,其更稳定且显存需求更低。

----------------------------

为本版本评分,留下评论,祝生成愉快!🔥