Controlnet for DensePose

详情

下载文件

模型描述

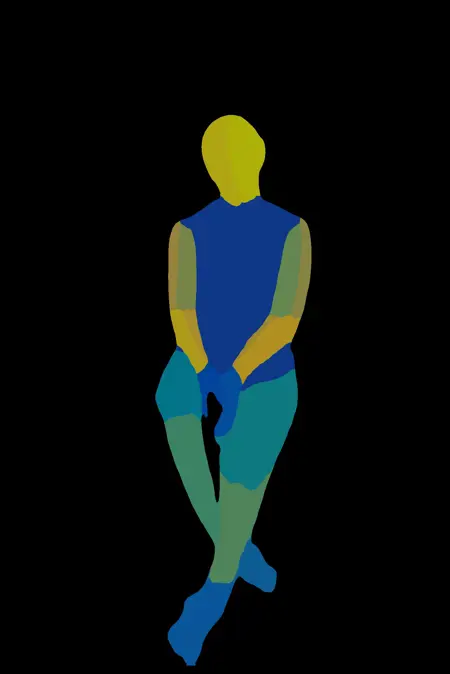

该ControlNet模型接受DensePose标注作为输入

使用方法

将 .safetensors 文件放置于 ../stable diffusion/models/ControlNet/ 目录下。

关于DensePose

本仓库解释了什么是DensePose以及如何使用它:https://github.com/facebookresearch/detectron2/tree/main/projects/DensePose

要使用标注器,您需按说明安装 Detectron2。DensePose标注器依赖 apply_net.py 运行。请参阅帖子中的最后一张图,了解对该脚本的必要修改。

将此项目转换为预处理器对我来说过于困难了。

模型特性

优势

身体姿态稳定

手部推理表现良好

能够推理复杂姿态

与Depth ControlNet结合潜力巨大

劣势

与OpenPose类似,深度信息严重依赖推理和Depth ControlNet

头部方向不稳定

难以准确推理多人(更精确地说,是多人头部)

可能遇到的问题

Q:该模型倾向于推断出多人

A:避免在标注中留出过多空白区域。或与Depth ControlNet配合使用。或如我一样编写提示词(例如:(one:1.2) girl)。

Q:该模型表现不佳

A:

DensePose标注器效果不好。您可以手动修改标注,这比修改OpenPose标注更容易。

Depth标注器效果不佳。实际上,我建议使用

glpn-nyu作为深度标注器。请参阅:https://huggingface.co/vinvino02/glpn-nyu姿态过于复杂,超出了模型的能力范围。

Q:该模型与我的LoRA配合效果不佳

A:

这可能意味着您的LoRA训练数据不足。事实上,经过充足数据训练的LoRA与ControlNet或提示词冲突更少。

将您的LoRA的IN模块权重设为0。所有冲突通常都源于IN模块。请参考:https://github.com/hako-mikan/sd-webui-lora-block-weight

*注意:帖子中的第二个姿势生成使用了Depth ControlNet(权重=0.25)