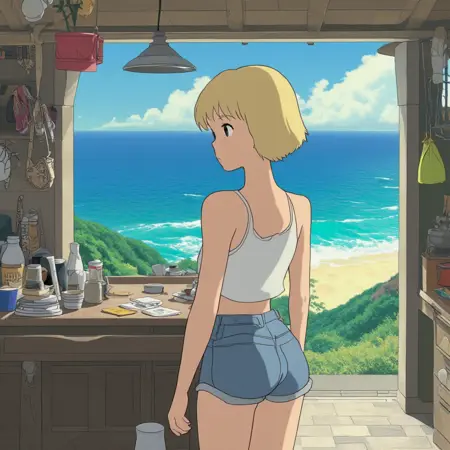

Studio Ghibli 🎨 Lumina-Image 2.0

詳細

ファイルをダウンロード

モデル説明

説明

元のLumina 2はジブリスタイルを理解できません。私がプロンプトを入力すると、奇妙な解剖学的歪みを持つ素晴らしい画像が生成されますが、それはジブリではありません。

私はジブリのアートスタイルが大好きで、新しいモデルにはすべてこのスタイルを教える努力をしてきました。これはLumina Image 2での初期の試みの結果です。もっと良くなる可能性もありますが、逆に悪くなる可能性もありました 🤷

使用方法

ギャラリーの各画像には組み込まれたワークフローが含まれているため、ComfyUIにそのままドロップしてください。

ほとんどのパラメータはデフォルトワークフローと同じですが、以下の点が異なります:

Steps: 40

Scheduler: sgm_uniform

(注:これらが必ずしも最適な設定というわけではありません。単にLoRA出力をこれらの設定でテストしただけです。)

他のサンプラーについてはまだ十分にテストしていませんが、他のユーザーはgradient_estimationサンプラーが多少改善する可能性があると述べており、CFGを下げることで解剖学的正しさの確率が上がる可能性があるとのことです。

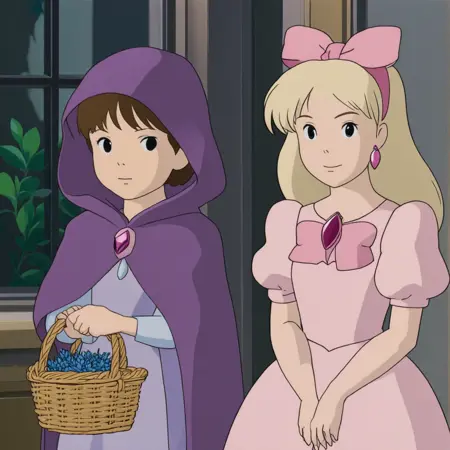

学習

私はジブリ映画のスクリーンショットの断片、合計184枚(1024x1024)を使用しました。

これらにはJoyCaption Alpha Two(ローカル環境)で「descriptive/long」モードを使用してキャプションを付与し、各キャプションの先頭に「You are an assistant designed to generate high-quality images based on user prompts.

(LLMのプレフィックスは必要ないと思いますが、念のため追加しました。)

学習にはai-toolkitを使用しました。これは最近、Lumina-2学習用ブランチをメインリポジトリにマージしました。ちなみに、Lumina-2の学習(LoRAおよび完全ファインチューニング)を現在サポートしている別のトレーナーとして、diffusion-pipeもあります。それも試しましたが、私の環境ではai-toolkitよりも遅かったです。

最初はデフォルト設定を使いましたが、デフォルトの学習率(1e-04)は高すぎると判断しました。さまざまな最適化手法を試しましたが、2000–3000ステップ後にはLoRAの結果が良くなかったです。その後、5e-05に変更したところ、結果が改善しました。20000ステップまで学習することに決めました。学習は非常に速く感じられました(RTX 3090で約1.7秒/ステップ)。おそらく、過去2か月間HunyuanVideoだけを学習していたからでしょう 😆 学習終了後、TensorBoardのログに基づき、訓練中のサンプル品質が良かったまたは損失が最低だったチェックポイントを選択しました。その後、ComfyUIで手動でテストし、17200ステップのチェックポイントを選択しました。

(私は、良いLoRAを得るための総ステップ数を劇的に減らせるはずだと断言できます。これはあくまで最初の試みであり、さらにLumina-2をどれだけ長く学習できるかをテストしたかったのです。)

まとめると、私は以下のパラメータを使用しました:

lr: 5e-5

optimizer: "adamw8bit"

optimizer_params.betas: [0.95, 0.98]

optimizer_params.weight_decay: 0.01

noise_offset: 0.1

lr_scheduler: "cosine"

他のハイパーパラメータはすべてデフォルトのままにしました。データセットと設定ファイルはこのLoRAと一緒に添付されています。

(私はrankを16にしたままにしたのは間違いだったと思っています。Lumina-2のLoRAはスタイルの細部を十分に捉えるために少なくともrank 32以上が必要です。でも、私はまだ学習中です。)

互換性

1点注意:ai-toolkitはLoRAのsafetensorsファイルを、ComfyUIと互換性のない形式で保存します。これを解決するために、訓練データにも含まれている変換スクリプトを使用しました。このスクリプトは_lumina2comfy.py_です。使用方法は、ai-toolkitで生成されたsafetensors LoRAファイルのパスを最初の引数として実行するだけです。これにより、元のファイルと同階層に変換済みのLoRAが保存されます:

python lumina2comfy.py "path/to/my/lora.safetensors"

(フォルダのパスを引数として渡すと、そのフォルダ内のすべてのsafetensorsファイルを一括変換できます。)

誰かの役に立つかもしれません。 😊

(ちなみに、diffusion-pipeはLoRAの変換を必要としません。すでにComfyUIと互換性のある形式でファイルを出力します。)

感想

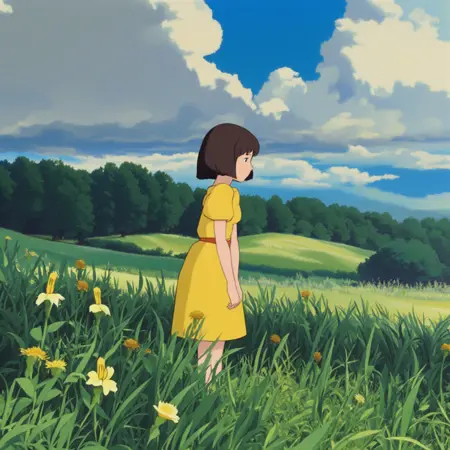

学習の最初の印象は非常に好ましいです。完全ファインチューニングがどれほど効果的かはわかりません(時間や適切なデータセットがなく、検証できていません)。キャラクターやコンセプトのLoRA訓練も試していませんが、このモデルに新しいスタイルを教えることは有望に思えます。

私の素人の意見として、Lumina 2は明らかにFlux(2B対12B)ほど優れてはいませんが、アニメやイラスト用の堅実なベースモデルになり得ると考えます。解剖学的な問題はありますが、このクラスのモデルはすべて解剖学で苦戦しています(テキスト描画にも失敗します)。NSFWコンテンツについてはテストしていませんが、試した人々によるとあまり良くないようです。

その最大の強みは16チャンネルのVAEと、プロンプトの忠実な再現性です(これまで見たどのモデルよりも優れており、ときにはFluxに匹敵します)。また、ライセンスはすべてのT2Iモデルの中で最高です(ただし、彼らは真剣にSchnellのVAEに切り替えるべきです)。

本当の疑問は、ファインチューニングで解剖学の問題を修正できるかどうかです。私はおそらく可能だと思っていますが、確信は持てません。テスト中に得た多くの画像にはさまざまな身体の変形が含まれていましたが、それらの一部はLoRAの影響かもしれません。

コミュニティの支援があれば、これはまた一つのNAI-XLになり得ます。しかし、適切なアニメファインチューニングがなければ、消え去ってしまうリスクがあります。SD3.5Mが現在その危機にさらされているようにです。そして今、誰がKwai KolorsやPixArt Sigma、Hunyuan DITを覚えているでしょうか? ☹️