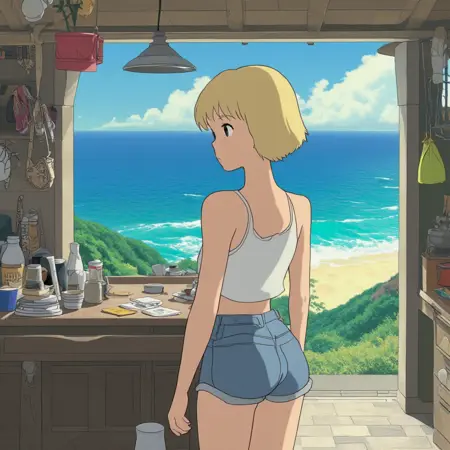

Studio Ghibli 🎨 Lumina-Image 2.0

详情

下载文件

模型描述

描述

原始的 Lumina 2 不理解吉卜力风格。当我提示它时,它会生成带有解剖错误的惊人图像,但这并不是吉卜力风格。

我热爱吉卜力的艺术风格,一直在尝试教会每一个新模型这种风格。这是我在 Lumina Image 2 上的初步尝试成果。它可能可以更好,但也可能更糟 🤷

使用方法

图库中的每张图片都嵌入了工作流,只需将其拖入 ComfyUI 即可。

几乎所有参数都与默认工作流相同,除了:

Steps: 40

Scheduler: sgm_uniform

(注意:这些参数未必最优;我只是恰好用这些设置测试了 LoRA 输出。)

我尚未广泛测试其他采样器,但有消息称 gradient_estimation 采样器可能带来一些改进,而降低 CFG 值有助于提升解剖结构的准确性。

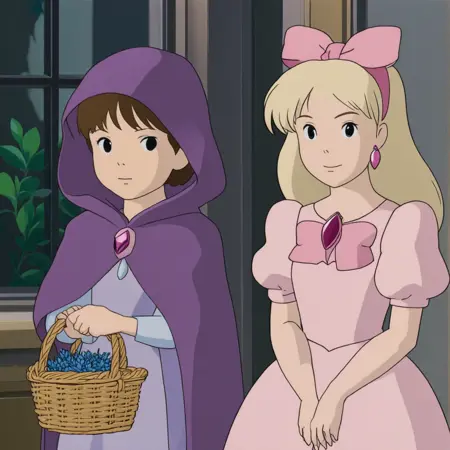

训练

我使用了吉卜力电影的截图片段,共 184 张图像(1024x1024)。

我使用 JoyCaption Alpha Two(本地运行)的“描述性/长”模式为这些图像添加了文本标注,并在每个标注前加上了短语:“You are an assistant designed to generate high-quality images based on user prompts.

(我认为 LLM 前缀并非必要,但我还是加上了。)

训练使用了 ai-toolkit,它最近已将 Lumina-2 训练分支合并到主仓库中。顺便提一下,另一个现在支持 Lumina-2 训练(LoRA 和全参数微调)的训练器是 diffusion-pipe。我也测试了它,但对我来说,它的速度比 ai-toolkit 慢。

最初我尝试了默认配置,但发现默认学习率(1e-04)过高。我尝试了多种优化器,经过 2000–3000 步后,LoRA 效果并不理想。于是我改用 5e-05,结果更好。我决定训练至 20000 步。训练过程感觉非常快(RTX 3090 上约 1.7 秒/步),可能是因为过去两个月我只训练过 HunyuanVideo 😆 训练结束后,我根据 TensorBoard 日志选择那些在训练中样本质量较好或损失最低的检查点,然后在 ComfyUI 中手动测试,最终选择了第 17200 步的检查点。

(我完全确信,要获得一个良好的 LoRA,总步数可以大幅减少。这只是第一次尝试,而且我也想测试一下 Lumina-2 能否持续训练这么久。)

总结一下,我最终使用了以下参数:

lr: 5e-5

optimizer: "adamw8bit"

optimizer_params.betas: [0.95, 0.98]

optimizer_params.weight_decay: 0.01

noise_offset: 0.1

lr_scheduler: "cosine"

其他超参数保持默认。数据集和配置文件已随此 LoRA 附件一并提供。

(我认为保留 rank 16 是个错误,Lumina-2 的 LoRA 至少需要 rank 32 才能充分捕捉风格细节。但我仍在学习中。)

兼容性

有一点需要说明:ai-toolkit 保存的 LoRA safetensors 文件格式与 ComfyUI 不兼容。为解决此问题,我使用了一个脚本(该脚本也包含在训练数据中),可将 ai-toolkit 的 LoRA 检查点转换为 ComfyUI 兼容格式。该脚本名为 _lumina2comfy.py_。使用方法:只需运行脚本,第一个参数设为 ai-toolkit 生成的 safetensors LoRA 文件路径,它将与原文件同目录下生成转换后的 LoRA 文件,例如:

python lumina2comfy.py "path/to/my/lora.safetensors"

(你也可以传入一个文件夹路径,它将批量转换该文件夹内所有 safetensors 文件。)

也许有人会觉得这很方便。😊

(顺便说一句,diffusion-pipe 不需要转换 LoRA —— 它直接输出 ComfyUI 兼容格式的文件。)

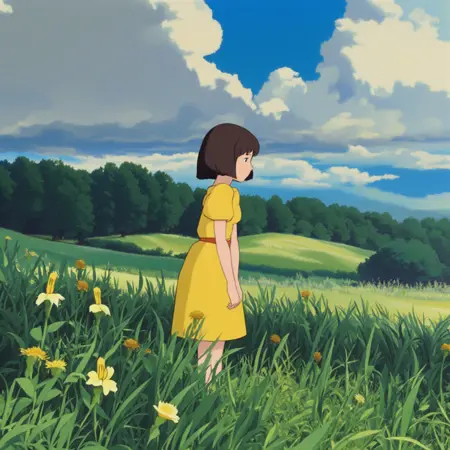

思考

我对训练的初步印象相当积极。我不知道它能否被完全微调(我没有足够的时间或合适的数据集来测试),也没有尝试过角色或概念 LoRA 训练,但我觉得向这个模型传授新风格前景良好。

我对 Lumina 2 的业余看法是:虽然它显然不如 Flux(2B 对 12B),但它可能是一个适合动漫/插画的坚实基础模型。它在解剖结构上有问题,但这类模型普遍都存在解剖缺陷(且在文字渲染上表现糟糕)。至于 NSFW 内容,我未测试,但有测试者称其表现不佳。

它的最大优势在于 16 通道 VAE 和出色的提示遵循能力(比任何我见过的模型都强,有时甚至能媲美 Flux)。它的许可证也是目前所有文生图模型中最好的(但他们真的需要切换到 Schnell 的 VAE)。

真正的问题是:能否通过微调修复解剖问题?我认为可以,但我无法确定。我在测试过程中获得的许多图像都存在各种身体变形,但也许部分是 LoRA 的问题。

在社区支持下,它有可能成为另一个 NAI-XL。但如果缺乏专业的动漫微调,它可能会逐渐被遗忘——就像 SD3.5M 目前面临的困境一样。还有人记得 Kwai Kolors 吗?PixArt Sigma?Hunyuan DIT?☹️