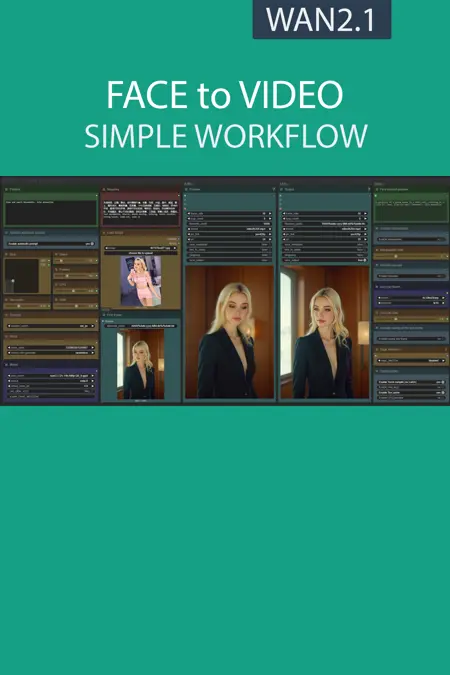

FACE to VIDEO simple workflow WAN2.1 | GGUF | PuLID | UPSCALE | TeaCache

詳細

ファイルをダウンロード

このバージョンについて

モデル説明

ワークフローの説明:

このワークフローの目的は、既存の写真の顔をシンプルなウィンドウで使用して動画を生成することです。

必要なリソース:

📂ファイル:

WAN2.1

推奨:

24 GB VRAM:Q8_0

16 GB VRAM:Q5_K_S

<12 GB VRAM:Q4_K_S

I2V Quantモデル: Wan2.1-I2V-14B-480P-gguf または Wan2.1-I2V-14B-720P-gguf

models/diffusion_models内に配置

CLIP: umt5_xxl_fp8_e4m3fn_scaled.safetensors

models/clip内に配置

CLIP-VISION: clip_vision_h.safetensors

models/clip_vision内に配置

VAE: wan_2.1_vae.safetensors

models/vae内に配置

FLUX

GGUFモデル: FLUX.1-dev-gguf

"flux1-dev-Q8_0.gguf" を ComfyUI\models\unet に配置

GGUF-CLIP: t5-v1_1-xxl-encoder-gguf

"t5-v1_1-xxl-encoder-Q8_0.gguf" を \ComfyUI\models\clip に配置

テキストエンコーダー: ViT-L-14-TEXT-detail-improved-hiT-GmP-TE-only-HF.safetensors

"ViT-L-14-GmP-ft-TE-only-HF-format.safetensors" を \ComfyUI\models\clip に配置

VAE: ae.safetensors

"ae" を \ComfyUI\models\vae に配置

FLUX PuLID: pulid_flux_v0.9.0.safetensors

"pulid_flux_v0.9.0" を \ComfyUI\models\pulid に配置

任意のアップスケールモデル(非推奨):

リアリスティック:RealESRGAN_x4plus.pth

models/upscale_models内に配置

📦カスタムノード:

PuLIDにはPythonにInsightfaceが必要です:

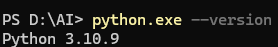

使用しているPythonのバージョンを確認:

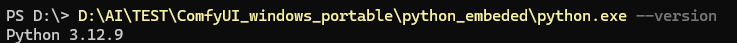

Windowsポータブル版の場合:(パスはComfyUIを解凍した場所によって異なります)

対応するInsightface whlファイルをダウンロード:Assets/Insightface

(私のローカルPythonは3.10、モバイル版は3.12です)

次に、すべての前提条件およびInsightfaceをインストール:

python.exe -m pip install --use-pep517 facexlibpython.exe -m pip install git+https://github.com/rodjjo/filterpy.git

python.exe -m pip install onnxruntime==1.19.2 onnxruntime-gpu==1.15.1 insightface-0.7.3-cp310-cp310-win_amd64.whl