Uncensored Portable Ai Prompt Assistant for Wan, SDXL, Flux.1, and more

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

포터블 AI 프롬프트 어시스턴트는 그 목적을 달성하기 위해 제가 개발한 무료 오픈소스 데스크톱 애플리케이션입니다. 이 도구는 완전히 로컬 머신에서 실행되며, 창작 워크플로우를 강화할 수 있는 개인적이고 유연한 환경을 제공합니다.

왜 이 도구를 만들었나요?

온라인 서비스가 훌륭하지만, 더 많은 제어권, 프라이버시 및 유연성을 제공하는 도구가 필요했습니다. 다음 기능을 갖춘 애플리케이션이 필요했습니다:

내 이미지를 제3자 서버에 보내지 않고 로컬에서 실행될 수 있는 것.

이미 사용 중인 Ollama 및 LM Studio와 연결되어 강력한 오픈소스 모델과 상호작용할 수 있는 것.

다양한 모델의 출력 결과를 동시에 비교할 수 있는 것.

다양한 AI 아트 모델을 위한 고품질 프롬프트 생성에 특화된 것.

검열되지 않은 이미지용 프롬프트를 작성할 수 있는 것.

이미지-투-프롬프트 AI 어시스턴트는 바로 이러한 비전의 결과물입니다.

어떤 모델이든 지원하는 프롬프트 생성 강력한 도구

핵심 설계 목표 중 하나는 특정 생태계에 묶이지 않는 도구를 만드는 것이었습니다. 이 앱이 생성하는 프롬프트는 다양한 텍스트-이미지 모델과 세밀하게 조정되어 작동하도록 설계되었습니다.

사용자 정의 시스템 프롬프트를 통해 AI에게 다음 형식에 맞춰 프롬프트를 생성하도록 지시할 수 있습니다:

SDXL & SD 1.5/2.1: 세부적이고 쉼표로 구분된 키워드 및 네거티브 프롬프트를 생성합니다.

Stable Diffusion 3 (및 Flux.1): 이러한 모델의 더 발전된 자연어 이해 기능을 활용하는 프롬프트를 생성합니다.

DALL-E 3: 대화식, 문장 기반 프롬프트를 작성합니다.

Midjourney: 분위기와 구성에 초점을 맞춘 예술적이고 스타일리시한 프롬프트를 생성합니다.

Wan2.1: 참조 이미지에서 비디오를 생성하거나 T2V에 사용할 텍스트를 최적화합니다.

“시네마틱한 SDXL 프롬프트 생성” 또는 “간단한 애니메이션 스타일 프롬프트 생성”과 같은 선호하는 시스템 프롬프트를 저장하고 단일 클릭으로 전환할 수 있습니다.

(출력 결과를 비교하거나 대상 모델에 최적의 시스템 프롬프트를 설정하세요.)

핵심 기능

이것은 단순한 인터페이스가 아닙니다. 원활하고 강력한 사용자 경험을 위해 설계된 다양한 기능이 탑재되어 있습니다.

로컬 우선, 프라이버시 항상 보장: 로컬 Ollama 또는 LM Studio 서버와 연결됩니다. 이미지와 프롬프트는 절대 머신 외부로 전송되지 않습니다.

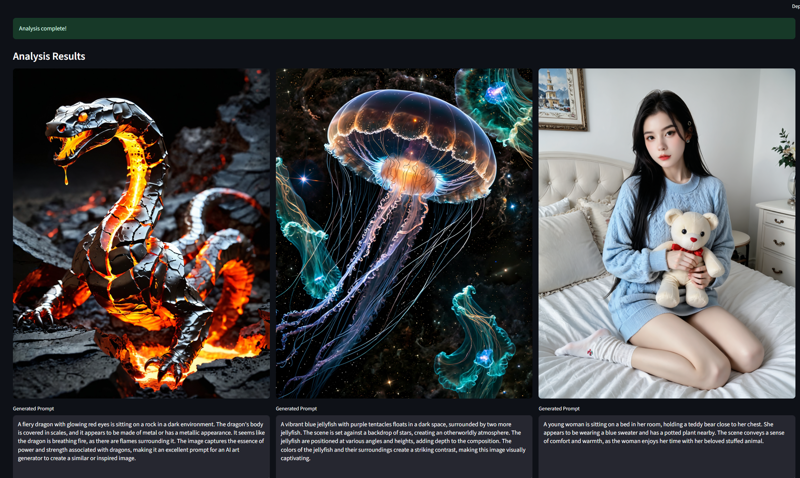

다중 모델 비교: 여러 비전 모델을 선택하면 각각의 응답을 동시에 받을 수 있습니다. 어떤 AI가 더 나은 설명을 제공하는지 확인하세요!

고급 모델 관리 (Ollama): 응답 후 VRAM을 확보하기 위해 수동 또는 자동으로 모델을 메모리에서 언로드할 수 있습니다.

이미지 전용 분석: 특정 질문이 없더라도 이미지를 업로드하고 “분석” 버튼을 클릭하면 즉시 설명을 얻을 수 있습니다.

완전한 사용자 제어: “생성 중단” 버튼을 통해 긴 응답을 언제든지 중단할 수 있습니다.

대화 기록: 전체 세션을 확인하고 .txt 또는 .json 파일로 내보낼 수 있습니다.

사용자 정의 워크플로우: 무제한의 사용자 정의 시스템 프롬프트를 저장하고 재사용하여 AI의 출력을 정확히 원하는 방향으로 조정할 수 있습니다.

시작하기 쉽습니다

이 애플리케이션은 Python과 Streamlit로 작성되었으며 설정이 간단합니다.

필수 조건:

Windows 10 또는 11.

Ollama 또는 LM Studio(권장) 가 설치되어 실행 중입니다.

비전 기능을 갖춘 모델(예: llava, Gemma 3 등)이 다운로드되고 로드되어 있습니다.

🚀 설치 단계

압축 파일을 다운로드한 후 내용을 추출합니다.

AiPromptAssistant 설치 파일을 엽니다.

설치 버튼을 클릭하여 설치를 시작합니다.

4. 다음 링크에서 LM Studio를 다운로드하여 설치하세요: https://lmstudio.ai/

⚙️ 앱 사용 방법

설치 후 다음 단계를 따르세요:

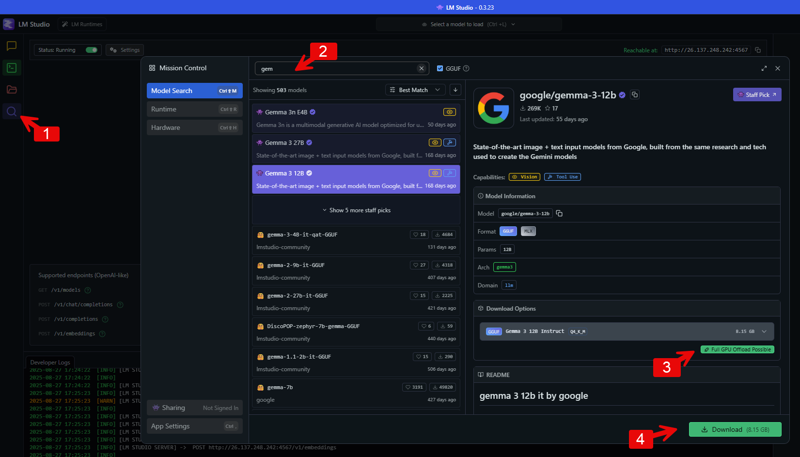

단계 1: LM Studio에서 비전 기능 모델 다운로드

모델 검색으로 이동: LM Studio를 열고 왼쪽 메뉴에서 검색 아이콘(돋보기)을 클릭하여 모델 검색 페이지로 이동합니다.

모델 검색: 상단 검색창에 다운로드하려는 모델 이름을 입력하세요. 이미지를 처리할 수 있는 모델을 찾으려면 “vision” 같은 키워드로 검색할 수 있습니다. 이미지에는 Google의 모델 패밀리인 “gemma”를 검색한 예시가 나와 있습니다. 결과에는 다양한 버전의 모델이 표시됩니다.

모델 선택 및 다운로드: “Vision” 태그가 있는 모델을 찾아 선택하세요. 검색 결과에서 모델을 클릭하면 화면 오른쪽에 세부 정보가 표시됩니다. “다운로드 옵션” 아래에서 사용 가능한 파일을 확인하고 적절한 버전을 선택한 후 “다운로드” 버튼을 클릭하여 컴퓨터에 저장하세요.

사용하는 검열되지 않은 모델:

사용하는 검열되지 않은 모델:

https://model.lmstudio.ai/download/concedo/llama-joycaption-beta-one-hf-llava-mmproj-ggufhttps://model.lmstudio.ai/download/bartowski/mlabonne_gemma-3-27b-it-abliterated-GGUF

https://model.lmstudio.ai/download/mlabonne/gemma-3-12b-it-abliterated-GGUF

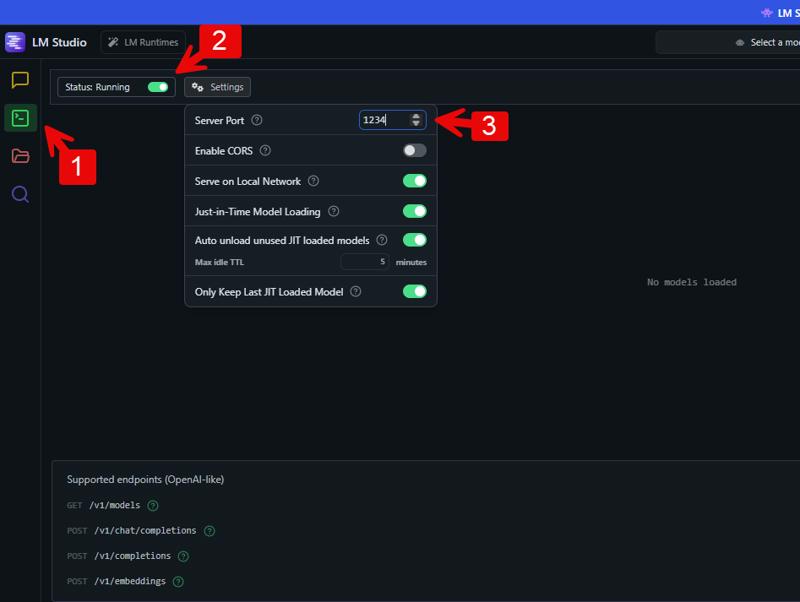

단계 2: LM Studio에서 API 서버 활성화

파워 유저 또는 개발자 보기로 전환: 로컬 서버 설정에 접근하려면 먼저 적절한 보기 모드를 활성화해야 합니다. LM Studio 애플리케이션 하단에서 “Power User” 또는 “Developer” 를 클릭하세요.

로컬 서버 탭으로 이동: LM Studio 왼쪽 메뉴에서 <_> 아이콘을 클릭하여 로컬 서버 설정을 엽니다.

서버 시작: 이 화면 상단에 “상태” 옆에 토글 스위치가 있습니다. “정지됨”에서 “실행 중”으로 변경하여 로컬 API 서버를 시작하세요.

서버 포트 설정: 서버 설정에서 API 포트 번호를 지정할 수 있습니다. 예시 이미지에서 포트는 “1234”로 설정되어 있습니다. 이 기본값을 사용하거나 다른 사용 가능한 포트로 변경할 수 있습니다.

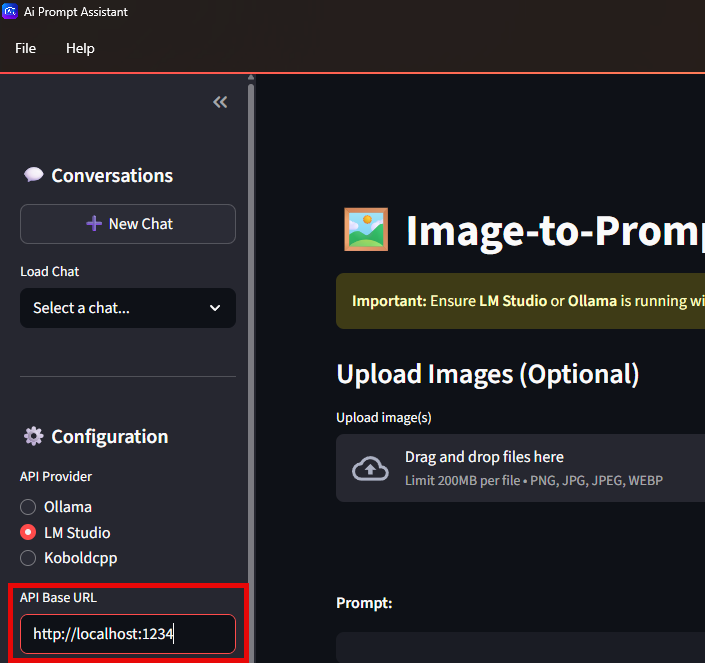

단계 3: 애플리케이션을 LM Studio API에 연결

AI 프롬프트 어시스턴트를 열세요.

API 엔드포인트 구성: 애플리케이션 설정에서 “구성” 섹션을 찾아, API 기본 URL을 입력해야 합니다. 이 URL은 로컬 머신(localhost)과 LM Studio에서 설정한 포트를 가리켜야 합니다.

API 기본 URL 입력: “API Base URL” 필드에 http://localhost: 뒤에 LM Studio에서 설정한 포트 번호를 입력하세요. 예를 들어 포트 1234를 사용했다면 http://localhost:1234을 입력합니다. 이렇게 하면 애플리케이션이 LM Studio에서 실행 중인 모델과 상호작용할 주소를 알게 됩니다.

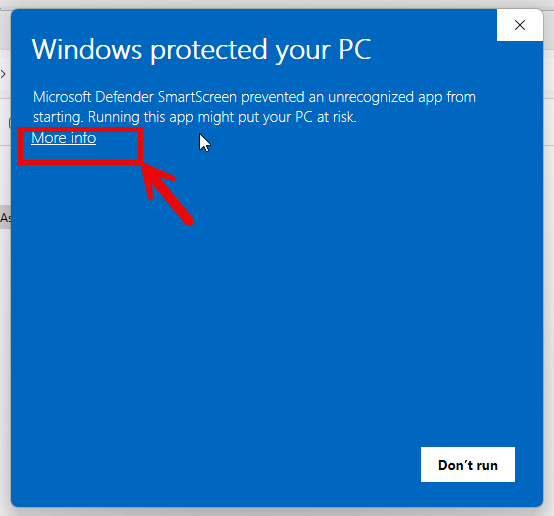

⚠️ 중요 공지

프로그램을 다운로드하고 설치할 때 여러 보안 경고가 표시될 수 있습니다. 이는 패키지에 .exe 파일이 포함되어 있기 때문에 발생하며, 공식 앱 스토어 외부에서 다운로드한 앱, 특히 알려지지 않은 개발자의 앱에서 흔히 발생하는 정상적인 현상입니다.

따라서 걱정하지 마세요. 이는 프로그램에 바이러스가 있다는 뜻이 아닙니다. 인터넷에서 다운로드한 모든 파일과 마찬가지로, 설치 전 신뢰할 수 있는 안티바이러스로 스캔하는 것이 좋으며, 이후 경고는 무시하시면 됩니다.

.exe 애플리케이션 설치가 부담스럽다면, 대신 오픈소스 Python 버전을 사용할 수 있습니다. 단, 이 버전은 몇 가지 추가 설정 단계가 필요하며 일부 기능이 포함되어 있지 않습니다. 아래 링크에서 확인하세요:

👉 오픈소스 Python 버전

업데이트

V1.3: Files API 통합을 통해 Google의 Gemini 모델에 대한 비디오 업로드 및 분석 기능을 추가했습니다.

V1.1: 선택한 폴더의 모든 이미지를 분석할 수 있는 “일괄 분석” 탭을 추가했습니다. 이제 폴더 경로를 입력하고 생성된 프롬프트를 동일한 디렉토리의 텍스트 파일로 저장할 수 있습니다.

V1.2: Google의 Gemini Flash 모델(1.5, 2.0, 2.5) 지원을 추가했습니다.