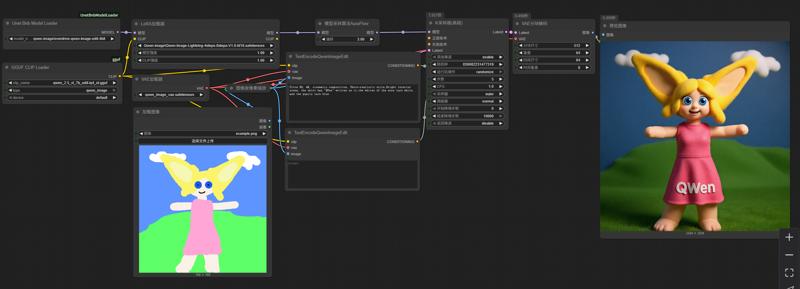

Qwen-image-edit nf4 workflow (4-8steps, 16GB VRAM compatible)

详情

下载文件

模型描述

此工作流使用最新的 bnb 4 位模型加载插件,以 bnb nf4 格式加载 qwen-image 量化模型。

您可以通过 ComfyUI Manager 的插件管理系统直接安装缺失的插件,或搜索 “Unet Bnb Model Loader” 来查找并安装。当然,您也可以手动安装。

所用模型:https://huggingface.co/ovedrive/qwen-image-edit-4bit

请注意,这是一个分片模型,但您无需手动合并分片。只需将它们放置在一个目录中,例如 qwen-image-edit-4bit,然后将该目录放入 unet 目录下即可。插件将自动识别并加载分片模型。在下拉菜单中,分片模型将根据其所在目录显示。

使用以下 LoRa 加速生成:PJMixers-Images/lightx2v_Qwen-Image-Lightning-4step-8step-Merge · Hugging Face

使用以下 text_encoder(需要 GGUF 插件):https://huggingface.co/calcuis/pig-encoder/resolve/main/qwen_2.5_vl_7b_edit-iq4_nl.gguf?download=true

我们强烈建议使用 Pig 提供的 qwen_2.5_vl_7b_edit 系列 gguf 作为 qwen-image-edit 的 text_encoder。这成功地将 mmproj 模型整合进文本编码器,确保通用的 gguf clip 加载器能够顺利加载,而不会出现张量不匹配问题。否则,您将不得不使用更大的 fp8 模型。

整个图像生成过程的速度约为使用 GGUF 模型的两倍,结果与 GGUF Q4 相似。峰值内存使用量约为 14GB,在反复生成图像时可稳定维持在 14GB 左右。

图像生成速度约为 1 it/s,推荐步数为 5-6 步。由于该工作流依赖 BitsAndBytes 库,因此仅支持 NVIDIA 显卡,不兼容其他品牌的显卡。