Kontext Multi-Input Edit - ControlNets and More

详情

下载文件

模型描述

该模型的目的是允许使用多个输入图像但仅生成一个输出图像。其工作方式类似于 Qwen 图像编辑,但适用于 Kontext。它使用关键词 “image1” 和 “image2” 来引用输入。

以下是来自训练数据的一些示例,帮助您理解提示词的编写方式:

示例 1:

输入:

提示:

将 image1 中的人移动到 image2 中的姿势:挺直站立,双脚与髋同宽,双手在身前交叠,头部微向左偏,保持相同的中性照明和米色运动休闲装。

输出:

示例 2:

输入:

提示:

将 image2 中的人移动到 image1 的 OpenPose 所捕捉的流畅倾倒瞬间:裁切至腰部以上,身体略微左倾,将方形酒瓶举高过玻璃杯,使金色酒液倾泻而下,目光专注地追随酒液。保留他的磨砂墨镜、精心打理的胡须、剪裁合体的黑色背心与领带、银色手表、浓郁的威士忌色调,以及具有戏剧感的单向studio灯光,创造出一张清晰的肖像,使其双臂的优雅动作与 image1 的 OpenPose 完全吻合。

输出:

示例 3:

输入:

提示:

image1 中穿米白色西装和粉色针织领带的男人,保持相同的石墙背景、照明和构图,但采用 image2 中展示的欢快双臂上举姿势:手掌打开,与头部齐平,手指张开,保留 image1 中的精准微笑、服装、背景及配色方案。

输出:

说明:

输入图像应拼接在一起:若为竖图,则并排排列;若为横图,则上下排列。对于方形图像,模型训练时已支持两种方式。

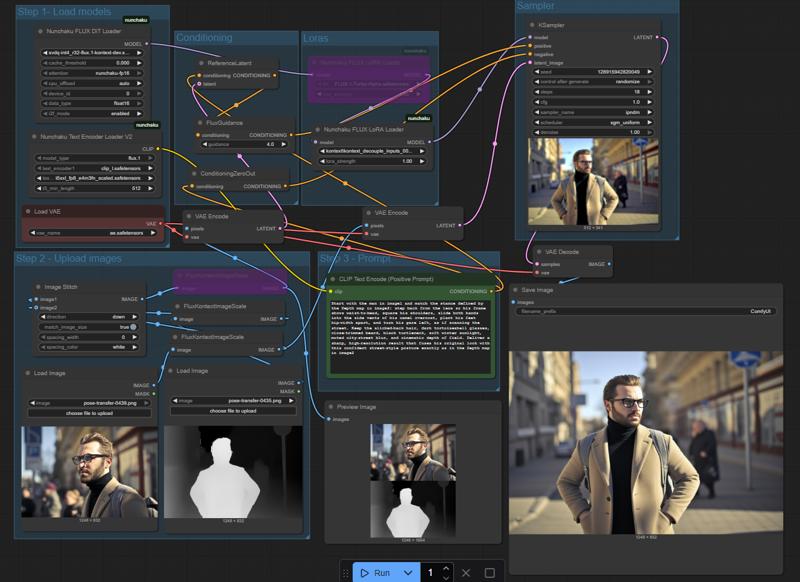

以下是我使用的流程截图,供您参考输入格式:

该模型主要在人物图像上进行训练,但也应能处理多种主题。它学习了 Canny、Depth 和 OpenPose 三种 ControlNet 控制方式,同时也训练了无需 ControlNet 的图像编辑功能,例如角色互换、背景替换、姿势直接迁移等。

我发现 Depth 效果最佳,OpenPose 通常表现良好,但 Canny 的效果稍弱,我计划在后续版本中改进。

该 LoRA 仍处于欠训练状态,我正在构建更优的数据集,以便以更高步数重新训练。在此期间,非常感谢您提供任何反馈意见。