XL-HQVAE-fp16

详情

下载文件

模型描述

将 KBlueLeaf 的 EQ-SDXL-VAE 与 madebyollin 的 SDXL-Fix-VAE 进行了合并。

合并采用 ABBA-LoRA 方法(SVD 方式)和 Tall-Mask-merge 方法,

通过特征提取 + 仅更新特征的方式,选择性地合成 EQ-VAE 的特征。

由此在 Latent cache 和图像输出中更容易获得细节,实现进化。

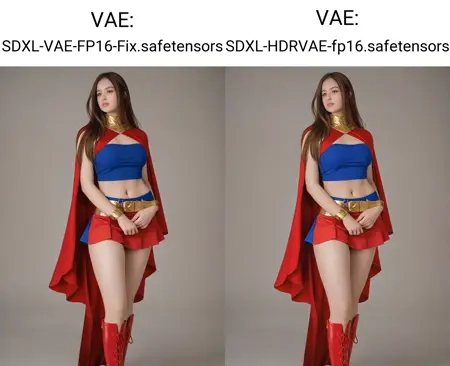

与传统 VAE 替换相比,虽然亮度和饱和度看似提升,

但这源于抑制了细节处的黑场丢失,提升了灰度层次表现。

(通过生成 Latent cache 并用于训练,应能更易学习细节)

※ 若出现 NaN 等问题,请改用 fp32 或停止使用。

※ 已确认可重新生成 Latent 并用于训练完成。

※ 使用 EmoLynx 时,fp8 + 2048px + ZtSNR(e-pred) 也可正常工作。

※ 学习模型在 fp8 与 fp16 下的误差约为 1e-4(与 fp16-32 的误差相当)。

KBlueLeaf:EQ-SDXL-VAE

https://huggingface.co/KBlueLeaf/EQ-SDXL-VAE

madebyollin:SDXL-VAE-FP16-Fix

https://huggingface.co/madebyollin/sdxl-vae-fp16-fix

ABBA-LoRA

https://arxiv.org/abs/2505.14238

Tall-Mask-Merge

https://arxiv.org/abs/2405.07813

输出图像的视觉效果变化不大,

但用于训练时,预计可进一步提升效果。