DPO (Direct Preference Optimization) LoRA for XL and 1.5 - OpenRail++

세부 정보

파일 다운로드

모델 설명

DPO란 무엇인가?

DPO는 Direct Preference Optimization의 약자로, 인간이 선택한 이미지를 기반으로 확산 모델을 미세 조정하는 과정을 의미합니다. 메이후아 당(Meihua Dang) 등은 이 방법과 Pick-a-Pic v2 데이터셋을 사용하여 Stable Diffusion 1.5 및 Stable Diffusion XL을 학습하였으며, 이 데이터셋은 https://huggingface.co/datasets/yuvalkirstain/pickapic_v2에서 확인할 수 있고, 관련 논문은 https://huggingface.co/papers/2311.12908에서 확인할 수 있습니다.

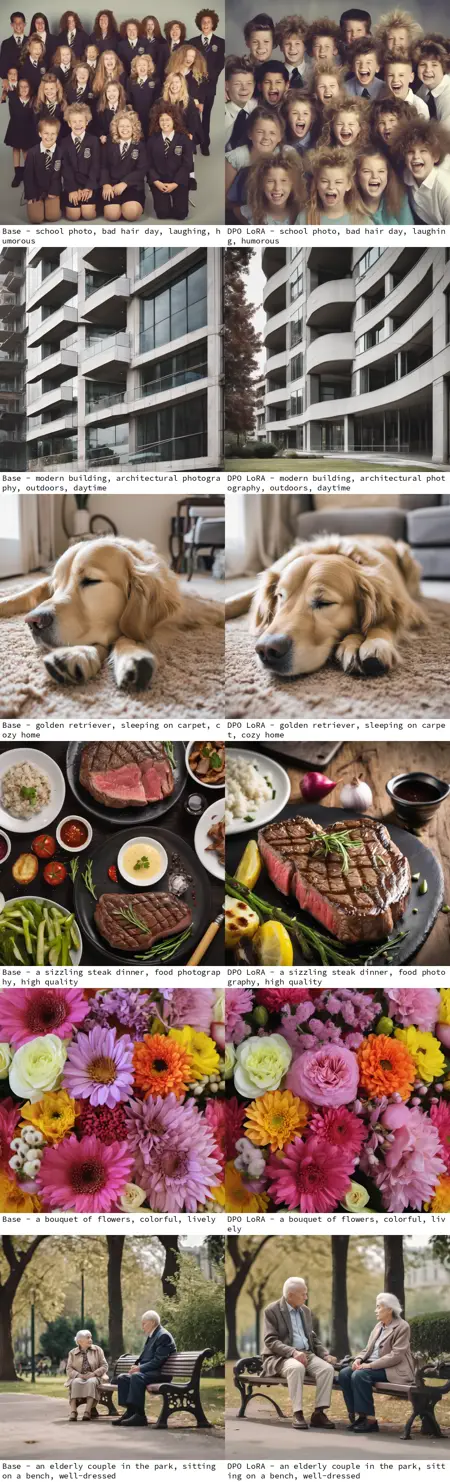

DPO는 무엇을 하는가?

학습된 DPO 모델은 미세 조정되지 않은 모델보다 더 높은 품질의 이미지를 생성하며, 현저한 강조점으로 프롬프트에 대한 모델의 준수도를 높입니다. 이러한 LoRA는 다른 미세 조정된 Stable Diffusion 모델에도 프롬프트 준수 기능을 적용할 수 있습니다.

누가 이 모델을 학습했는가?

이 LoRA는 메이후아 당(Meihua Dang)(https://huggingface.co/mhdang)이 다음 링크에서 공개한 작업을 기반으로 합니다:

https://huggingface.co/mhdang/dpo-sdxl-text2image-v1 및 https://huggingface.co/mhdang/dpo-sd1.5-text2image-v1, 라이선스는 OpenRail++입니다.

이 LoRA는 어떻게 만들어졌는가?

이 LoRA는 Kohya SS를 사용하여 CivitAI 및 HuggingFace에서 라이선스가 OpenRail++인 체크포인트에서 추출하여 생성되었습니다.

1.5: /model/240850/sd15-direct-preference-optimization-dpo는 https://huggingface.co/fp16-guy/Stable-Diffusion-v1-5_fp16_cleaned/blob/main/sd_1.5.safetensors에서 추출되었습니다.

XL: /model/238319/sd-xl-dpo-finetune-direct-preference-optimization는 https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0/blob/main/sd_xl_base_1.0_0.9vae.safetensors에서 추출되었습니다.

이 모델은 또한 HuggingFace에 https://huggingface.co/benjamin-paine/sd-dpo-offsets/에서 호스팅되고 있습니다.