DPO (Direct Preference Optimization) LoRA for XL and 1.5 - OpenRail++

详情

下载文件

模型描述

什么是 DPO?

DPO 是 Direct Preference Optimization(直接偏好优化)的缩写,指基于人类选择的图像对扩散模型进行微调的过程。Meihua Dang 等人使用该方法和 Pick-a-Pic v2 数据集训练了 Stable Diffusion 1.5 和 Stable Diffusion XL,该数据集可在 https://huggingface.co/datasets/yuvalkirstain/pickapic_v2 获取,相关论文见 https://huggingface.co/papers/2311.12908。

它的作用是什么?

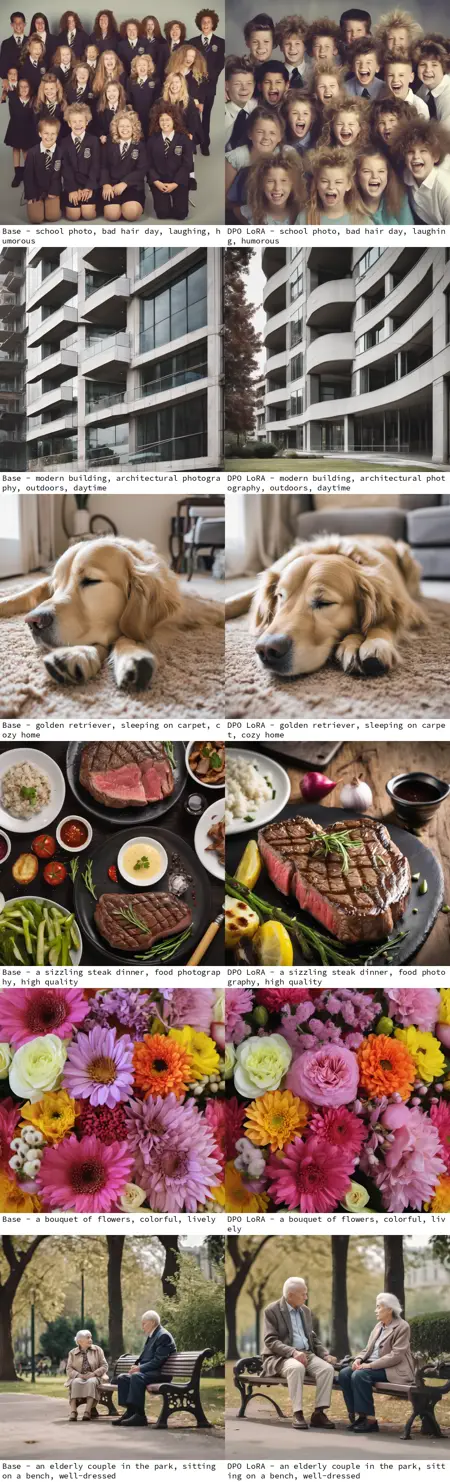

经过训练的 DPO 模型被观察到能生成比未微调版本质量更高的图像,特别强调模型对提示词的遵循程度。这些 LoRA 可将这种提示词遵循能力应用于其他微调的 Stable Diffusion 模型。

谁训练了这些模型?

这些 LoRA 基于 Meihua Dang(https://huggingface.co/mhdang)的工作:

https://huggingface.co/mhdang/dpo-sdxl-text2image-v1 和 https://huggingface.co/mhdang/dpo-sd1.5-text2image-v1,采用 OpenRail++ 许可证。

这些 LoRA 是如何制作的?

它们通过 Kohya SS 创建,从 CivitAI 和 HuggingFace 上其他采用 OpenRail++ 许可的检查点中提取。

1.5:/model/240850/sd15-direct-preference-optimization-dpo,从 https://huggingface.co/fp16-guy/Stable-Diffusion-v1-5_fp16_cleaned/blob/main/sd_1.5.safetensors 提取。

XL:/model/238319/sd-xl-dpo-finetune-direct-preference-optimization,从 https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0/blob/main/sd_xl_base_1.0_0.9vae.safetensors 提取。

这些模型也托管在 HuggingFace 上:https://huggingface.co/benjamin-paine/sd-dpo-offsets/