UrangDiffusion v3.1

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

[v3.1은 아직 추가 테스트 중입니다. 새로운 발견 사항은 “이 버전에 대해” 섹션에 업데이트됩니다.]

UrangDiffusion v3.1(우랑 디퓨전)은 Animagine XL 4.0을 베이스로 사용한 최초의 UrangDiffusion 버전입니다.

“Urang”이라는 이름은 산다네어로 “우리/나”를 의미합니다. 이 이름의 배경에는 이 모델이 단지 제 것뿐만 아니라 많은 사람들에게도 적합하도록 만들고자 하는 의도가 있습니다. 또 다른 이유는 제가 타인의 많은 자원(학습 스크립트, 데이터셋 수집 스크립트 등)을 사용하기 때문입니다. 이 모델을 단지 “제 혼자만의 작품”이라고 주장하는 것은 공정하지 않습니다.

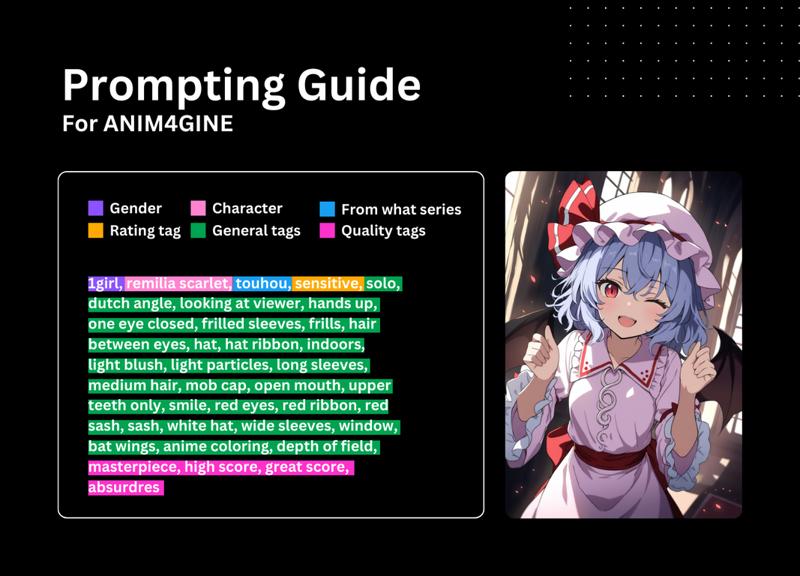

표준 프롬프트 지침

프롬프트 가이드:

기본 부정 프롬프트:

lowres, bad anatomy, bad hands, text, error, missing finger, extra digits, fewer digits, cropped, worst quality, low quality, low score, bad score, average score, signature, watermark, username, blurry기본 설정: Euler a, 약 25-30 스텝, CFG 5-7, ENSD를 31337로 설정. 최적의 조합은 약 28 스텝과 CFG 6입니다.

학습 설정

기반 모델: Animagine XL 4.0 Base (4.0-Zero 아님)

미세 조정:

데이터셋 크기: 약 1,600장의 이미지

GPU: 1xA100 80GB

최적화기: AdaFactor

Unet 학습률: 1.25e-6

텍스트 인코더 학습률: N/A (비활성화)

배치 크기: 48

기울기 누적: 1

워밍업 스텝: 5%

최소 SNR: 5

에포크: 15

자주 묻는 질문

Q: 이미지가 때때로 잡음이 많습니다.

A: 이는 Animagine XL 4.0 모델 전반에서 흔한 문제입니다. 기본 모델은 단지 10 에포크로 학습되었기 때문에 과소 학습 상태입니다. 더 많은 자원으로 학습된 Initial N 또는 Initial I 모델과는 다릅니다.

Q: Hires fix 모델은?

A: 커버 이미지 메타데이터를 확인하시면 거기에 있습니다.

Q: Initial N/Initial I가 더 낫습니다.

A: 그냥 사용하지 않고 떠나세요. 간단합니다. 떠난다고 꼭 발표할 필요 없습니다. 단, 건설적인 피드백을 주거나 향후 프로젝트를 지원할 의향이 있다면 예외입니다.

특별한 감사

통찰과 피드백을 주신 CagliostroLab의 동료들(?)

품질 관리를 도와주신 Nur Hikari 및 Vanilla Latte

AI 생성 이미지에서의 저의 지도자이자 롤 모델이며, 태그 정렬의 주체이신 Linaqruf

라이선스

UrangDiffusion v1.0-v2.5는 Fair AI Public License 1.0-SD 라이선스를 따르며, v3.x는 CreativeML OpenRAIL++-M 라이선스를 따릅니다.