Koda KOLORS Pack - Controlnets,12K Upscale, IPAdapter in ComfyUI

详情

下载文件

模型描述

v5 套装——(安装说明,查看更多,向下滚动)

v5 套装——

v4 套装——

v3 套装——

v2 套装

v1 套装

KODA 收藏集

新 Kolors 基础模型

在 ComfyUI 中使用 IP adapter plus

v1 套装

- 基础 txt2img 和 img2img 工作流

- 基础 Kolors IP adapter-plus

v2 套装

- 带有 SUPIR 超分辨率的高级 IP Adapter 工作流

- 运行 Hyper Kolors / LCM Kolors 的基础工作流

v3 套装

- IP adapter 嵌入

- 一体化工作流

- SUPIR 超分辨率

v4 套装

- 12K,三阶段超分辨率

- SDXL 检查点合并,UNET 块加权

- 采样器花园(调优网格)

v5 套装

- 一体化工作流类型

- ControlNet canny + depth(可切换)

- IP Adapter 高级模式(可切换)

- 采样器花园(可切换)

- 12K 超分辨率(两阶段可切换)

v6 套装

- 一体化工作流类型

- ControlNet canny + depth(可切换)

- IP Adapter 两阶段(可切换)

- 采样器花园(可切换)

- 面部模型创建与替换开关

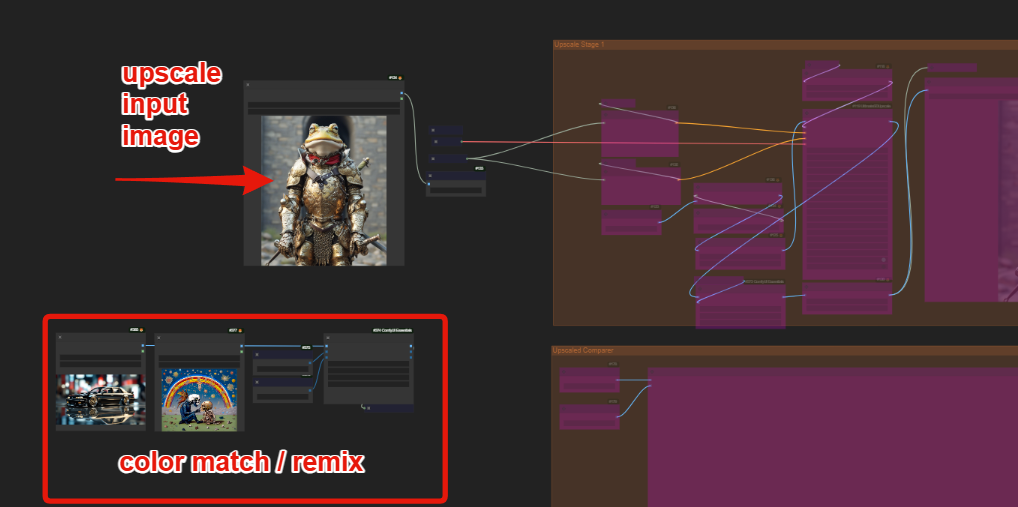

- 带颜色匹配/重混的 12K 超分辨率(两阶段可切换)

- 自动提示增强变体工作流

如何使用 V6 工作流?

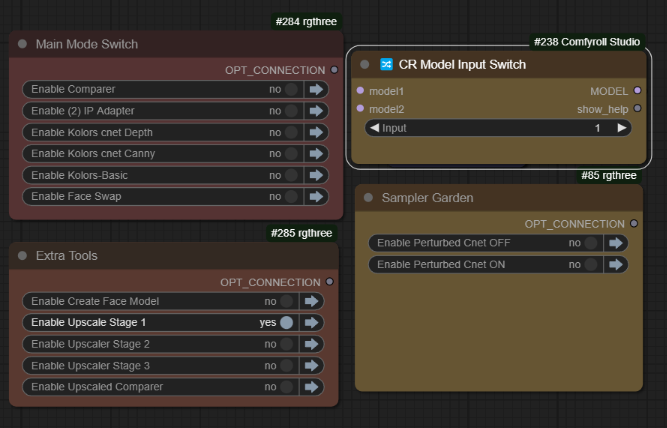

主控制面板已重构,便于操作。

这里可以使用 txt2img 基础 Kolors,通过提示生成简单输出图像。

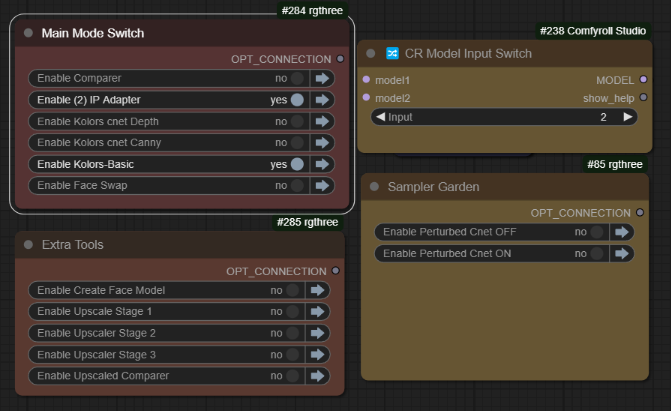

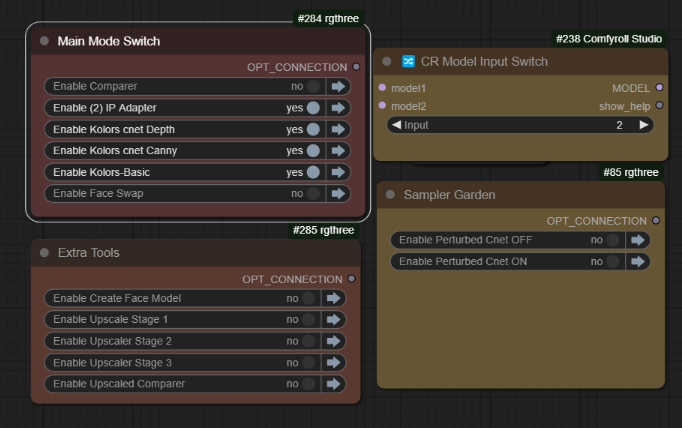

当我们将图像放入 IP Adapter 时,可以如此启用:

如上所示,模型切换(2)用于激活 IPAdapter。您可以通过该开关独立使用 ControlNets 或与 IPAdapter 一起使用。

当您完成制作一些优质图像后,可以激活超分辨率部分:

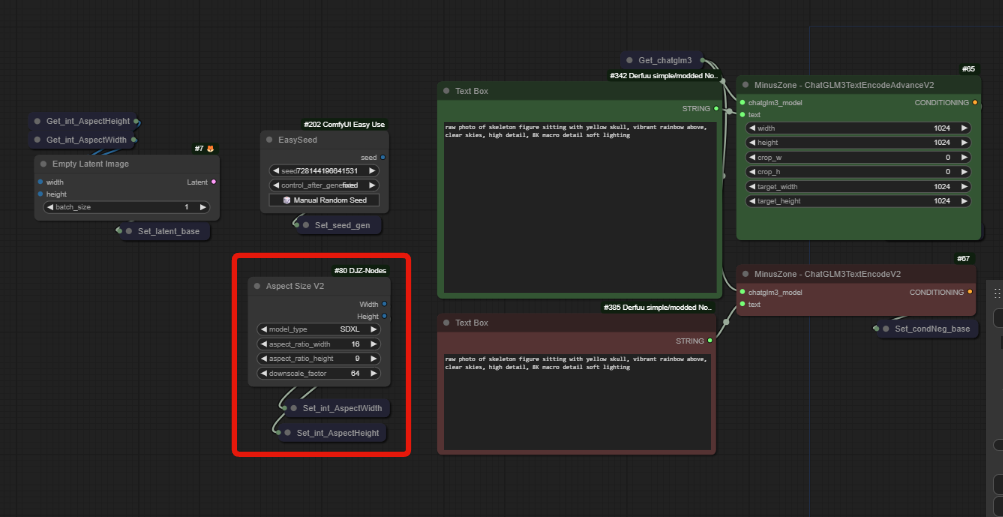

所有尺寸均由 AspectSizeV2 驱动,视频中已全面解释。

使用新的超分辨率器,您有两个选项:颜色匹配和颜色重混:

您可以选择使用同一张图像进行颜色匹配,或尝试其他图像以改变所用的颜色范围。

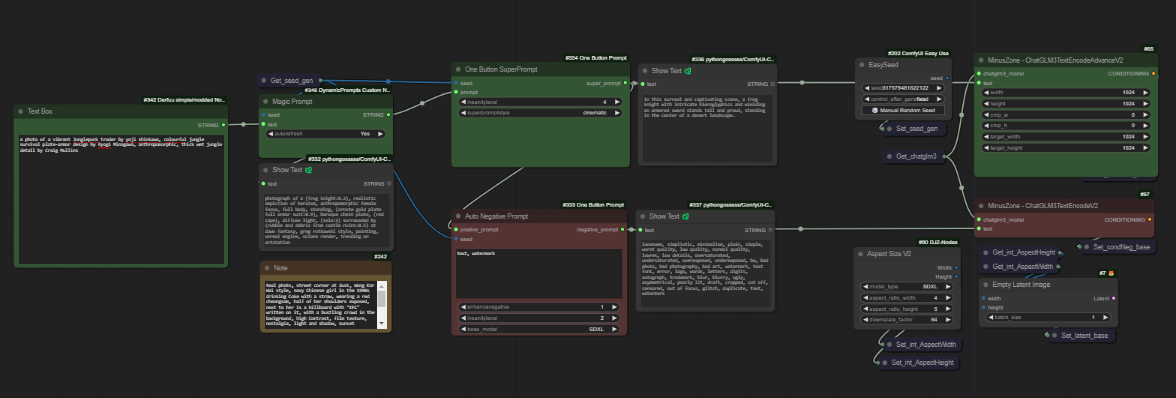

第二个新工作流使用“自动提示”增强器处理正向和负向提示。将您的简单提示输入最左侧的框中,并使用选项通过魔法提示、一键提示和自动负向提示增强您的提示。

这与新的一体化工作流完全相同,此处仅作为您能快速实现功能的示例。它将引入许多稀有标记,并具有正向和负向的风格下拉列表功能及疯狂等级。包含完整预览,以便您查看添加了哪些内容。

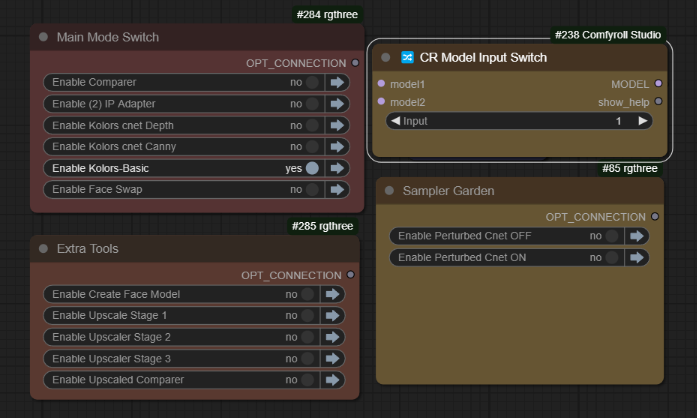

如何使用 V5 工作流?

txt2img 带 Cnet+Ipa

(Koda-Kolors-Zero-Legacy)

基础 Kolors 模式

模型切换(1)

仅启用 Kolors 基础功能

仅作为 txt2img 使用IPadapter 模式

模型切换(2)

启用 Kolors 基础功能及(2)IPadapterControlnet 模式

可与任一模型位置配合使用,按需选择。

默认行为下,请同时启用 Depth 和 Canny 组。所有扰动模式(采样器花园)

可与 ControlNet 或 IPA 模式单独或联合使用

可复制并自定义以构建动态网格12K 超分辨率

每个阶段(1、2、3)均执行 2 倍超分辨率,您也可使用最佳的超分辨率模型

底部设有比较器,便于访问,但请注意:91MB 的图像可能导致 UI 卡顿!建议在阶段 2 和 3 中最小化/折叠/移除所有预览 ;)

如何使用 V4 工作流?

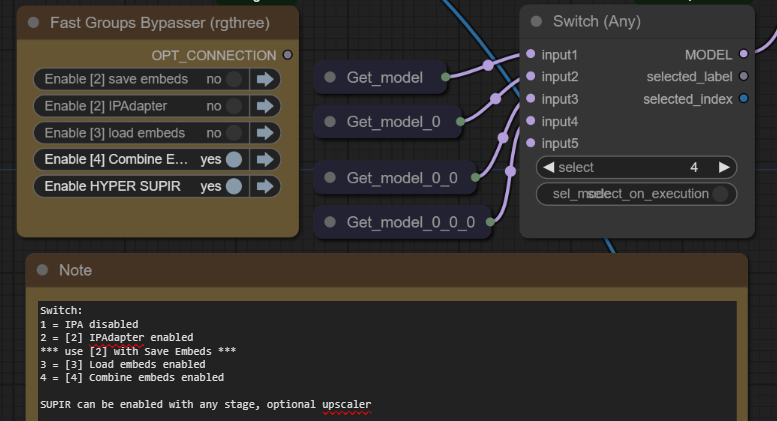

下图:第 4 阶段激活,切换位置 4,[4] 合并嵌入。

新的全功能一体化工作流具有多重功能,您可在阶段 1、2、3、4 中使用,但其操作更加简便。只需将模型切换器与激活组匹配即可。所有内容已在 v3 视频和工作流备注中详细说明。

步骤 1. 仅 txt2img

模型切换 1

当所有组均被跳过时使用

这是 Kolors txt2img

生成图像,并将最佳图像放入 IP Adapter 图像加载节点

最右侧的图像加载器也将用作负向嵌入

步骤 2. a) IP Adapter

模型切换 2

需激活组 [2] IP Adapter

测试所选 IPadapter 图像批次的输出,注意这与提示完全独立。如果您对结果满意;

步骤 2. b) 保存嵌入

模型切换 2

需激活组 [2] IP Adapter

将正向和负向保存为 IPA 嵌入文件

文件保存至 \models\output\

运行一次后,将文件复制到 \models\input\

然后在 ComfyUI 中点击刷新

步骤 3. 加载嵌入

模型切换 3

需激活组 [3] 加载嵌入

创建嵌入后,我们应测试它。

加载正向和负向嵌入,然后测试生成。

重复此过程以创建人物、风格和场景的嵌入元素,以便后续混合,然后进入最终阶段。

步骤 4. 合并嵌入

模型切换 4

需激活组 [4] 合并嵌入

选择嵌入,按需添加或移除节点

支持插值与运算符,包含所有标准 IP Adapter 节点。

此功能类似 SD1.5 中的美学嵌入。

多数情况下,我们希望锚定某种风格或概念,再通过文本提示生成,LoRA 是最佳选择,但在此模型内存限制下,此方法也能非常接近。

SUPIR 组可与任何阶段切换,便于超分辨率。

~

您需要:

- 安装所有缺失的自定义节点,并使用最新版 ComfyUI

- 观看 v1 视频获取更多设置信息

https://huggingface.co/Kijai/ChatGLM3-safetensors/tree/main

下载其中一个模型,我将使用 fp8 版本,您也可选择其他版本。

将其置于 ComfyUI\models\LLM\checkpoints\

https://huggingface.co/Kwai-Kolors/Kolors/resolve/main/unet/diffusion_pytorch_model.fp16.safetensors

将其置于 ComfyUI/models/unet/diffusers/kolors

https://huggingface.co/Kwai-Kolors/Kolors

我还在此处添加了来自 diffusers 的所有这些文件。

我们已下载“diffusion_pytorch_model.fp16.safetensors”并将其放入 /models/unet/kolors/。部分节点在不同位置查找,您可以根据偏好选择任一方法,两者均有效,视频中已讨论。

我们不需要 text_encoder 内容的任何 .bin 文件,因为我们使用了 ChatGLM3.fp8.safetensors。

ComfyUI\models\diffusers\Kolors\ 的目录结构如下:

ComfyUI\models\diffusers\Kolors> tree /F

│ model_index.json

│

├───scheduler

│ scheduler_config.json

│

├───text_encoder

│ config.json

│ tokenizer.model

│ tokenizer_config.json

│ vocab.txt

│

└───unet

config.json

diffusion_pytorch_model.fp16.safetensors

Kolors IP Adapter

https://huggingface.co/Kwai-Kolors/Kolors-IP-Adapter-Plus

下载 ip_adapter_plus_general.bin

将其置于 \models\ipadapter\kolors\

Kolors Clip Vision

https://huggingface.co/Kwai-Kolors/Kolors-IP-Adapter-Plus/tree/main/image_encoder

下载 pytorch_model.bin

将其置于 \models\clip_vision\kolors\

将其置于 \models\controlnet\kolors\

我建议使用子文件夹,或按需重命名。

VAE

所有 VAE 均使用您最喜欢的 SDXL VAE 即可。

CONTROLNET

下载并重命名为 kolors_controlnet_depth.safetensors

https://huggingface.co/Kwai-Kolors/Kolors-ControlNet-Canny/resolve/main/diffusion_pytorch_model.safetensors?download=true

下载并重命名为 kolors_controlnet_canny.safetensors

将两者均置于 \models\controlnet\kolors\

~

没有以下人员的努力,此项目不可能实现:

@cubiq [IP Adapter 节点]

@kijai [Kolors 封装]

@MinusZoneAI [Kolors IPAdapter 节点]

Cubiq

https://github.com/cubiq/ComfyUI_InstantID

Minus Zone AI

https://github.com/MinusZoneAI