Koda KOLORS Pack - Controlnets,12K Upscale, IPAdapter in ComfyUI

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

v5 패키지 -- (설치 정보, 더 보기, 아래로 스크롤)

v5 패키지 --

v4 패키지 --

v3 패키지 --

v2 패키지

v1 패키지

KODA 컬렉션

새로운 Kolors 기본 모델

ComfyUI에서 IP 어댑터 플러스 사용

v1 패키지

- 기본 txt2img 및 img2img 워크플로우

- 기본 Kolors IP 어댑터-플러스

v2 패키지

SUPIR 업스케일러를 사용한 고급 IP 어댑터 워크플로우

Hyper Kolors / LCM Kolors 실행을 위한 기본 워크플로우

v3 패키지

IP 어댑터 임베드

모든 기능을 하나로 통합한 워크플로우

SUPIR 업스케일링

v4 패키지

12K, 3단계 업스케일링

SDXL 체크포인트 병합, UNET 블록 가중치

Sampler Garden (튜닝된 그리드)

v5 패키지

모든 기능을 하나로 통합한 워크플로우

ControlNet Canny + Depth (토글)

IP 어댑터 고급 (토글)

Sampler Garden (토글)

12K 업스케일링 (2단계 토글)

v6 패키지

모든 기능을 하나로 통합한 워크플로우

ControlNet Canny + Depth (토글)

IP 어댑터 2단계 (토글)

Sampler Garden (토글)

얼굴 모델 생성 및 교체 토글

색상 일치/리믹스를 포함한 12K 업스케일링 (2단계 토글)

자동 프롬프트 강화 변형 워크플로우

V6 워크플로우 사용법

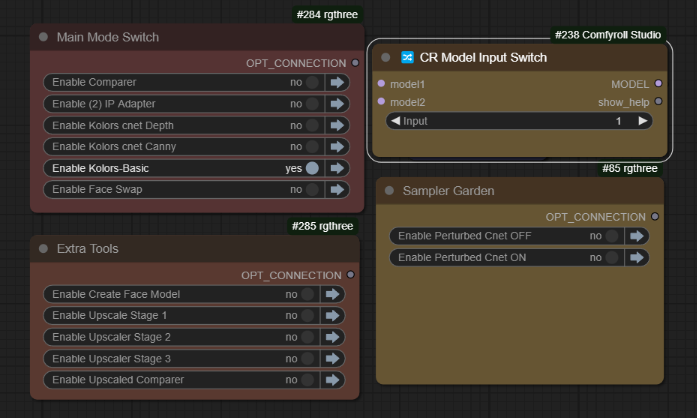

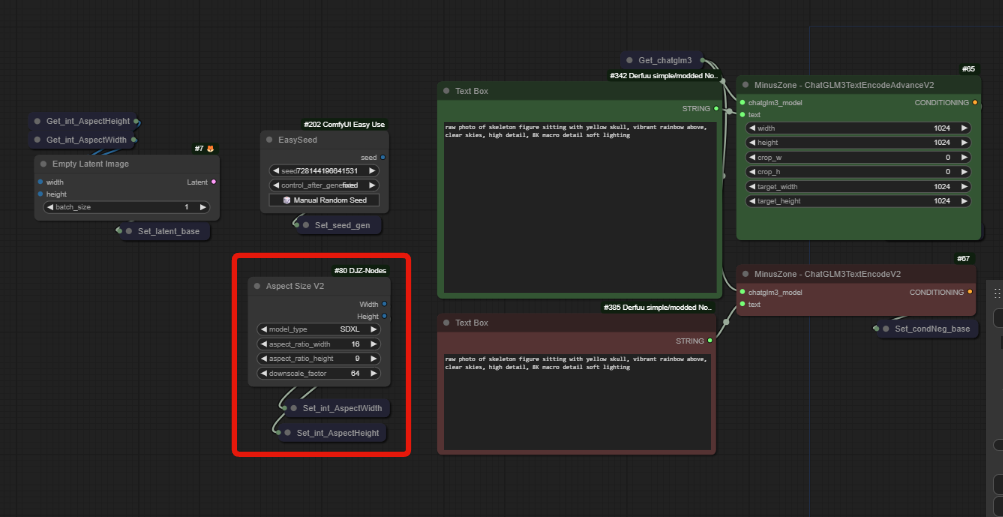

주 컨트롤 패널은 더 쉬운 작업을 위해 재구성되었습니다. 여기서 txt2img 기본 Kolors를 사용하여 프롬프트에서 간단한 출력 이미지를 얻을 수 있습니다.

여기서 txt2img 기본 Kolors를 사용하여 프롬프트에서 간단한 출력 이미지를 얻을 수 있습니다.

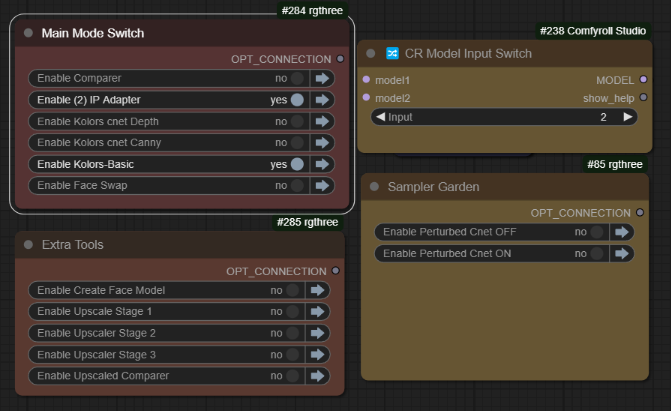

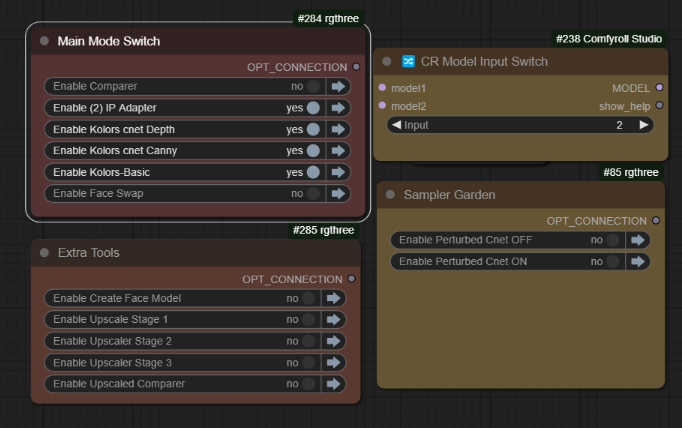

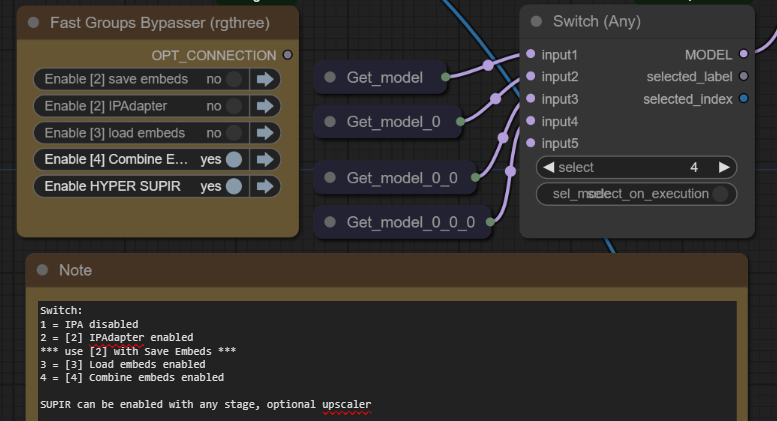

IP 어댑터에 이미지를 배치한 후 다음과 같이 활성화할 수 있습니다: 위와 같이 모델 스위치(2)를 사용하여 IPAdapter를 활성화할 수 있습니다. 이 스위치를 사용하여 IPAdapter를 사용하거나 사용하지 않고 ControlNets를 사용할 수 있습니다.

위와 같이 모델 스위치(2)를 사용하여 IPAdapter를 활성화할 수 있습니다. 이 스위치를 사용하여 IPAdapter를 사용하거나 사용하지 않고 ControlNets를 사용할 수 있습니다. 좋은 이미지를 완성한 후에는 업스케일링 섹션을 활성화할 수 있습니다:

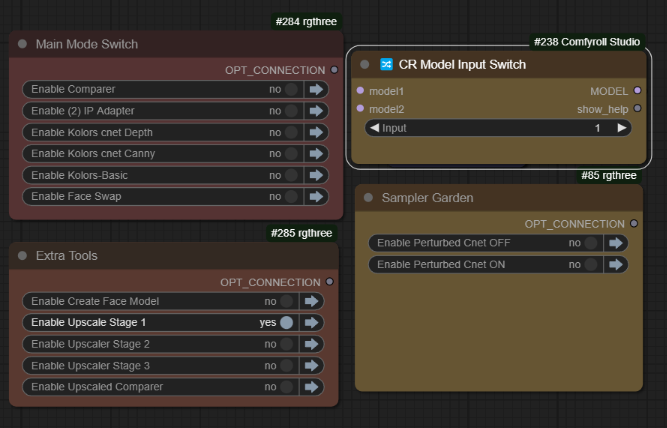

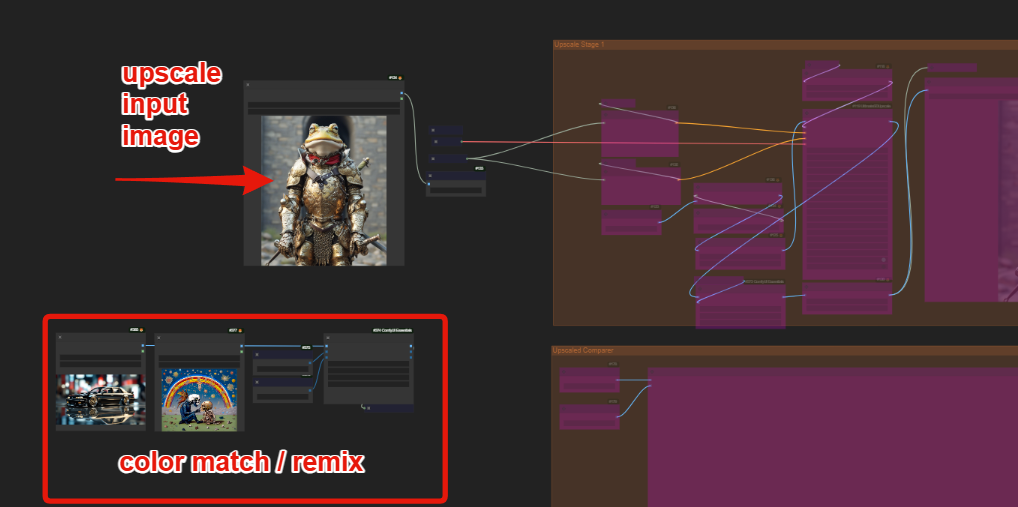

좋은 이미지를 완성한 후에는 업스케일링 섹션을 활성화할 수 있습니다:

모든 치수는 AspectSizeV2에 의해 제어되며, 동영상에서 자세히 설명되어 있습니다.

새로운 업스케일러를 사용하면 색상 일치 및 색상 리믹스 두 가지 옵션이 있습니다:

색상 일치에 동일한 이미지를 사용하거나, 다른 이미지를 사용하여 사용되는 색상 범위를 변경해볼 수 있습니다.

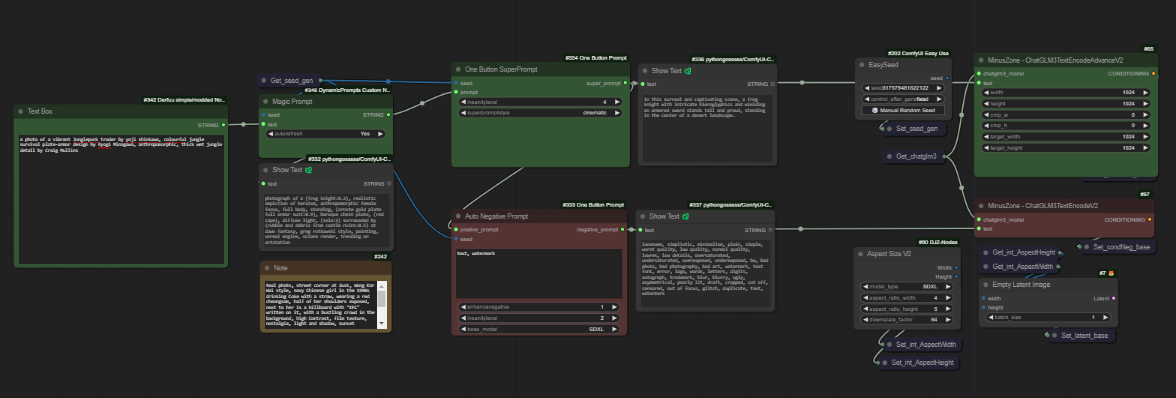

두 번째 새로운 워크플로우는 양/음성 프롬프트 모두에 "자동 프롬프트" 강화기를 사용합니다. 왼쪽 상자에 간단한 프롬프트를 입력하고, 마법 프롬프트, 한 번 클릭 프롬프트, 자동 음성 프롬프트 옵션을 사용하여 프롬프트를 강화하세요.

이것은 새로운 모든 기능 통합 워크플로우와 동일하며, 이 기능을 통해 빠르게 할 수 있는 예시를 보여줍니다. 이는 많은 희귀한 토큰을 도입하며, 양성 및 음성 모두에 스타일 드롭다운 목록 기능과 미친 수준을 제공합니다. 추가된 내용을 볼 수 있도록 전체 미리보기가 포함되어 있습니다.

이것은 새로운 모든 기능 통합 워크플로우와 동일하며, 이 기능을 통해 빠르게 할 수 있는 예시를 보여줍니다. 이는 많은 희귀한 토큰을 도입하며, 양성 및 음성 모두에 스타일 드롭다운 목록 기능과 미친 수준을 제공합니다. 추가된 내용을 볼 수 있도록 전체 미리보기가 포함되어 있습니다.

V5 워크플로우 사용법?

txt2img with Cnet+Ipa

(Koda-Kolors-Zero-Legacy)

기본 Kolors 모드

모델 스위치 (1)

Kolors 기본 기능만 활성화됨

txt2img 전용으로 작동

IP 어댑터 모드

모델 스위치 (2)

Kolors 기본 및 (2) IP 어댑터 활성화됨

ControlNet 모드

원하는 모델 위치 모두에서 사용 가능

기본 동작을 위해 Depth & Canny 그룹을 함께 활성화하세요

모든 변형 모드 (Sampler Garden)

ControlNet 또는 IPA 모드와 함께 사용하거나 사용하지 않아도 됨

복사하여 사용자 정의하여 동적 그리드를 구축할 수 있음

12K 업스케일링

각 단계 1, 2, 3은 2배 업스케일링을 수행하며, 최상의 업스케일링 모델도 사용 가능

하단에 비교기 위치 (간편 액세스용), 그러나 91MB 이미지는 UI 지연을 유발할 수 있음! 단계 2와 3에서 모든 미리보기를 최소화/접기/제거하는 것을 추천합니다 ;)

V4 워크플로우 사용법?

아래 이미지: Stage 4 활성화, 스위치 위치 4, [4] 임베드 병합

새로운 모든 기능 통합 워크플로우는 다기능이며, 1, 2, 3, 4 단계에서 사용 가능하지만 훨씬 더 쉽게 사용할 수 있습니다. 단순히 모델 스위치를 활성화된 그룹과 일치시키기만 하면 됩니다. 모든 내용은 v3 동영상과 워크플로우 노트에 설명되어 있습니다.

새로운 모든 기능 통합 워크플로우는 다기능이며, 1, 2, 3, 4 단계에서 사용 가능하지만 훨씬 더 쉽게 사용할 수 있습니다. 단순히 모델 스위치를 활성화된 그룹과 일치시키기만 하면 됩니다. 모든 내용은 v3 동영상과 워크플로우 노트에 설명되어 있습니다.

단계 1. txt2img 전용

모델 스위치 1

모든 그룹을 우회할 때 사용

이것은 Kolors txt2img입니다.

이미지를 생성하고, 가장 좋은 이미지를 IP 어댑터 이미지 로드 노드에 배치하세요.

오른쪽 가장자리 이미지 로더는 음성 임베드에도 사용됩니다.

단계 2. a) IP 어댑터

모델 스위치 2

그룹 [2] IP 어댑터가 활성화되어야 함

선택한 IP 어댑터 이미지 배치의 출력을 테스트하세요. 이는 프롬프트와 완전히 별개임을 기억하세요. 결과가 만족스럽다면;

단계 2. b) 임베드 저장

모델 스위치 2

그룹 [2] IP 어댑터가 활성화되어야 함

양성 및 음성 임베드를 IPA 임베드 파일로 저장합니다.

이 파일은 \models\output\에 저장됩니다.

한 번 실행한 후 파일을 \models\input\로 복사하세요.

그런 다음 ComfyUI에서 새로 고침을 클릭하세요.

단계 3. 임베드 로드

모델 스위치 3

그룹 [3] 임베드 로드가 활성화되어야 함

임베드를 생성한 후 테스트해야 합니다.

양성 및 음성 임베드를 로드한 후 생성을 테스트하세요.

문자, 스타일, 장면을 사용하여 반복하여 혼합할 요소를 확보한 후 최종 단계로 이동하세요.

단계 4. 임베드 병합

모델 스위치 4

그룹 [4] 임베드 병합이 활성화되어야 함

필요에 따라 임베드를 선택하고 노드를 추가/제거하세요.

보통의 IP 어댑터 노드와 함께 보간 및 연산자 사용 가능

이것은 SD1.5에서 미적 임베드가 작동한 방식과 유사합니다.

대부분의 경우 스타일 또는 개념에 고정하고 텍스트 프롬프트를 사용하여 생성하는 것이 목표이며, LORA가 가장 적합합니다. 그러나 모델 메모리 제약 내에서 이 방식도 매우 가까운 결과를 낼 수 있습니다.

SUPIR 그룹은 모든 단계에서 토글하여 쉽게 업스케일링할 수 있습니다.

~

필요 사항:

누락된 모든 사용자 정의 노드를 설치하고 최신 버전의 ComfyUI를 사용하세요

더 많은 설정 정보는 v1 동영상을 시청하세요

https://huggingface.co/Kijai/ChatGLM3-safetensors/tree/main

모델 중 하나를 다운로드하세요. 저는 fp8 버전을 사용할 것이며, 다른 버전을 사용할 수도 있습니다.

**ComfyUI\models\LLM\checkpoints\**에 배치하세요.

https://huggingface.co/Kwai-Kolors/Kolors/resolve/main/unet/diffusion_pytorch_model.fp16.safetensors

ComfyUI/models/unet/diffusers/kolors에 배치하세요.

https://huggingface.co/Kwai-Kolors/Kolors

이곳에는 diffusers의 모든 파일을 추가했습니다.

우리는 이미 "diffusion_pytorch_model.fp16.safetensors"를 다운로드하여 **/models/unet/kolors/**에 넣었습니다. 일부 노드는 다른 위치를 검색하므로, 두 방식 모두 작동하므로 원하는 방식을 선택하시면 됩니다. 이 내용은 동영상에서 설명됩니다.

text_encoder 내용의 .bin 파일은 필요하지 않습니다. 대신 ChatGLM3.fp8.safetensors를 사용했기 때문입니다.

**ComfyUI\models\diffusers\Kolors\**의 구조

ComfyUI\models\diffusers\Kolors> tree /F

│ model_index.json

│

├───scheduler

│ scheduler_config.json

│

├───text_encoder

│ config.json

│ tokenizer.model

│ tokenizer_config.json

│ vocab.txt

│

└───unet

config.json

diffusion_pytorch_model.fp16.safetensors

Kolors IP 어댑터

https://huggingface.co/Kwai-Kolors/Kolors-IP-Adapter-Plus

ip_adapter_plus_general.bin 다운로드

**\models\ipadapter\kolors\**에 배치하세요.

Kolors Clip Vision

https://huggingface.co/Kwai-Kolors/Kolors-IP-Adapter-Plus/tree/main/image_encoder

pytorch_model.bin 다운로드

**\models\clip_vision\kolors\**에 배치하세요.

**\models\controlnet\kolors\**에 배치하세요.

하위 폴더를 권장하며, 원하시는 경우 이름을 변경하세요.

VAE

모든 VAE는 선호하는 SDXL VAE를 사용하세요.

CONTROLNET

다운로드하고 kolors_controlnet_depth.safetensors로 이름을 바꾸세요.

https://huggingface.co/Kwai-Kolors/Kolors-ControlNet-Canny/resolve/main/diffusion_pytorch_model.safetensors?download=true

다운로드하고 kolors_controlnet_canny.safetensors로 이름을 바꾸세요.

두 파일 모두 **\models\controlnet\kolors\**에 배치하세요.

~

이 작업은 다음 분들의 노고 없으면 불가능했습니다:

@cubiq [IP 어댑터 노드]

@kijai [Kolors Wrappers]

@MinusZoneAI [Kolors IPAdapter 노드]

Cubiq

https://github.com/cubiq/ComfyUI_InstantID

Kijai

Minus Zone AI