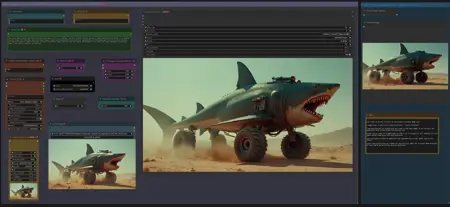

LTX IMAGE to VIDEO with STG, CAPTION & CLIP EXTEND workflow

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

워크플로우: 이미지 -> 자동 캡션(Prompt) -> LTX 이미지에서 비디오로

2025년 7월 20일 업데이트: LTX 0.9.8용 GGUF 모델:

디스틸된 모델, V9.5와 호환: https://huggingface.co/QuantStack/LTXV-13B-0.9.8-distilled-GGUF/tree/main

개발용 모델, V9.0과 호환: https://huggingface.co/QuantStack/LTXV-13B-0.9.8-dev-GGUF/tree/main

(위 링크의 "Model Card"에서 LTX 0.9.8 VAE 및 textencoder 다운로드 정보 확인)

V9.5: LTX 0.9.7 디스틸된 워크플로우 – LTX 0.9.7 디스틸된 GGUF 모델 지원.

Florence를 사용한 워크플로우와 LTX 프롬프트 향상기(LTXPE)를 사용한 워크플로우가 있음.

GGUF 모델 다운로드:

https://huggingface.co/wsbagnsv1/ltxv-13b-0.9.7-distilled-GGUF/tree/main

VAE 및 Textencoder는 이전 LTX 0.9.6 모델과 동일함 (아래 V8.0 참조)

LTX 0.9.7 디스틸된 버전은 8단계만 사용하여 매우 빠름.

V9.0: LTX 0.9.7 워크플로우 – LTX 0.9.7 GGUF 모델 지원.

Florence를 사용한 워크플로우와 LTX 프롬프트 향상기(LTXPE)를 사용한 워크플로우가 있음.

GGUF 모델 다운로드:

https://huggingface.co/wsbagnsv1/ltxv-13b-0.9.7-dev-GGUF/tree/main

VAE 및 Textencoder는 이전 LTX 0.9.6 모델과 동일함 (아래 V8.0 참조)

LTX 0.9.7은 130억 파라미터 모델로, 이전 버전은 20억 파라미터만 had었기 때문에 VRAM 사용량이 더 많고 처리 시간이 더 길어짐. 매우 빠른 렌더링을 원한다면 아래 V8.0의 0.9.6 모델 또는 V9.5를 사용하세요.

V8.0: LTX 0.9.6 워크플로우 (동일한 워크플로우에 dev 및 distilled GGUF 모델 포함)

Florence2 캡션 버전과 LTX 프롬프트 향상기(LTXPE) 버전이 있음.

GGUF 모델(Dev & Distilled) 다운로드:

https://huggingface.co/calcuis/ltxv0.9.6-gguf/tree/main

VAE: pig_video_enhanced_vae_fp32-f16.gguf

Textencoder: t5xxl_fp32-q4_0.gguf

V7.0: LTX 0.9.5 모델 버전 – GGUF + Wavespeed/Teacache

LTX 0.9.5 GGUF 모델 및 VAE: https://huggingface.co/calcuis/ltxv-gguf/tree/main

(vae_ltxv0.9.5_fp8_e4m3fn.safetensors)

Clip Textencoder: https://huggingface.co/city96/t5-v1_1-xxl-encoder-gguf/tree/main

2개의 워크플로우가 있음: Florence 캡션만 사용하는 기본 버전과 Florence + LTX 프롬프트 향상기 버전. Wavespeed로 설정됨(기본적으로 비활성화, Strg+B로 활성화)

이 워크플로우는 모든 GGUF 모델(0.9 / 0.9.1 / 0.9.5)과 호환됨

프롬프트 향상기용 무심사 LLM: https://huggingface.co/skshmjn/unsloth_llama-3.2-3B-instruct-uncenssored

- 사용 중단됨 (2025년 3월) - V6.0: GGUF/TiledVAE 버전 & 마스크된 모션 블러 버전

GGUF 모델을 사용하여 VRAM 절약 및 실행 속도 향상.

표준 버전은 GGUF 모델만 사용하고, GGUF+TiledVae+Clear Vram 버전은 VRAM 요구량을 더 줄임. 1024 해상도, 161 프레임, 32 스텝으로 큰 GGUF 모델(Q8)을 테스트한 결과, GGUF 버전은 최대 14GB VRAM을 사용했고, TiledVae+ClearVram 버전은 최대 7GB를 사용함. 더 작은 GGUF 모델은 요구량을 더 줄일 수 있음.

GGUF 모델, VAE 및 Textencoder 다운로드:

(모델 & VAE): https://huggingface.co/calcuis/ltxv-gguf/tree/main

(안티 체크보드 VAE): https://huggingface.co/spacepxl/ltx-video-0.9-vae-finetune/tree/main

(Clip Textencoder): https://huggingface.co/city96/t5-v1_1-xxl-encoder-gguf/tree/main

VRAM이 16GB 이상이라면 GGUF 버전을, 16GB 미만이라면 TiledVae+ClearVram 버전을 사용하세요.

마스크된 모션 블러 버전: LTX는 모션 블러에 취약하므로, 입력 이미지에 마스크를 설정하고 마스크 영역에만 모션 블러를 적용하여 특정 움직임을 유도할 수 있는 추가 그룹을 워크플로우에 포함함. (이론상으로는 좋지만 실제 효과는 제한적임. 일부 경우에 유용함). GGUF 및 GGUF+TiledVAE+ClearVram 버전 모두 포함됨.

V5.0: 새로운 LTX 모델 0.9.1 지원

LowVram 버전 추가 (VAE 전에 VRAM을 클리어함)

LTX 모델 0.9.1과 LTX 모델 0.9를 비교할 수 있는 워크플로우 추가

(V4는 모델 출시 당시 0.9.1과 호환되지 않아 V5가 만들어졌음. 이후 ComfyUI 및 노드가 업데이트되어 현재 V4와 V5 모두 0.9 및 0.9.1 모델을 사용 가능. 두 버전은 모델 관리를 위한 자체 커스텀 노드가 다름. 그 외에는 동일함. 메모리 문제 또는 긴 처리 시간이 발생하면 아래 팁 참조)

- 사용 중단됨 (2025년 3월) - V4.0: 비디오/클립 확장 기능 도입

이전 클립의 마지막 프레임을 기반으로 클립을 확장할 수 있음. 품질 저하 전까지 약 2~3배 확장 가능. 워크플로우의 설명 참고.

Florence 캡션을 우회하고 자체 프롬프트를 사용할 수 있는 기능 추가.

V3.0: STG(Spatiotemporal Skip Guidance for Enhanced Video Diffusion Sampling) 도입

SIMPLE 및 ENHANCED 워크플로우 포함. ENHANCED 버전은 입력 이미지를 업스케일하는 추가 기능으로 일부 경우 유용함. SIMPLE 버전 사용 권장.

높이/너비 노드를 "Dimension" 노드로 대체. 이 노드가 비디오 크기를 제어함 (기본값 = 768. 1024로 증가하면 해상도 향상, 그러나 움직임은 감소하고 VRAM 및 시간 소요 증가). 이전 버전과 달리 이미지가 자르기되지 않음.

새 노드 "LTX Apply Perturbed Attention" 추가 (STG 설정 표현. 값 및 제한 사항은 워크플로우 내 설명 참고)

ENHANCED 버전은 입력 이미지를 업스케일할지 여부(true/false)를 선택하는 스위치와, 이미지 주입 전 크기를 정의하는 스케일 값(1 또는 2 사용)이 포함됨. 이는 슈퍼샘플링과 유사한 효과를 낼 수 있음. 대부분의 경우 불필요함.

프로 팁: 움직임을 유도하려면 CRF 값을 약 24로 설정하는 것 외에도, 노란색 "Video Combine" 노드의 프레임 속도를 1에서 4 이상으로 증가시키세요. 결과가 너무 정지 상태일 때 움직임을 더 크게 유도할 수 있음.

노드 "Modify LTX Model"은 세션 내에서 모델을 변경합니다. 다른 워크플로우로 전환할 때는 **ComfyUI에서 "Free model and node cache"**를 클릭하여 충돌을 방지하세요. 이 노드를 우회하면(Strg-B) Text2Video가 가능함.

V2.0: Florence2 자동 캡션을 사용한 이미지에서 비디오로의 ComfyUI 워크플로우 (v2.0)

이 업데이트된 워크플로우는 v1.0의 BLIP을 대체하여 Florence2를 자동 캡션에 통합하고, 비디오 생성에 특화된 프롬프트 조정을 위한 개선된 제어 기능을 포함함.

v2.0의 새 기능

Florence2 노드 통합

캡션 사용자 정의

- 새 텍스트 노드를 통해 캡션의 "photo" 또는 "image" 같은 단어를 "video"로 교체하여 프롬프트를 비디오 생성에 더 잘 맞춤화함.

V1.0: 압축을 통한 움직임 강화

LTX 비디오 모델의 "움직임 없음" 아티팩트 완화:

입력 이미지를 FFmpeg를 사용하여 H.264 압축(CRF 20–30)으로 통과시킵니다.

이 단계는 미세한 아티팩트를 도입하여 모델이 입력을 비디오처럼 인식하도록 돕습니다.

CRF 값은 노란색 "Video Combine" 노드(왼쪽 하단 GUI)에서 조정 가능합니다.

높은 값(25–30)은 움직임 효과를 증가시키고, 낮은 값(~20)은 시각적 품질을 더 잘 유지합니다.

자동 캡션 강화

Pre-Text 및 After-Text 텍스트 노드를 통해 캡션에 수동으로 추가할 수 있음.

- 카메라 움직임과 같은 원하는 효과를 설명하는 데 사용하세요.

조정 가능한 입력 설정

- 너비/높이 및 스케일: 샘플러를 위한 이미지 해상도 정의 (예: 768×512). 스케일 팩터 2는 고화질 출력을 위한 초샘플링을 가능하게 함. 스케일 값은 1 또는 2 사용. (V3에서 Dimension 노드로 변경됨)

프로 팁

움직임 최적화: 출력이 정지 상태로 느껴지면 CRF 및 프레임 속도 값을 점진적으로 증가시키거나, Pre-/After-Text 노드를 조정하여 움직임 관련 프롬프트를 강조하세요.

캡션 세분화: Florence2의 캡션 세부 수준을 실험하여 정교한 비디오 프롬프트를 생성하세요.

메모리 문제(OOM 또는 극심한 처리 시간) 발생 시 다음을 시도하세요:

V5의 LowVram 버전 사용

GGUF 버전 사용

ComfyUI에서 "free model and node cache" 클릭

ComfyUI 시작 인자에 --lowvram --disable-smart-memory 추가

- ComfyUI 폴더 내 파일 "run_nvidia_gpu.bat"에서 다음 줄 편집: python.exe -s ComfyUI\main.py --lowvram --disable-smart-memory

브라우저의 하드웨어 가속 기능을 끕니다.

감사의 인사를 Lightricks에게 전합니다. 뛰어난 모델 및 노드를 제공해 주셔서 감사합니다: