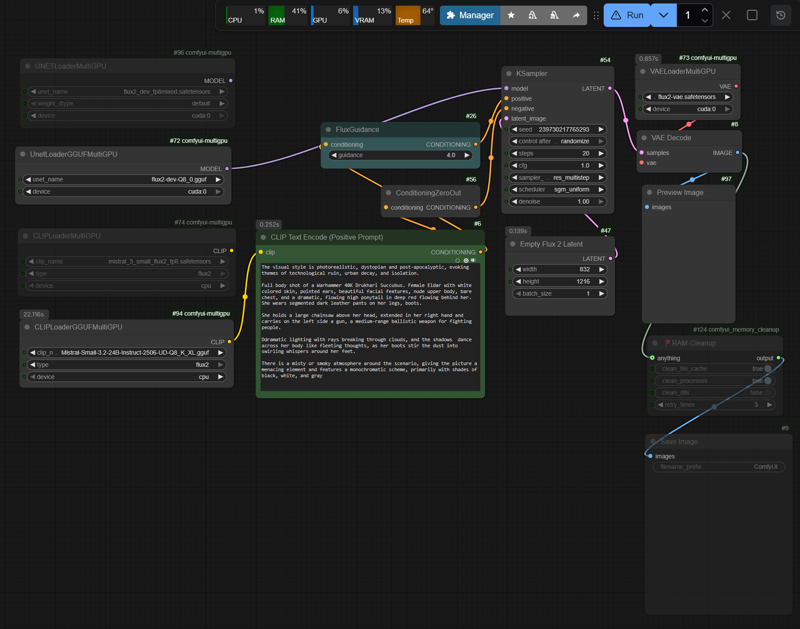

Simplified t2i Workflow for Flux2D

詳細

ファイルをダウンロード

モデル説明

ワークフローは、VRAM(RAM)の割り当てを制御し、VRAMオーバーフローおよびその結果のスワッピングを防ぐために、DisTorch2MultiGPUv2 ノード上で実行する必要があります。しかし、これらのノードは最新のComfyUI更新により現在動作しません。代替手段として、古いMultiGPUv1ノードを使用しています(DisTorch2と比較して最大で10–15%の推論速度低下)。

GitHub: pollockjj/ComfyUI-MultiGPU

システムに動作するSageAttention環境が整っている場合、利用可能なVRAM(RAM)に応じて、fp8.safetensorsを使用したワークフローは問題なく実行できます。

GGUFの場合:

SageAttentionによる高速化はFP8モデルと比較して著しく低く、GGUFフォーマットは主にCPU最適化推論を目的としているため、SageAttentionのGPUカーネルを十分に活用できないため、効果が全く発揮されないこともあります。

-> --use-sage-attention を無効化

-> --fast(標準的なPyTorch最適化)を使用

-> GGUFノード(バックエンド)の内部最適化に依存

RTX30xx、RTX40xx(およびRTX50xx)でVRAMが24GB未満のシステムについては、私のHF/モデルページにある表「Quick Reference: FLUX.2 + Mistral-3-Small GGUF」を参照してください。

GegenDenTag/comfyUI-Flux2D-t2i-workflow · Hugging Face

ここでは、メモリ管理、run_nvidia_gpu.bat、SageAttentionのインストールガイド、およびいくつかのCMDコンソール出力(以下のパフォーマンスを参照)についての注記も見つかります。

パフォーマンス

テスト環境:RTX3090 24GB VRAM + 32GB RAM

Flux2 fp8mixed.safetensors Nvidia(35.5GB)、Mistral Text Encoder fp8.safetensors(18GB)

Flux2 Q8_0(35GB)、Mistral Text Encoder Q8_K(29GB)

flux2-vae.safetensors(336MB)

ガイダンス:4 | ステップ:20(実用:ガイダンス 2–2.5、ステップ 30–40)

基準:異なる解像度で約80回の実行

最初の実行:必要なレイヤーをVRAM/RAMに初期ロードし、最初の推論。その後の推論は、メモリ管理が既に初期化されているため、大幅に高速化されます。正確な時間やロード状況などは、コンソール出力/スクリーンショットを参照してください。

FP8フォーマット

最初の実行

- 832×1216px:約380–400秒

以降の実行:

832×1216px:75–80秒(約3.70–3.90秒/イテレーション)

1080×1920px:135–150秒(約6.75–7.50秒/イテレーション)

1440×2160px:225–240秒(約11.00–11.50秒/イテレーション)

GGUFフォーマット(予想通り実行時間が長め)

最初の実行

- 832×1216px:約420–440秒

以降の実行:

832×1216px:105–120秒(約5.30–5.50秒/イテレーション)

1440×2160px:250–260秒(約12.00–12.75秒/イテレーション)

付録:サンプル画像にはメタデータが埋め込まれていません。私はn8n-upscayl_1440px_ultrasharp-4xでワークフローを自動化して実行していますが、アップスケーラーがメタデータを上書きするのを防ぐことはまだできていません。