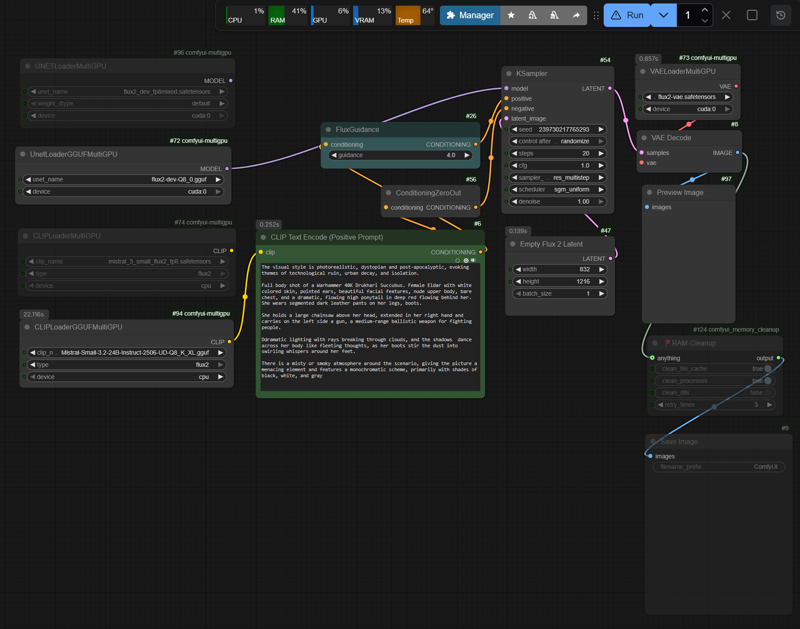

Simplified t2i Workflow for Flux2D

세부 정보

파일 다운로드

모델 설명

워크플로우는 VRAM(RAM) 할당을 제어하여 VRAM 과부하 및 그로 인한 스왑을 방지하기 위해 DisTorch2MultiGPUv2 노드에서 실행되어야 합니다. 그러나 최근 ComfyUI 업데이트로 인해 이러한 노드는 현재 작동하지 않습니다. 대안으로 이전 버전의 MultiGPUv1 노드를 사용합니다(DisTorch2에 비해 최대 10–15% 낮은 추론 속도).

GitHub: pollockjj/ComfyUI-MultiGPU

시스템에 작동하는 SageAttention 환경이 있다면, 사용 가능한 VRAM(RAM)에 따라 fp8.safetensors를 사용한 워크플로우는 문제 없이 실행됩니다.

GGUF 사용 시:

SageAttention이 제공하는 가속은 FP8 모델에 비해 훨씬 낮으며, GGUF 형식은 주로 CPU 최적화 추론을 위해 설계되었고 SageAttention의 GPU 커널을 완전히 활용하지 못하기 때문에 전혀 효과가 없을 수도 있습니다.

-> --use-sage-attention 비활성화

-> --fast 사용(표준 PyTorch 최적화)

-> GGUF 노드의 내장 최적화(백엔드)에 의존

RTX30xx, RTX40xx(및 RTX50xx) 시스템 중 VRAM이 24GB 미만인 경우, 제 Hugging Face 모델 페이지의 표 “빠른 참조: FLUX.2 + Mistral-3-Small GGUF” 를 참조하세요.

GegenDenTag/comfyUI-Flux2D-t2i-workflow · Hugging Face

여기에서는 메모리 관리, run_nvidia_gpu.bat, SageAttention 설치 가이드, 및 일부 CMD 콘솔 출력 결과(성능 참조)에 대한 설명도 확인할 수 있습니다.

성능

테스트 환경: rtx3090 24GB VRAM + 32GB RAM:

Flux2 fp8mixed.safetensors Nvidia (35.5GB), Mistral Text Encoder fp8.safetensors (18GB)

Flux2 Q8_0 (35GB), Mistral Text Encoder Q8_K (29GB)

flux2-vae.safetensors (336MB)

가이던스: 4 | 스텝: 20 (실제 사용: 가이던스 2-2.5, 스텝 30-40)

기준: 약 80회 다양한 해상도로 실행

첫 번째 실행: 필요한 레이어를 VRAM/RAM에 처음 로드하고 첫 번째 추론 실행; 이후 추론은 메모리 관리가 이미 초기화되어 훨씬 빠릅니다. 정확한 시간, 부분 로딩 등은 콘솔 출력/스크린샷을 참조하세요.

FP8 형식

첫 번째 실행

- 832×1216px: ~380-400초

후속 실행:

832×1216px: 75-80초 (~3.70-3.90초/it)

1080×1920px: 135-150초 (~6.75-7.50초/it)

1440×2160px: 225-240초 (~11.00-11.50초/it)

GGUF 형식(기대되는 더 긴 실행 시간)

첫 번째 실행

- 832×1216px: ~420-440초

후속 실행:

832×1216px: 105-120초 (~5.30-5.50초/it)

1440×2160px: 250-260초 (~12.00-12.75초/it)

부가 설명: 샘플 이미지에는 메타데이터가 포함되어 있지 않습니다. 저는 Automation n8n-upscayl_1440px_ultrasharp-4x에서 워크플로우를 실행 중이며, 업스케일러가 메타데이터를 덮어쓰는 것을 막지는 못했습니다.