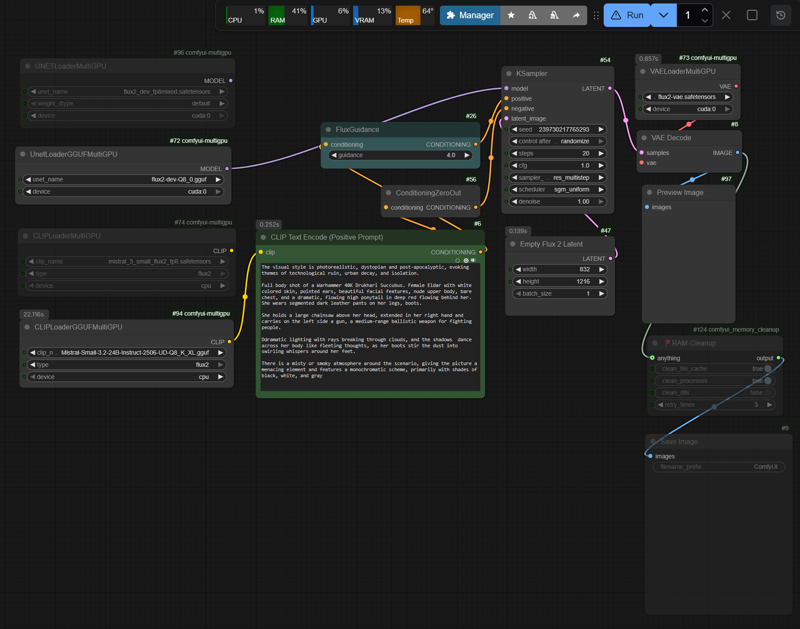

Simplified t2i Workflow for Flux2D

详情

下载文件

模型描述

工作流应运行在 DisTorch2MultiGPUv2 节点上,以控制 VRAM(内存)分配,防止 VRAM 溢出和随之而来的交换。不幸的是,由于最新的 ComfyUI 更新,这些节点目前存在故障。作为替代方案,使用较旧的 MultiGPUv1 节点(与 DisTorch2 相比,推理速度最高降低 10–15%)。

GitHub:pollockjj/ComfyUI-MultiGPU

如果您的系统已成功配置 SageAttention,则使用 fp8.safetensors 的工作流应能顺利运行,具体取决于可用的 VRAM(内存)。

使用 GGUF 格式时:

SageAttention 提供的加速效果远低于 FP8 模型,

有时甚至完全无效,因为 GGUF 格式主要为 CPU 优化推理设计,

并未充分利用 SageAttention 的 GPU 内核。

-> 禁用 --use-sage-attention

-> 使用 --fast(标准 PyTorch 优化)

-> 依赖 GGUF 节点(后端)的内部优化

对于 RTX30xx、RTX40xx(及 RTX50xx) 系统且 VRAM 小于 24 GB 的情况,请参阅我 Hugging Face 模型页面上的表格 “快速参考:FLUX.2 + Mistral-3-Small GGUF”。

GegenDenTag/comfyUI-Flux2D-t2i-workflow · Hugging Face

您还可在那里找到有关内存管理、run_nvidia_gpu.bat、SageAttention 安装指南 以及一些 CMD 控制台输出的说明(性能如下所示)。

性能

测试环境:RTX3090 24GB VRAM + 32GB RAM:

Flux2 fp8mixed.safetensors Nvidia(35.5GB),Mistral 文本编码器 fp8.safetensors(18GB)

Flux2 Q8_0(35GB),Mistral 文本编码器 Q8_K(29GB)

flux2-vae.safetensors(336MB)

指导强度:4 | 步数:20(生产环境:指导强度:2-2.5,步数:30-40)

基于:约 80 次不同分辨率的运行

首次运行:将所需层首次加载至 VRAM/内存,执行第一次推理;后续推理速度显著提升,因为内存管理已初始化。具体时间、部分加载等信息请参阅控制台输出/截图。

FP8 格式

首次运行

- 832×1216px:~380-400 秒

后续运行:

832×1216px:75-80 秒(~3.70-3.90 秒/步)

1080×1920px:135-150 秒(~6.75-7.50 秒/步)

1440×2160px:225-240 秒(~11.00-11.50 秒/步)

GGUF 格式(预期运行时间更长)

首次运行

- 832×1216px:~420-440 秒

后续运行:

832×1216px:105-120 秒(~5.30-5.50 秒/步)

1440×2160px:250-260 秒(~12.00-12.75 秒/步)

附注:示例图像中未嵌入任何元数据。我正在使用自动化流程 n8n-upscayl_1440px_ultrasharp-4x 运行该工作流,但尚未成功阻止上采样器覆盖元数据。